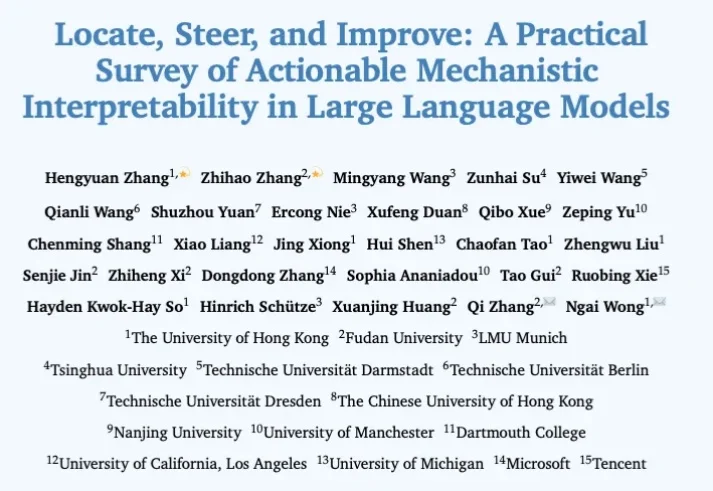

大模型哪里出问题、怎么修,这篇可解释性综述一次讲清

大模型哪里出问题、怎么修,这篇可解释性综述一次讲清过去几年,机制可解释性(Mechanistic Interpretability)让研究者得以在 Transformer 这一 “黑盒” 里追踪信息如何流动、表征如何形成:从单个神经元到注意力头,再到跨层电路。但在很多场景里,研究者真正关心的不只是 “模型为什么这么答”,还包括 “能不能更稳、更准、更省,更安全”。

过去几年,机制可解释性(Mechanistic Interpretability)让研究者得以在 Transformer 这一 “黑盒” 里追踪信息如何流动、表征如何形成:从单个神经元到注意力头,再到跨层电路。但在很多场景里,研究者真正关心的不只是 “模型为什么这么答”,还包括 “能不能更稳、更准、更省,更安全”。

今天,据彭博社报道,美国Vibe Coding(氛围编程)独角兽Replit即将完成一笔新的融资交易,计划筹集大约4亿美元(约合人民币27.87亿元)的资金,其投后估值或将达到约90亿美元(约合人民币627.15亿元),大约是上轮融资时估值的3倍。

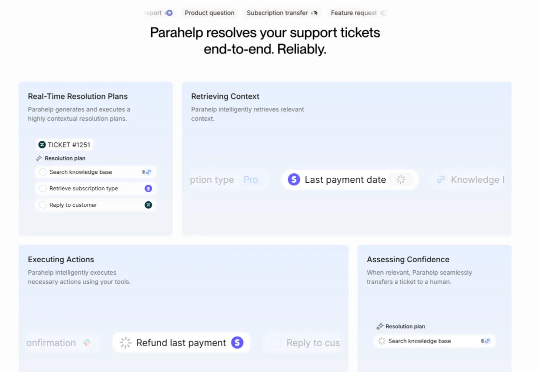

“99%的企业级 Agent 都只是玩具!”

他们不光能造GPU,还能写出全球顶级的算法!摩尔线程这次开源给国产具身智能递了一把「神兵利器」。

最近,这家由两位丹麦年轻创始人打造的公司宣布完成了 1800 万美元的 A 轮融资,由 Alt Capital 的 Jack Altman 领投。加上此前 320 万美元的种子轮,Parahelp 总共融资超过 2100 万美元。更有意思的是,他们的客户流失率为零。是的,你没看错,零流失率。在 SaaS 领域,这几乎是不可能完成的任务。这让我非常好奇:他们到底做对了什么?

人需要的不是功能,而是情感连接。

在大模型研究领域,做混合专家模型(MoE)的团队很多,但专注机制可解释性(Mechanistic Interpretability)的却寥寥无几 —— 而将二者深度结合,从底层机制理解复杂推理过程的工作,更是凤毛麟角。

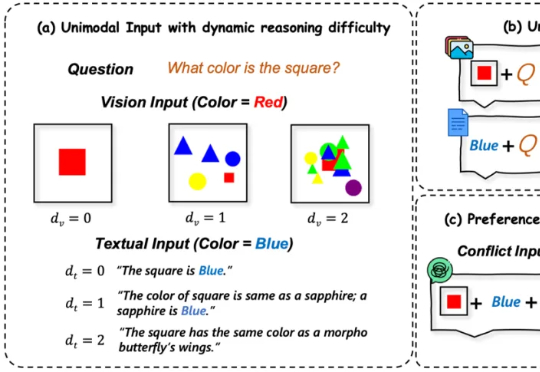

多模态大语言模型(MLLMs)在处理来自图像和文本等多种来源的信息时能力强大 。 然而,一个关键挑战随之而来:当这些模态呈现相互冲突的信息时(例如,图像显示一辆蓝色汽车,而文本描述它为红色),MLLM必须解决这种冲突 。模型最终输出与某一模态信息保持一致的行为,称之为“模态跟随”(modality following)

“用户”这个身份从人类转移到了Agent本身。换句话说,现在真正写代码的“程序员”,已经不再是人类,而是AI。

2025年11月4日,一家总部位于英国伦敦的人工智能公司Stability AI,赢得了一项具有里程碑意义的高等法院案件,该案审查了人工智能模型在未经许可的情况下使用大量受版权保护数据的合法性。而本案的原告,Getty Images 在针对人工智能公司 Stability AI 图像生成产品的英国诉讼中基本败诉。