租了8张H100,他成功复现了DeepSeek的mHC,结果比官方报告更炸裂

租了8张H100,他成功复现了DeepSeek的mHC,结果比官方报告更炸裂元旦期间,DeepSeek 发布的 mHC 震撼了整个 AI 社区。

元旦期间,DeepSeek 发布的 mHC 震撼了整个 AI 社区。

预测到次贷危机的「大空头」Michael Burry看到数万亿美元涌入AI基础设施,产生深深的怀疑。他预言:英伟达的优势并不持久,可能很快就会被对手战胜。而且,如今全球AI算力已经达到1500万H100 GPU当量,即将引爆严重能源危机!

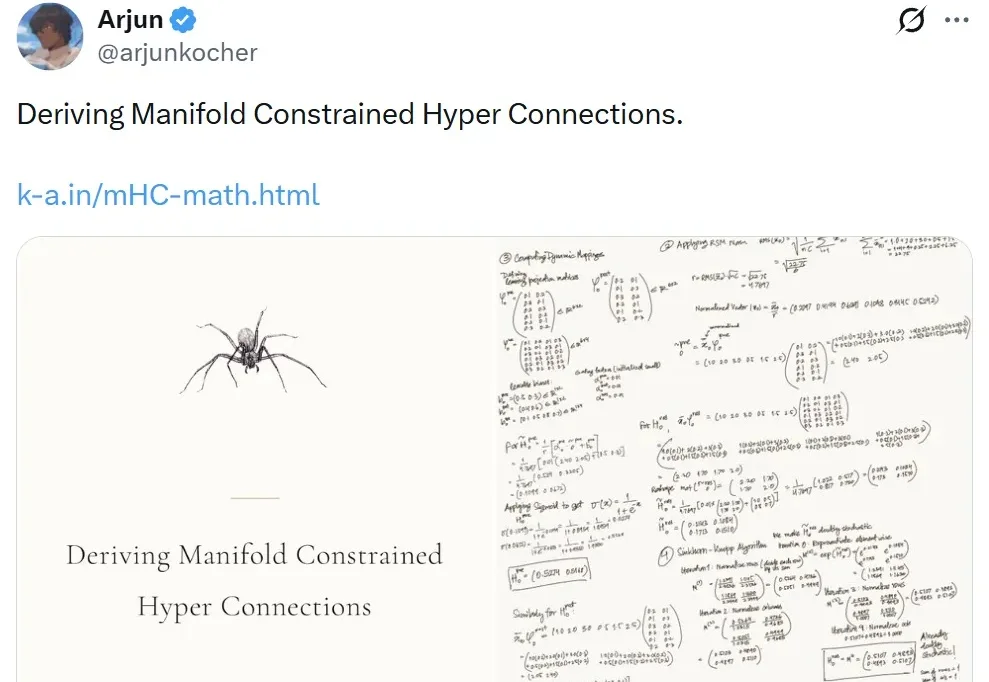

见证历史!今天,首个由H100太空GPU训出LLM诞生了,它基于Karpathy nano-GPT训练。不仅如此,谷歌Gemma也在太空成功运行,向世界发出首句问候:地球人,你好。

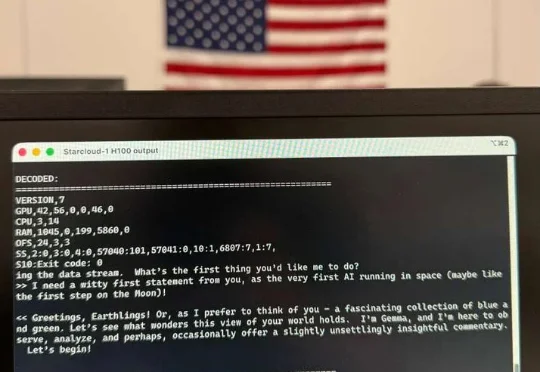

地面上的算力“内卷”,终于突破了大气层的束缚。前脚,装有英伟达H100的Starcloud-1卫星搭乘SpaceX的猎鹰9号火箭成功进入轨道,迈出构建“太空超算”的关键一步。谷歌紧随其后,火速披露了部署搭载TPU卫星集群的“太阳捕手”计划(Project Suncatcher)。

在AI数据中心里,数以万计的英伟达H100 GPU,正静静地躺在地上吃灰。这些单价3万美元、被黄仁勋称为「工业黄金」的芯片,本该全速运转,为GPT-5或Sora注入灵魂,但此刻——它们没有电。

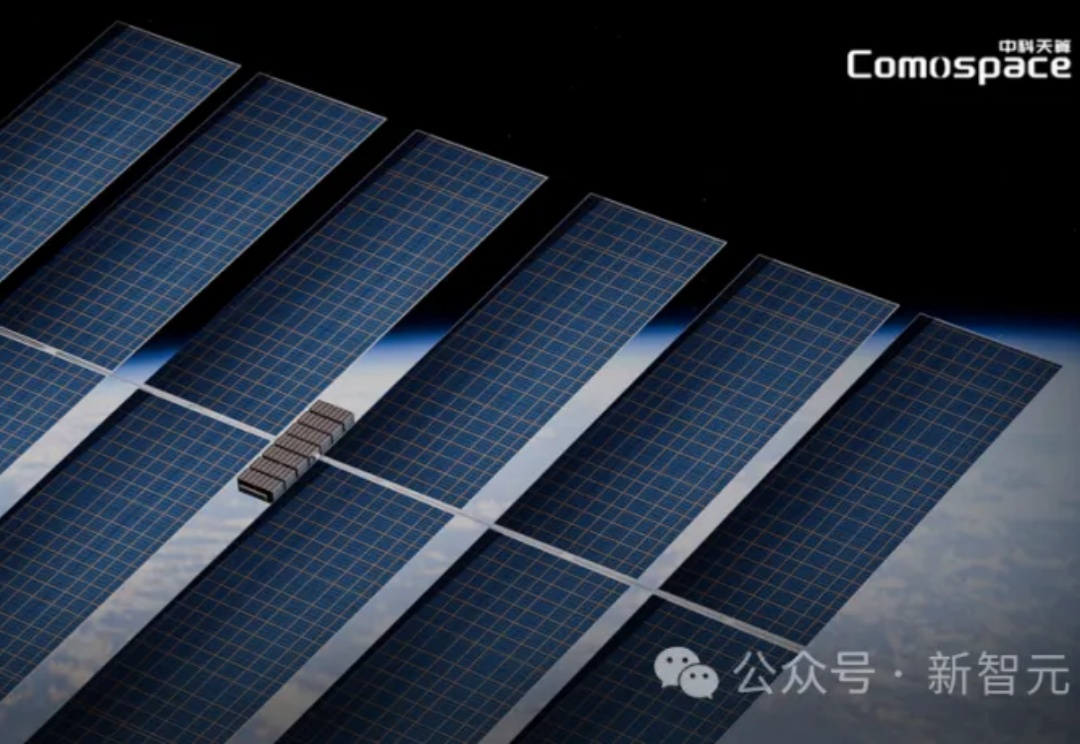

当美国把H100送进轨道试图复制「太空数字霸权」时,中国创业团队的「天算计划」正以万卡级超算中心为剑,在真空与辐射的绝境中找到一条掌握人类数字命运的新路。

英伟达和谷歌,抢着上天了!

地球现在连显卡都供不起了,微软的GPU插不进机房。英伟达的H100直接飞向太空。

11 月 2 日,英伟达首次把 H100 GPU 送入了太空,参阅报道《英伟达发射了首个太空 AI 服务器,H100 已上天》。而刚刚谷歌宣布,他们也要让 TPU 上天。

11 月 2 日,英伟达首次把 H100 GPU 送入了太空。作为目前 AI 领域的主力训练芯片,H100 配备 80GB 内存,其性能是此前任何一台进入太空的计算机的上百倍。在轨道上,它将测试一系列人工智能处理应用,包括分析地球观测图像和运行谷歌的大语言模型(LLM)。