GPT-4 API曝出重大漏洞!15个样本微调,一句prompt秒生恶意代码供出私人信息

GPT-4 API曝出重大漏洞!15个样本微调,一句prompt秒生恶意代码供出私人信息即便是GPT-4 API「灰盒」也逃不过安全漏洞。FAR AI实验室的团队从微调、函数调用、搜索增强三个方向入手,成功让GPT-4越狱。

即便是GPT-4 API「灰盒」也逃不过安全漏洞。FAR AI实验室的团队从微调、函数调用、搜索增强三个方向入手,成功让GPT-4越狱。

微软默默地推出了安卓版本的Copilot,可以免费使用GPT-4,甚至还能绕过OpenAI的次数限制。

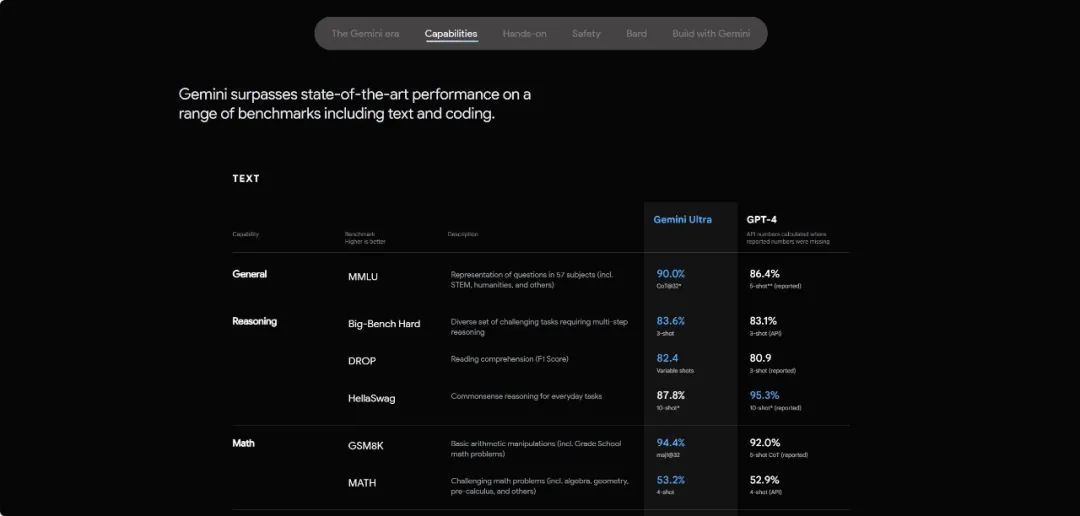

今年咱们新硅编辑部最大的困扰,就是面对各种“超越GPT”的大模型,陷入无尽的沉思。

前段时间的董事会风波还没散尽,OpenAI就在12月的开头自己搞了波热度,

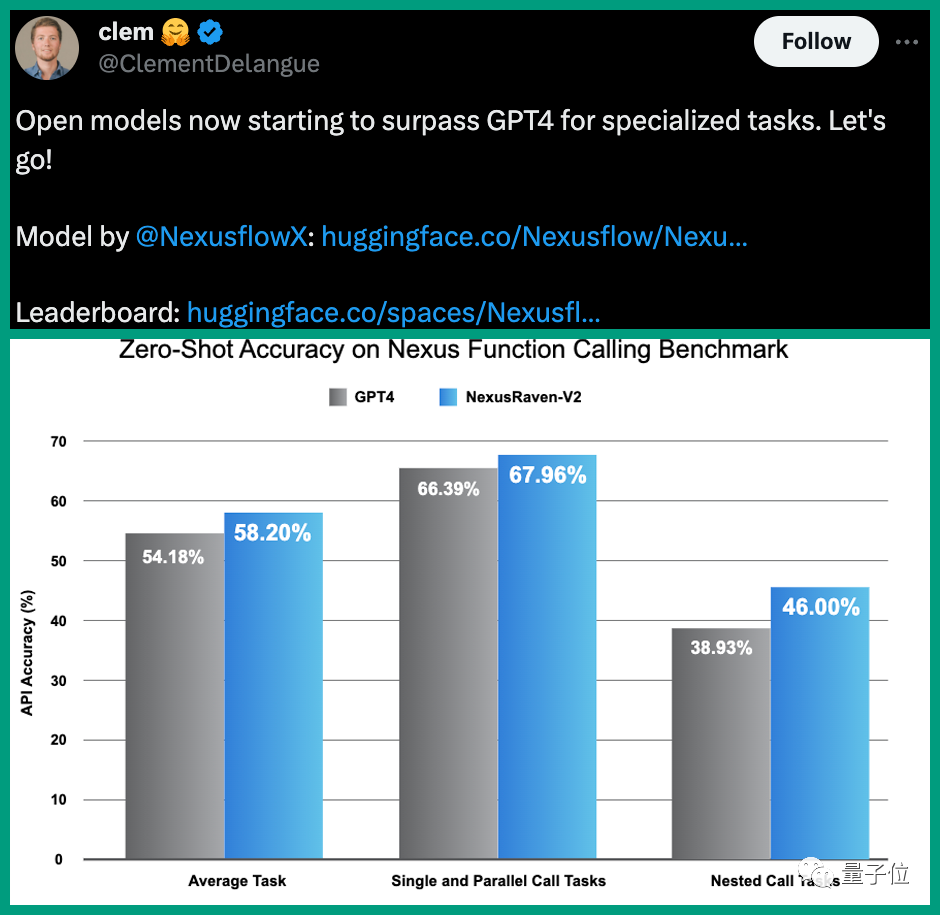

开源模型终于开始超越GPT-4了。

OpenAI GPT-4V 和 Google Gemini 都展现了非常强的多模态理解能力,推动了多模态大模型(MLLM)快速发展,MLLM 成为了现在业界最热的研究方向。

在Gemini开放API不到一周的时间,港中文等机构就完成评测,联合发布了多达128页的报告,结果显示:在37个视觉理解任务上,Gemini-Pro表现出了和GPT-4V相当的能力。

AI颠覆化学研究再次登上Nature!由CMU和Emerald Cloud Lab团队开发的GPT-4加持的AI工具,在不到4分钟的时间成功复现2010年诺奖研究成果。

相比GPT-3,GPT-4 (包括GPT-3.5) 的能力有了非常巨大的进步。这背后其实得益于一个很重要的过程引入:微调。

这个由 GPT-4 驱动的“AI 实验室伙伴”名为 Coscientist,由来自卡内基梅隆大学和 Emerald Cloud Lab 的研究团队共同提出,刚刚登上了权威科学期刊 Nature。