大模型幻觉问题无解?理论证明校准的LM必然会出现幻觉

大模型幻觉问题无解?理论证明校准的LM必然会出现幻觉大型语言模型(LLM)虽然在诸多下游任务上展现出卓越的能力,但其实际应用还存在一些问题。其中,LLM 的「幻觉(hallucination)」问题是一个重要缺陷。

大型语言模型(LLM)虽然在诸多下游任务上展现出卓越的能力,但其实际应用还存在一些问题。其中,LLM 的「幻觉(hallucination)」问题是一个重要缺陷。

最近由UCSC的研究人员发表论文,证明大模型的零样本或者少样本能力,几乎都是来源于对于训练数据的记忆。

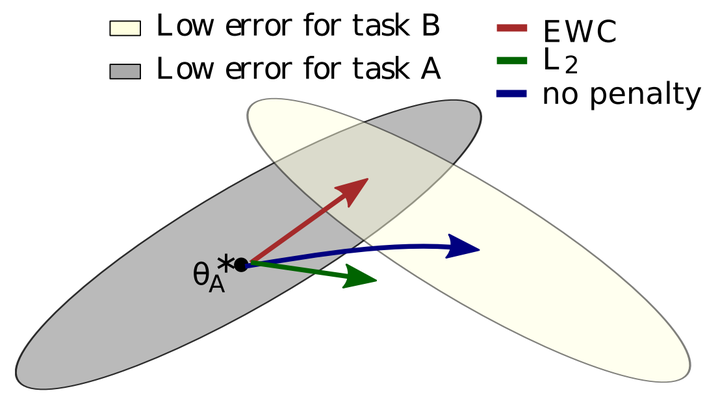

所谓灾难性遗忘,就是一个在原始任务上训练好的神经网络在训练完新任务后,在原始任务上的表现崩溃式的降低。

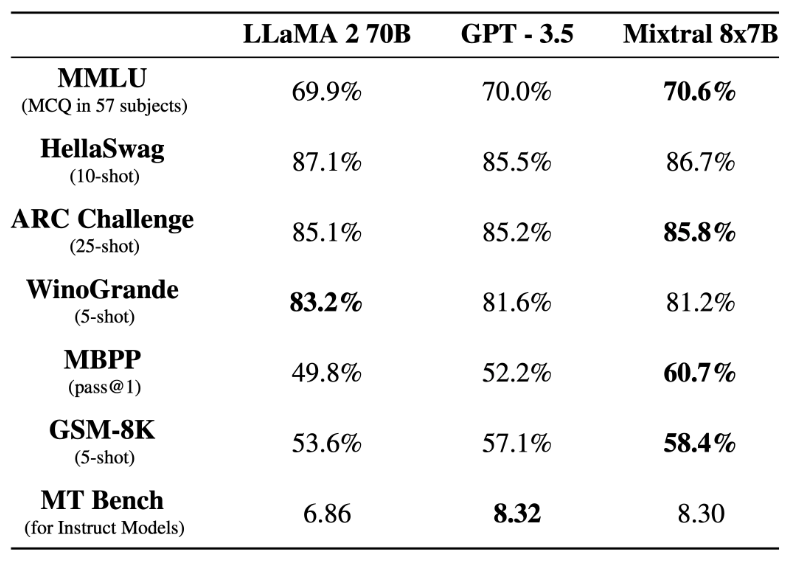

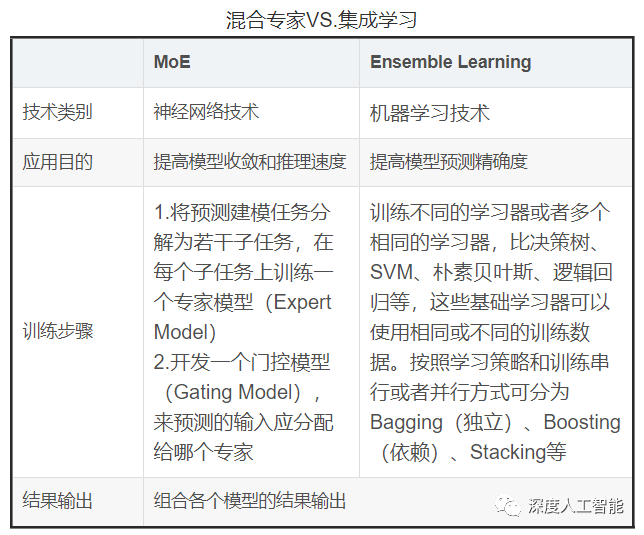

前段时间,Mistral AI 公布的 Mixtral 8x7B 模型爆火整个开源社区,其架构与 GPT-4 非常相似,很多人将其形容为 GPT-4 的「缩小版」。

文明模拟器第二弹来了!在全面升级的GPT-4的带动下,我们将「看到」过去,更加沉浸式地体验过去的历史。

混合专家模型(MoE)成为最近关注的热点。

在2023年的科技版图上,生成式AI无疑标志着一个重要的转折点。它的发展不仅引起了业界广泛的关注,也对全球经济、社会结构乃至我们对未来的预期产生了深远的影响。

今天,纽约时报对OpenAI和微软正式提起诉讼,指控其未经授权就使用纽约时报内容训练人工智能模型。此案可能是人工智能使用知识版权纠纷的分水岭。

在人工智能浪潮中,捍卫自己的权利。当人工智能不断兴起,随之而来的除了惊艳四座的强大技术,还有对技术的质疑以及各种规范的难题。

2023 年是 AI 发展的关键一年,ChatGPT 以及 GPT-4 的发布引发了全社会对于大模型以及生成式 AI 的关注。