Z Tech|独家解读Meta朱泽园开源新基线,用10%算力跑赢Llama3-8B,科学方法引领新范式,语言模型物理学迈入新时代

Z Tech|独家解读Meta朱泽园开源新基线,用10%算力跑赢Llama3-8B,科学方法引领新范式,语言模型物理学迈入新时代《Physics of Language Models(语言模型物理学)》,正是将AI研究带入“物理学范式”的项目,由Meta FAIR研究院的朱泽园概念化发起,并统筹设计。

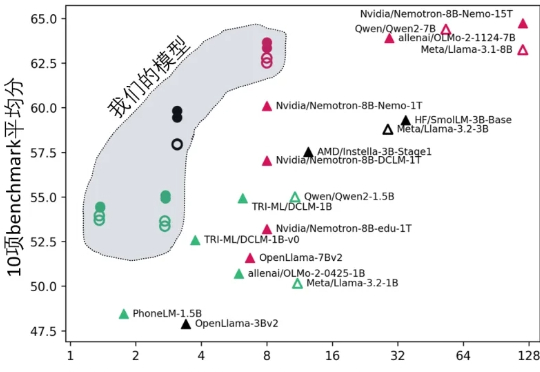

《Physics of Language Models(语言模型物理学)》,正是将AI研究带入“物理学范式”的项目,由Meta FAIR研究院的朱泽园概念化发起,并统筹设计。

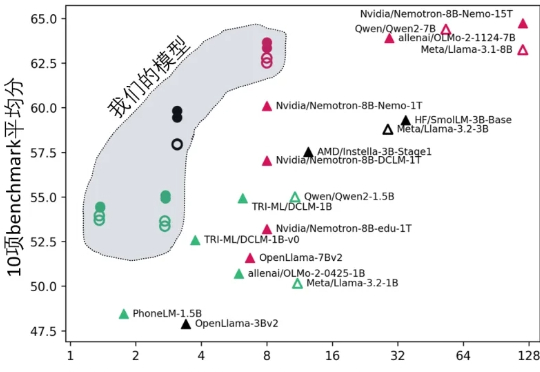

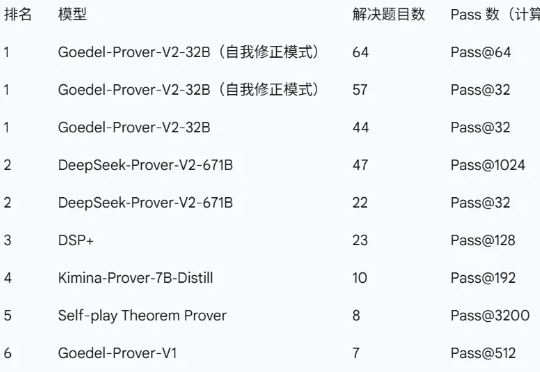

近日,由普林斯顿大学牵头,联合清华大学、北京大学、上海交通大学、斯坦福大学,以及英伟达、亚马逊、Meta FAIR 等多家顶尖机构的研究者共同推出了新一代开源数学定理证明模型——Goedel-Prover-V2。

图灵奖大佬向97年小孩哥汇报,这是什么魔幻剧情?小扎砸143亿请来的「数据标注少年」,已荣升Meta首席AI官。一边是小扎上亿美元年薪offer引进新员工,另一边是Meta老将GPU告急不得不熬夜借卡差点头秃。网友们痛呼:太为Meta FAIR的员工难过了……

在长达数周的高强度「挖角」之后,Meta 今天凌晨宣布正式成立超级智能实验室(Meta Superintelligence Labs,简称 MSL)。Meta CEO 马克·扎克伯格在当时时间周一发布的一封内部信中透露,MSL 将整合公司现有的基础 AI 研究(FAIR)、大语言模型开发以及 AI 产品团队,并组建一个专门研发下一代 AI 模型的新实验室。

北大校友官宣推出号称“最强通用Agent” Fairies(中译仙女),能执行Deep research、代码生成、发邮件等1000个操作。关键是无需邀请码,Mac和Windows用户只需下载APP就能立即上手试玩。(⊙ˍ⊙)

面对谷歌、OpenAI等劲敌猛攻及Llama 4翻车、人才流失困境,小扎决定重组Meta GenAI团队,设AI产品、AGI基础和FAIR三大架构。

只用5%的参数,数学和代码能力竟然超越满血DeepSeek?

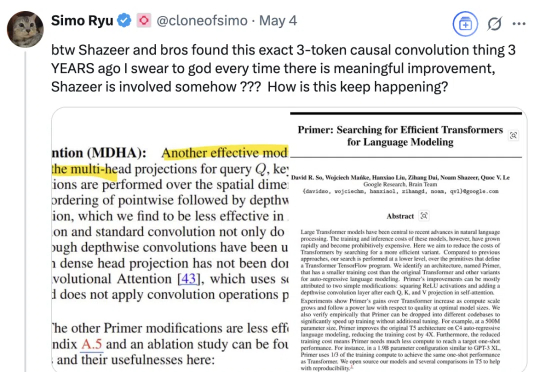

怎么老是你???(How old are you)尤其是最近Meta FAIR研究员朱泽园分享了他们《Physics of Language Models》项目的系列新进展后,有网友发现,其中提到的3-token因果卷积相关内容,沙哥等又早在三年前就有相关研究。这是最近网友不断对着Transformer八子之一的Noam Shazeer(为方便阅读,我们称他为沙哥)发出的灵魂疑问。

Meta FAIR新负责人上任,联合创始人回归:

简单的任务,传统的Transformer却错误率极高。Meta FAIR团队重磅推出多token注意力机制(MTA),精准捕捉复杂信息,带来模型性能飞升!