在文生图(Text-to-Image)和视频生成领域,以FLUX.1、Emu3为代表的扩散模型与自回归模型已经能生成极其逼真的画面。

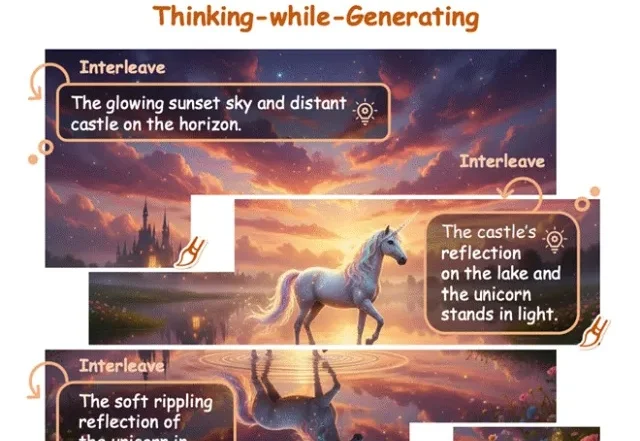

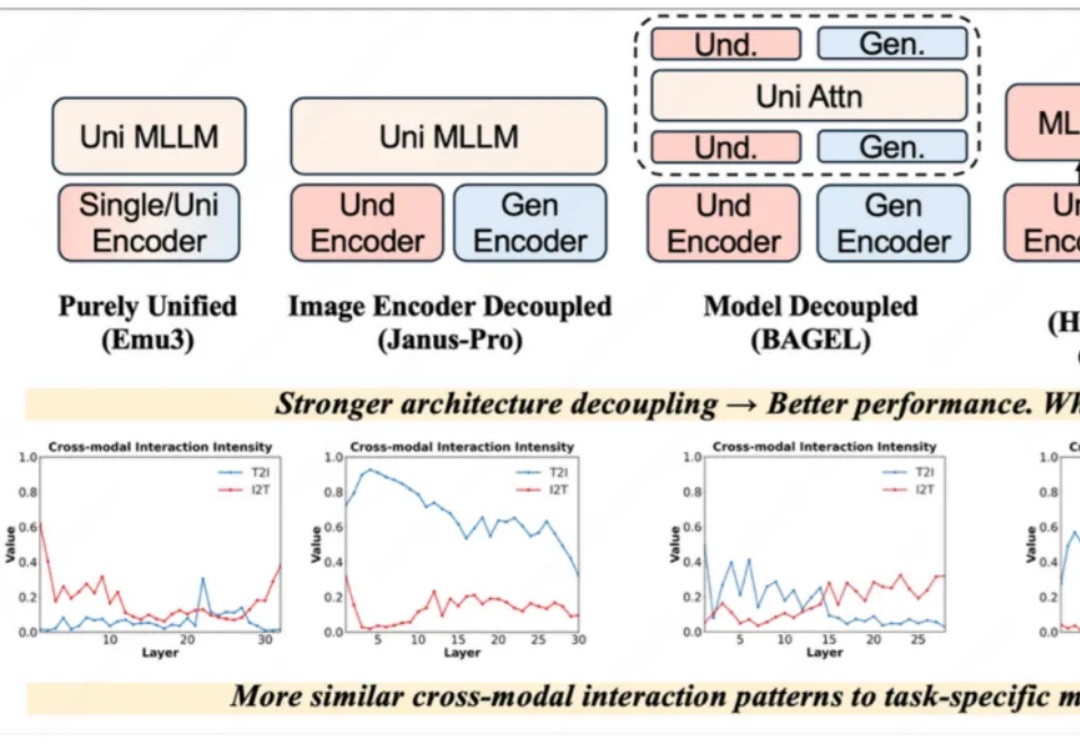

近一年以来,统一理解与生成模型发展十分迅速,该任务的主要挑战在于视觉理解和生成任务本身在网络层间会产生冲突。早期的完全统一模型(如 Emu3)与单任务的方法差距巨大,Janus-Pro、BAGEL 通过一步一步解耦模型架构,极大地减小了与单任务模型的性能差距,后续方法甚至通过直接拼接现有理解和生成模型以达到极致的性能。

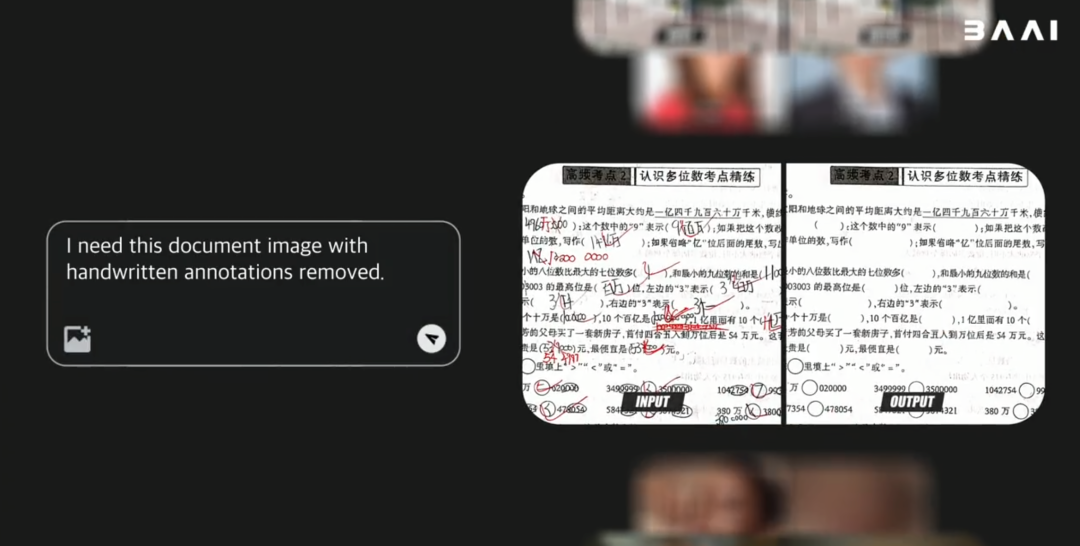

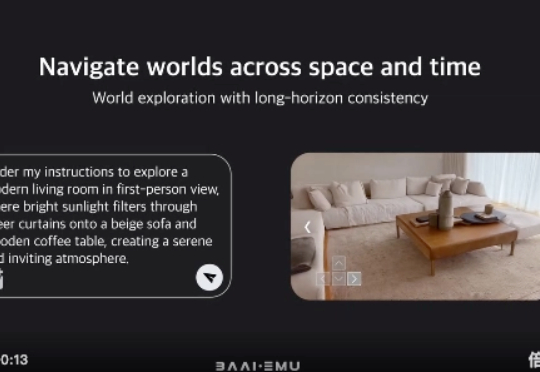

最新最强的开源原生多模态世界模型—— 北京智源人工智能研究院(BAAI)的悟界·Emu3.5来炸场了。 图、文、视频任务一网打尽,不仅能画图改图,还能生成图文教程,视频任务更是增加了物理真实性。

今天,北京智源人工智能研究院(BAAI)重磅发布了其多模态系列模型的最新力作 —— 悟界・Emu3.5。这不仅仅是一次常规的模型迭代,Emu3.5 被定义为一个 “多模态世界大模型”(Multimodal World Foudation Model)。

AI 开始从理解文字,全面进化到建模世界、操控实体、模拟大脑、解构分子。

OpenAI前首席科学家、联合创始人Ilya Sutskever曾在多个场合表达观点: 只要能够非常好的预测下一个token,就能帮助人类达到通用人工智能(AGI)。

OpenAI 前首席科学家、联合创始人 Ilya Sutskever 曾在多个场合表达观点:只要能够非常好的预测下一个 token,就能帮助人类达到通用人工智能(AGI)。