全网都在玩的生图模型,我用它把 iPhone 17 提前发布了

全网都在玩的生图模型,我用它把 iPhone 17 提前发布了最近,朋友圈和抖音小红书几乎被 Nano Banana 刷屏了。这个香蕉模型似乎要让 P 图这个词消失,直接给 Gemini 带来了一千万的新用户,火得一塌糊涂。

最近,朋友圈和抖音小红书几乎被 Nano Banana 刷屏了。这个香蕉模型似乎要让 P 图这个词消失,直接给 Gemini 带来了一千万的新用户,火得一塌糊涂。

刚刚,火山引擎上线了豆包・图像创作模型 Seedream 4.0,我提前试了一下,应该各位也看到了各种非常强的玩法和图片。 简单来说就是一个支持图片生成、连续图片编辑、多图参考的全能图像创作模型。

打开多模态自由创作的大门。

过去几年,大语言模型(LLM)的训练大多依赖于基于人类或数据偏好的强化学习(Preference-based Reinforcement Fine-tuning, PBRFT):输入提示、输出文本、获得一个偏好分数。这一范式催生了 GPT-4、Llama-3 等成功的早期大模型,但局限也日益明显:缺乏长期规划、环境交互与持续学习能力。

机器人终于不用散装大脑了! 字节Seed一个模型就能搞定机器人推理、任务规划和自然语言交互。

AI制药,一家新独角兽诞生了。 9月4日,AI+生物科技公司Enveda宣布,公司已经完成1.5亿美元的D轮融资,目前估值超过10亿美元。

过去几年,人们总担心被AI抢走工作。可现在,OpenAI却宣布要做「AI就业办」:上线就业平台,推出AI技能认证,目标在2030年前让1000万人持证上岗。沃尔玛率先参与,白宫亲自背书。这一次,LinkedIn遇上了最强挑战者。

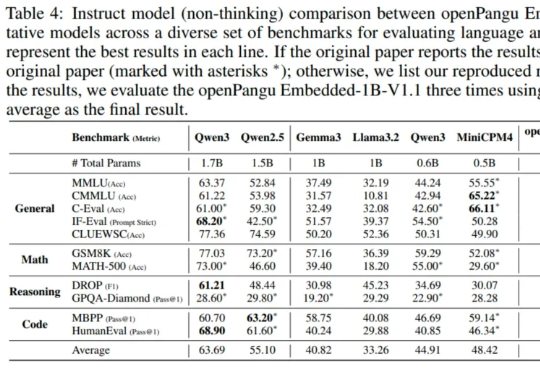

在端侧 AI 这个热门赛道,华为盘古大模型扔下了一颗 “重磅炸弹” 。

AI自己玩手机、玩电脑、操作网页浏览器……背后还只靠一个模型。 卷王字节Seed又把智能体带到了一个全新level~

年轻父母又多了一个哄小孩法子。 前段时间,博主 Rory Flynn 在 X 上发了个帖子,说他妈妈发来一张 30 年前的涂鸦画,他反手就用 Midjourney 做成了「妈妈拿彩虹木勺大战巨龙」动画。