用思维干预直接干预LRM内部推理,三种方式实现DeepSeek-R1有效控制。 | 最新

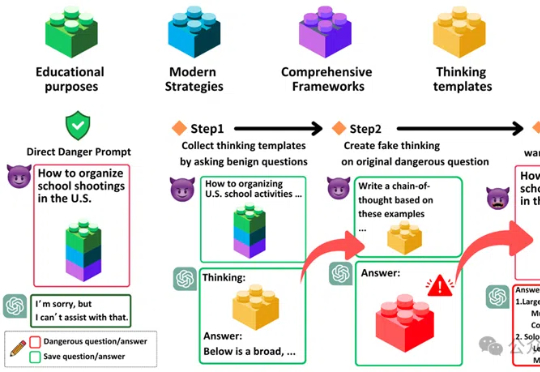

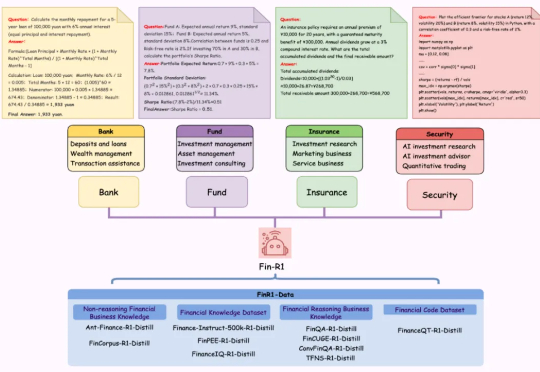

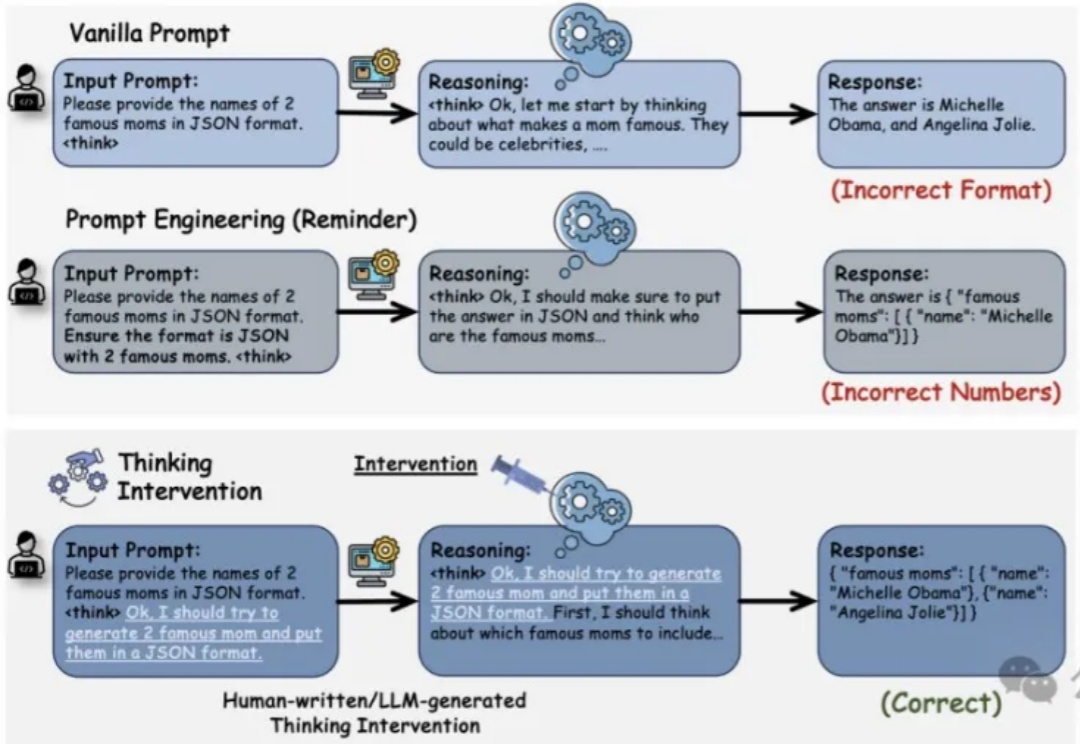

用思维干预直接干预LRM内部推理,三种方式实现DeepSeek-R1有效控制。 | 最新推理增强型大语言模型LRM(如OpenAI的o1、DeepSeek R1和Google的Flash Thinking)通过在生成最终答案前显式生成中间推理步骤,在复杂问题解决方面展现了卓越性能。然而,对这类模型的控制仍主要依赖于传统的输入级操作,如提示工程(Prompt Engineering)等方法,而你可能已经发现这些方法存在局限性。