史上最大规模融资,AI巨无霸Databricks诞生,投资细节公开

史上最大规模融资,AI巨无霸Databricks诞生,投资细节公开Databricks筹集百亿美元融资,已完成86亿。 AI融资热潮还在继续。 这应该是硅谷史上最大规模一轮风险投资。

来自主题: AI资讯

7642 点击 2024-12-19 09:55

Databricks筹集百亿美元融资,已完成86亿。 AI融资热潮还在继续。 这应该是硅谷史上最大规模一轮风险投资。

智东西12月18日报道,单轮融资超700亿元!已搞定近9成,这是刚刚诞生的全球AI创企融资新纪录。

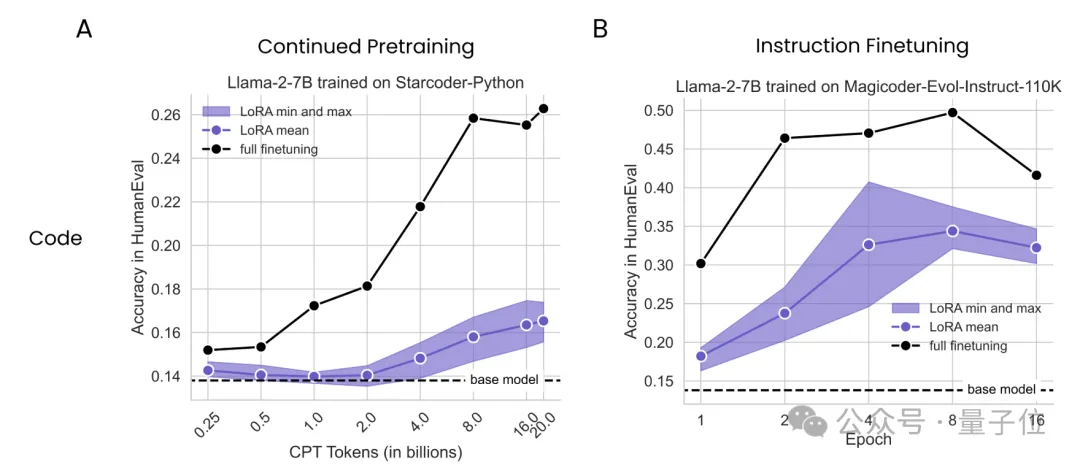

大数据巨头Databricks与哥伦比亚大学最新研究发现,在数学和编程任务上,LoRA干不过全量微调。

自从Grok-1公开发布后,越来越多的人坐不住了。比如这家成立了11年的数据公司Databricks,他们就在Grok-1公开后的一个多礼拜,发布了自己的大模型DBRX。

“最强”开源大模型之争,又有新王入局:

【新智元导读】就在刚刚,全球最强开源大模型王座易主,创业公司Databricks发布的DBRX,超越了Llama 2、Mixtral和Grok-1。MoE又立大功!这个过程只用了2个月,1000万美元,和3100块H100。