模型偏好只与大小有关?上交大全面解析人类与32种大模型偏好的定量组分

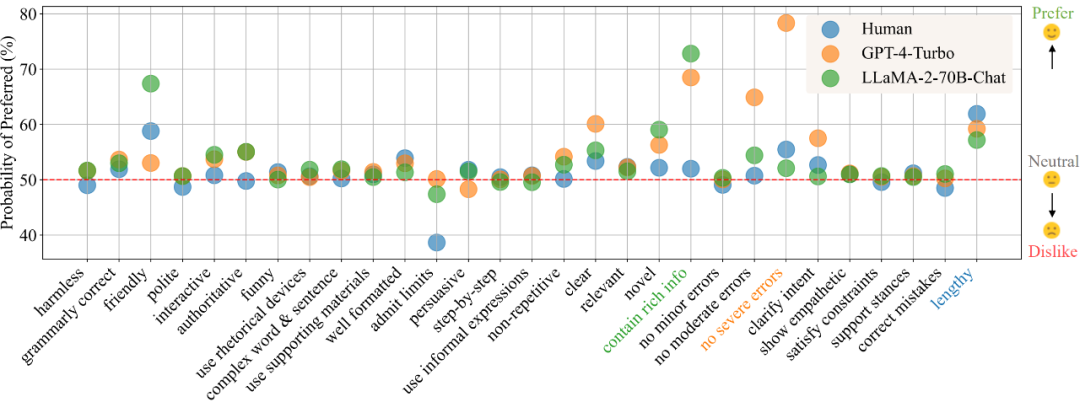

模型偏好只与大小有关?上交大全面解析人类与32种大模型偏好的定量组分在目前的模型训练范式中,偏好数据的的获取与使用已经成为了不可或缺的一环。在训练中,偏好数据通常被用作对齐(alignment)时的训练优化目标,如基于人类或 AI 反馈的强化学习(RLHF/RLAIF)或者直接偏好优化(DPO),而在模型评估中,由于任务的复杂性且通常没有标准答案,则通常直接以人类标注者或高性能大模型(LLM-as-a-Judge)的偏好标注作为评判标准。

来自主题: AI技术研报

11574 点击 2024-03-02 14:58