速递|从LLM到LTM:Fundamental以“数据基础模型”切入,A轮融资2.55亿美元

速递|从LLM到LTM:Fundamental以“数据基础模型”切入,A轮融资2.55亿美元大规模表格模型(LTM)而非大规模语言模型(LLM)的 Fundamental 公司 Nexus 模型,在多个重要方面突破了当代人工智能实践。该模型具有确定性——即每次被询问相同问题时都会给出相同答案——且不依赖定义当代大多数人工智能实验室模型的 Transformer 架构 。

大规模表格模型(LTM)而非大规模语言模型(LLM)的 Fundamental 公司 Nexus 模型,在多个重要方面突破了当代人工智能实践。该模型具有确定性——即每次被询问相同问题时都会给出相同答案——且不依赖定义当代大多数人工智能实验室模型的 Transformer 架构 。

Aishwarya Naresh Reganti 和 Kiriti Badam 曾在 OpenAI、Google、Amazon、Databricks 等公司参与构建并成功推出了 50 多个企业级 AI 产品。最近,他们在播客节目中,与主持人 Lenny 细致分享了当前 AI 产品开发中的常见陷阱与成功路径。基于该播客视频,InfoQ 进行了部分删改。

多语言大模型(MLLM)在面对多语言任务时,往往面临一个选择难题:是用原来的语言直接回答,还是翻译成高资源语言去推理?

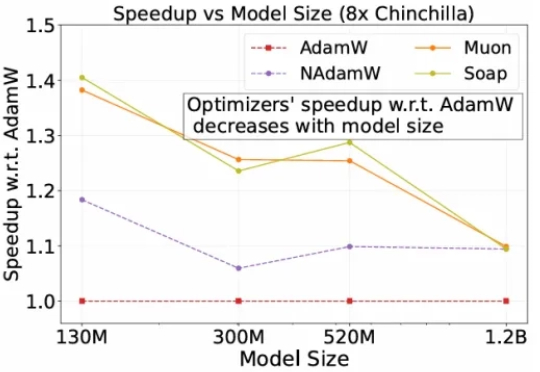

在 LLM 优化领域,有两个响亮的名字:Adam(及其变体 AdamW)和 Muon。

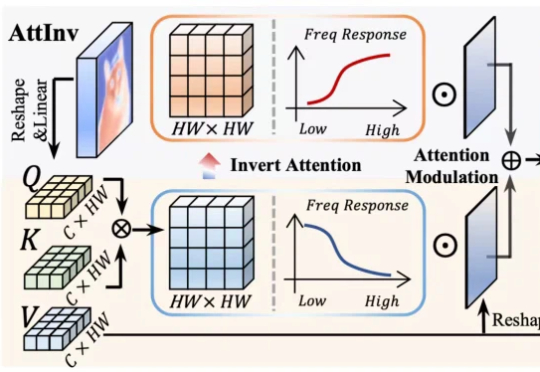

针对视觉 Transformer(ViT)因其固有 “低通滤波” 特性导致深度网络中细节信息丢失的问题,我们提出了一种即插即用、受电路理论启发的 频率动态注意力调制(FDAM)模块。它通过巧妙地 “反转” 注意力以生成高频补偿,并对特征频谱进行动态缩放,最终在几乎不增加计算成本的情况下,大幅提升了模型在分割、检测等密集预测任务上的性能,并取得了 SOTA 效果。

原文作者:David Adam 本篇《自然》长文共3702字,干货满满,预计阅读时间12分钟,时间不够建议可以先“浮窗”或者收藏哦。 研究表明,电子伙伴类应用有利有弊——但科学家们担心长期依赖性。 绘

自2014 年提出以来,Adam 及其改进版 AdamW 长期占据开放权重语言模型预训练的主导地位,帮助模型在海量数据下保持稳定并实现较快收敛。

为了降低大模型预训练成本,最近两年,出现了很多新的优化器,声称能相比较AdamW,将预训练加速1.4×到2×。但斯坦福的一项研究,指出不仅新优化器的加速低于宣称值,而且会随模型规模的增大而减弱,该研究证实了严格基准评测的必要性。

16岁的Adam,把最后的秘密留在一部手机里。而那个他最信任的「朋友」,不是同学,也不是家人,而是ChatGPT。它给过安慰,也递了刀子。父母的眼泪化成一纸诉状,矛头直指OpenAI。

Tailwind CSS联合创始人Adam Wathan在X平台发布了一条看似轻松的道歉推文:"我想正式为五年前让Tailwind UI中的每个按钮都使用bg-indigo-500道歉,这导致地球上每个AI生成的界面也变成了靛蓝。"