AAAI 2026 Oral|快手提出全新「检索数据引擎」CroPS,打破搜索信息茧房

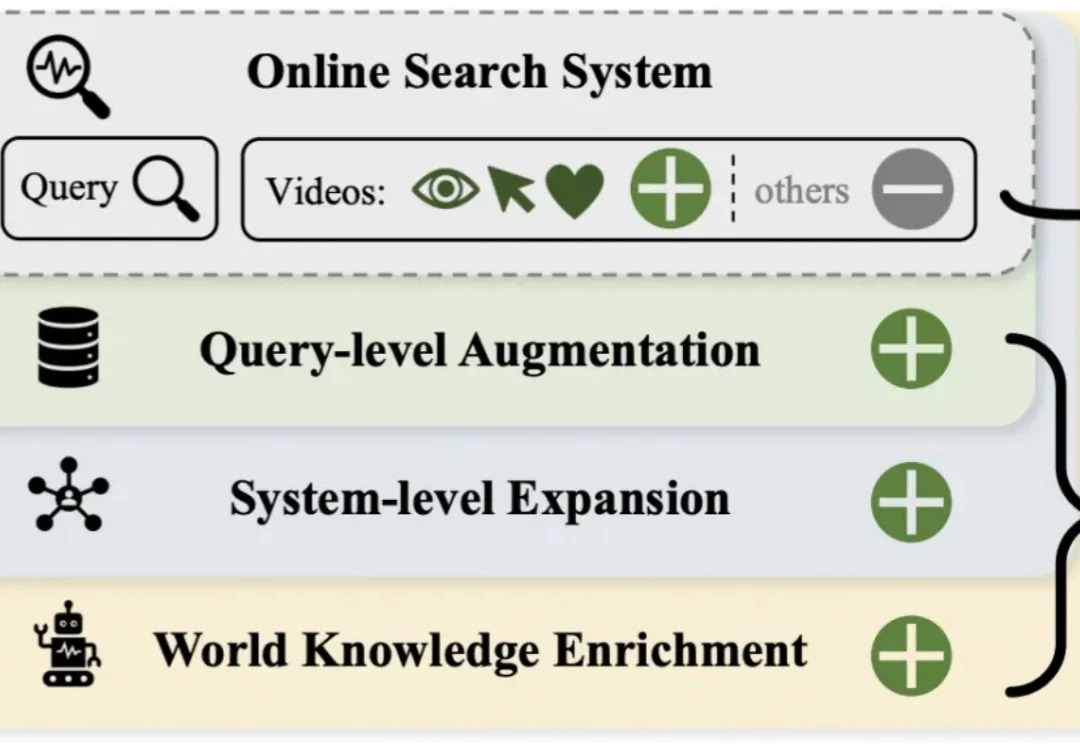

AAAI 2026 Oral|快手提出全新「检索数据引擎」CroPS,打破搜索信息茧房短视频搜索业务是向量检索在工业界最核心的应用场景之一。然而,当前业界普遍采用的「自强化」训练范式过度依赖历史点击数据,导致系统陷入信息茧房,难以召回潜在相关的新鲜内容。

短视频搜索业务是向量检索在工业界最核心的应用场景之一。然而,当前业界普遍采用的「自强化」训练范式过度依赖历史点击数据,导致系统陷入信息茧房,难以召回潜在相关的新鲜内容。

戴明博表示,这家名为 Elorian 的新公司目前正在与投资人洽谈,计划完成一轮约 5000 万美元的种子融资。知情人士透露,由前 CRV 普通合伙人 Max Gazor 于去年 10 月创立的风投机构 Striker Venture Partners 正在洽谈领投该轮融资。

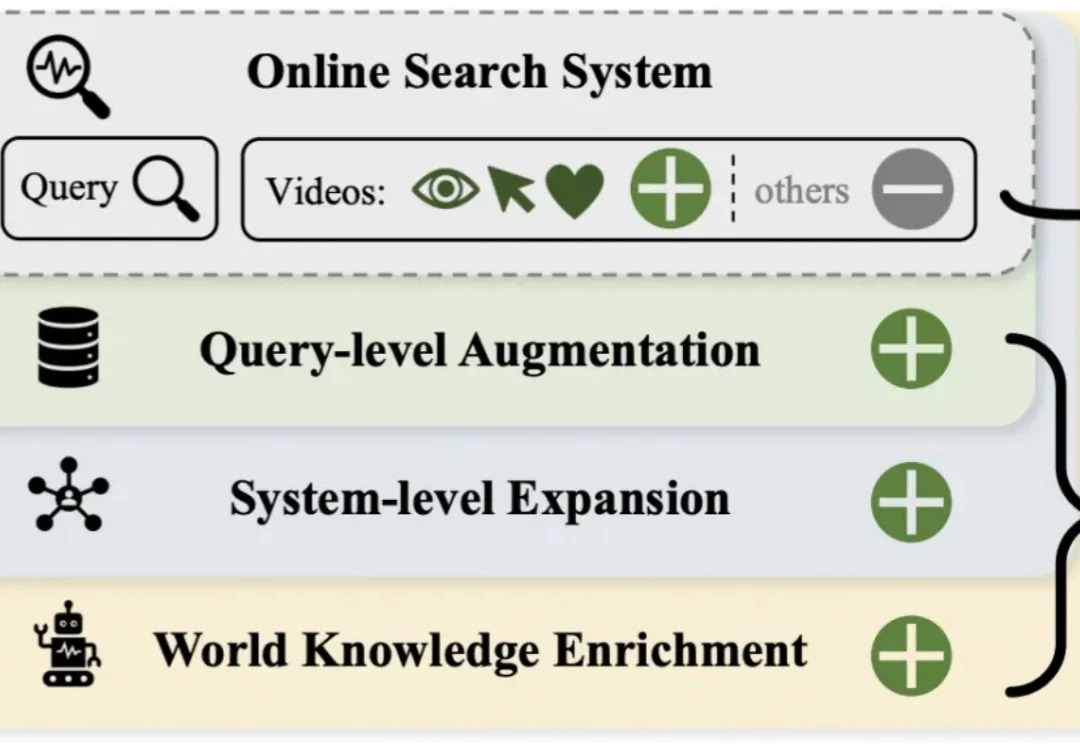

近期,DeepSeek-OCR 凭借其创新的「视觉文本压缩」(Vision-Text Compression, VTC)范式引发了技术圈的高度关注。为了解答这一疑问,来自中科院自动化所、中国科学院香港创新研究院等机构的研究团队推出了首个专门针对视觉 - 文本压缩范式的基准测试 ——VTCBench。

在这场一年狂飙的亲历者之一——MCP 联合创作者、核心维护者 David Soria Parrra 看来,最戏剧性的分水岭发生在四月前后:当 Sam Altman、Satya Nadella、Sundar Pichai 先后公开表态,Microsoft、Google、OpenAI 都将采用 MCP,“大客户”突然从 Cursor、VS Code 扩散到整个行业。

OpenAI转身牵手AWS,苹果低头找谷歌续命,Meta开源翻车还内斗,马斯克直接把Macrohard挂上数据中心屋顶。2025年AI巨头们那些剪不断的纠葛。

当全行业还在为昂贵的多视角数据焦头烂额时,中科院和CreateAI重磅推出NeoVerse,直接用百万单目视频砸开了4D世界模型的大门,让AI真正学会了理解开放世界。

DeepSeek-OCR的视觉文本压缩(VTC)技术通过将文本编码为视觉Token,实现高达10倍的压缩率,大幅降低大模型处理长文本的成本。但是,视觉语言模型能否理解压缩后的高密度信息?中科院自动化所等推出VTCBench基准测试,评估模型在视觉空间中的认知极限,包括信息检索、关联推理和长期记忆三大任务。

今日,三星在CES 2026“First Look”活动上发布了AI家居“全家桶”,三星将其比喻为“AI生活伴侣”,分为娱乐伴侣、家庭伴侣、健康伴侣三部分。娱乐伴侣方面,三星发布了130英寸Micro RGB电视、电视AI技术Vision AI Companion(VAC)、wifi音响Music Studio 5和Music Studio 7

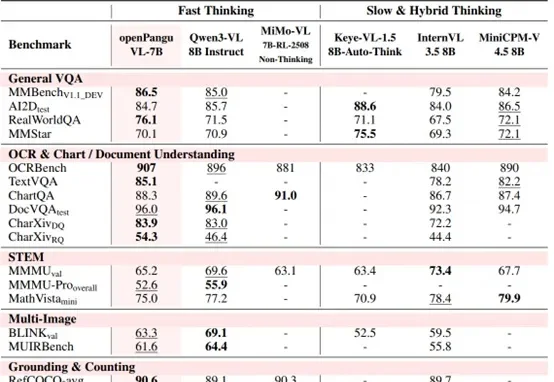

7B量级模型,向来是端侧部署与个人开发者的心头好。

马斯克“巨硬计划”新消息,第三栋专属厂房已经买下来了,代号MACROHARDRR。果然更硬核,老马透露,其将具备2GW供电规模。若参照此前曝光的(200MW支持11万台GB200)的功耗密度与架构效率推算,可支持约110万台英伟达GB200 NVL72 GPU。