只剩5年?诺奖得主Hassabis放出AGI时间表:还差一两个技术突破

只剩5年?诺奖得主Hassabis放出AGI时间表:还差一两个技术突破AGI五年倒计时已开启!Hassabis预测,或许仅需一两个AlphaGo级别的突破,我们就有望在5年内见证AGI降临,而它的速度和影响力将10倍于工业革命。

AGI五年倒计时已开启!Hassabis预测,或许仅需一两个AlphaGo级别的突破,我们就有望在5年内见证AGI降临,而它的速度和影响力将10倍于工业革命。

MemGovern团队 投稿 量子位 | 公众号 QbitAI 人类程序员碰到棘手bug通常会上网查询前辈经验。 当前AI虽然开始具备联网搜索能力,但仍不能很好地从网络经验中获取修复bug的能力。 让

近日,德国物理学家、百万粉丝科普博主Sabine Hossenfelder在一则视频中,抛出了一个让学术界「脊背发凉」的观点:三年内,我们所熟悉的科学研究将不复存在。但AI能力的进化速度,远远超出人类预期。

今早,媒体人Kylie Robison在社交平台X上发文称,据两位知情人士消息,由前OpenAI首席技术官Mira Murati共同创立的知名AI创企Thinking Machines Lab已解雇其首席技术官Barret Zoph,因其“不道德行为”。

允中 发自 凹非寺 量子位 | 公众号 QbitAI 如果你对人形机器人的印象,还停留在——走两步就摔、抓东西像戴着拳击手套、干活前得先写一堆脚本…… 那么MATRIX-3的出现,可能要强行带你“翻篇

BiCo是一种创新的AI视觉内容生成方法,能灵活组合图像和视频中的视觉概念,实现可控编辑。它通过分层绑定器、多样化与吸收机制、时间解耦策略等技术创新,解决了现有方法在概念提取和组合上的问题,让AI真正理解并融合视觉元素。

「每隔 10 到 15 年,计算行业就会革新一次,每次都会催生出新形态的平台。现在,有两个转变在同时进行:应用将会构建于 AI 之上,你构建软件的方式也将改变。」

大模型王座易主Anthropic,太空数据中心成真,「AI泡沫」反成创业红利?2025年底的Y Combinator博客中,谈到了2025 年 AI 领域的四大变局。

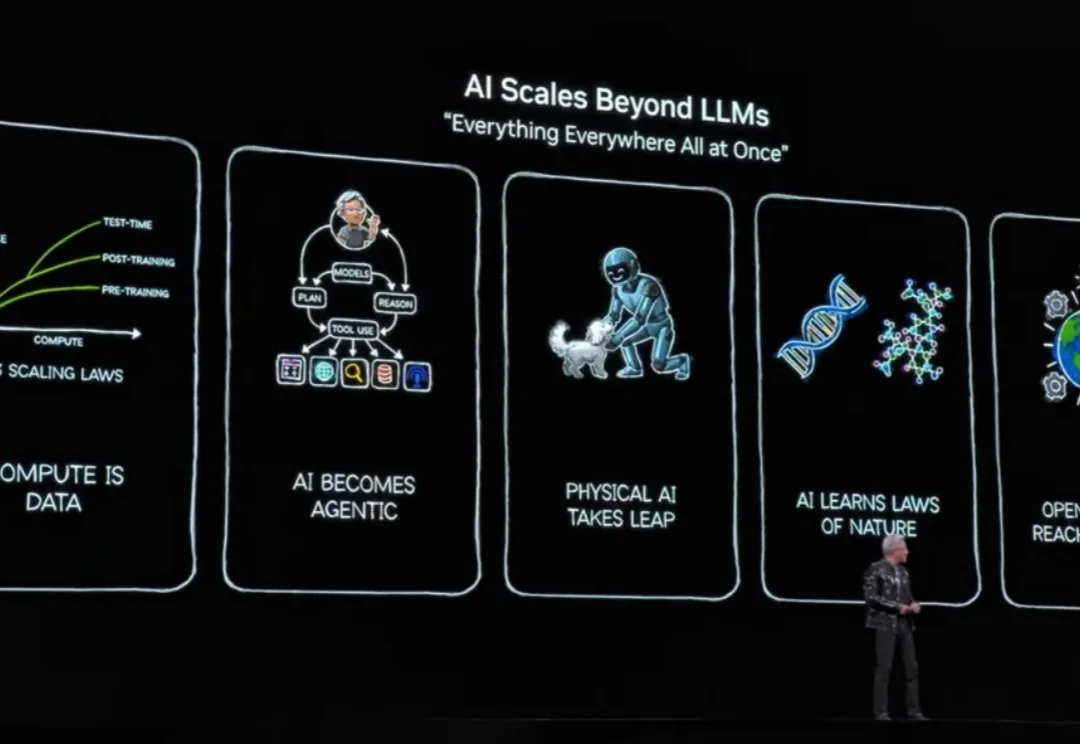

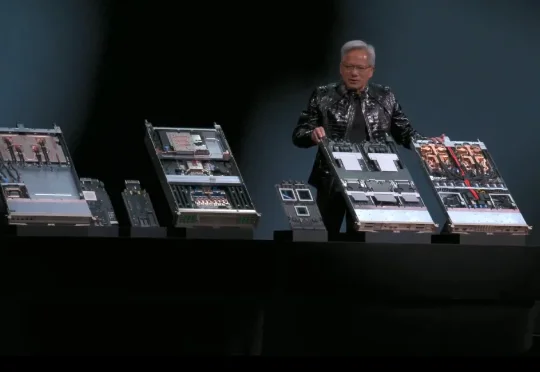

北京时间 1 月 6 日凌晨 5 点多,英伟达创始人兼 CEO 黄仁勋在 CES 2026 发表了主题演讲,演讲核心只有几个字——物理 AI。期间有一页 PPT 暂时没展示出来,他自嘲道演讲场地在拉斯维加斯所以应该是有人中了头奖导致的。期间,他和两台小机器人的互动,成为了本次演讲的名场面之一。

财大气粗的老黄,又要出手了!为了将200多位顶尖AI人才纳入麾下,英伟达被曝拟用20~30亿美金收购一家以色列AI初创公司。这家公司名为AI21 Labs,是以色列为数不多的自主研发大语言模型的公司,其联创还曾创办了明星自动驾驶公司Mobileye(Mobileye被收购后成了英特尔副总裁)。