速递|AI网络内容社区Smashing完成天使轮融资,让用户从不同角度看世界

速递|AI网络内容社区Smashing完成天使轮融资,让用户从不同角度看世界据TechCrunch报道,Smashing 一款由Otis Chandler(Goodreads的联合创始人)推出的新应用,现已向公众开放。

据TechCrunch报道,Smashing 一款由Otis Chandler(Goodreads的联合创始人)推出的新应用,现已向公众开放。

又快又准,即插即用!清华8比特量化Attention,两倍加速于FlashAttention2,各端到端任务均不掉点!

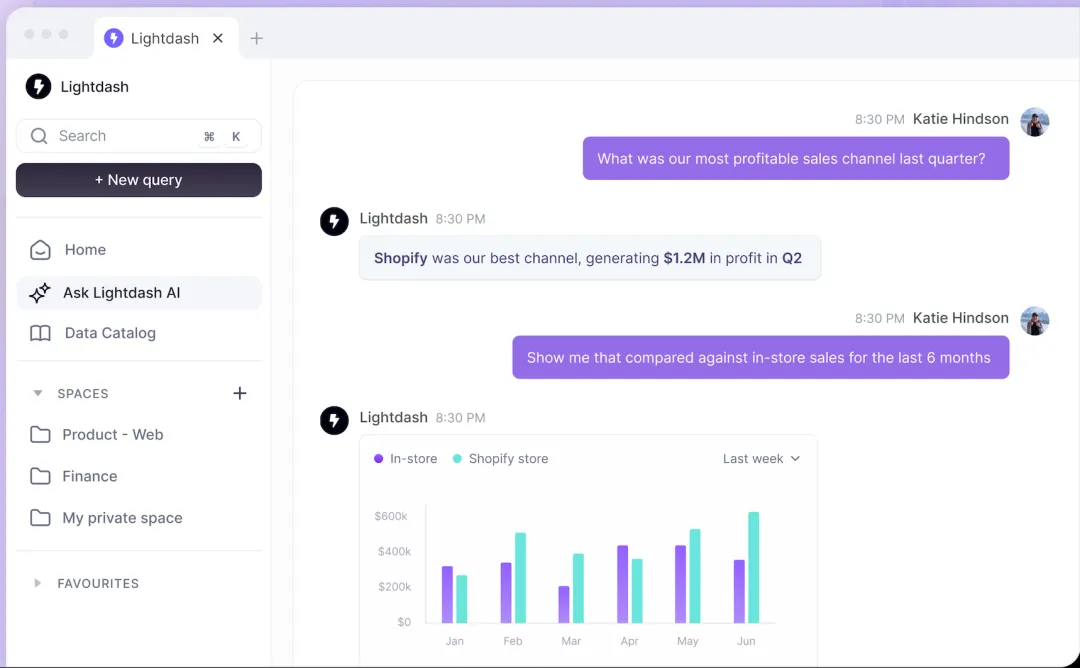

Lightdash,一个商业智能(BI)平台和开源替代品,旨在替代谷歌的 Looker,正在推出一款新产品,允许公司为特定团队的使用案例培训“AI 分析师”,使公司中的任何人都能够查询汇总的业务数据。

近一个月来,全面对标 OpenAI 的智谱大小动作不断,GLM-4-Flash 免费,推出极致性价比的 FlashX,旗舰模型升级到 Plus 系列... 其中最为关注的就是 Plus 系列,模型性能越来越强的同时,价格也越来越低。

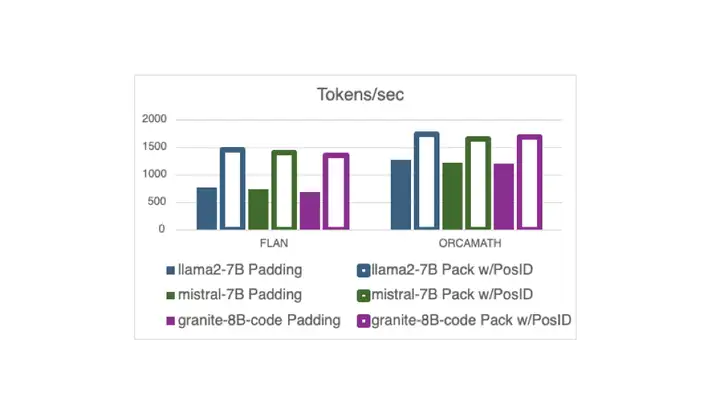

现在,在 Hugging Face 中,使用打包的指令调整示例 (无需填充) 进行训练已与 Flash Attention 2 兼容,这要归功于一个 最近的 PR 以及新的 DataCollatorWithFlattening。 它可以在保持收敛质量的同时,将训练吞吐量提高多达 2 倍。继续阅读以了解详细信息!

比LoRA更高效的模型微调方法来了——

大模型API,正式进入Flash时代。

用 FlexAttention 尝试一种新的注意力模式。

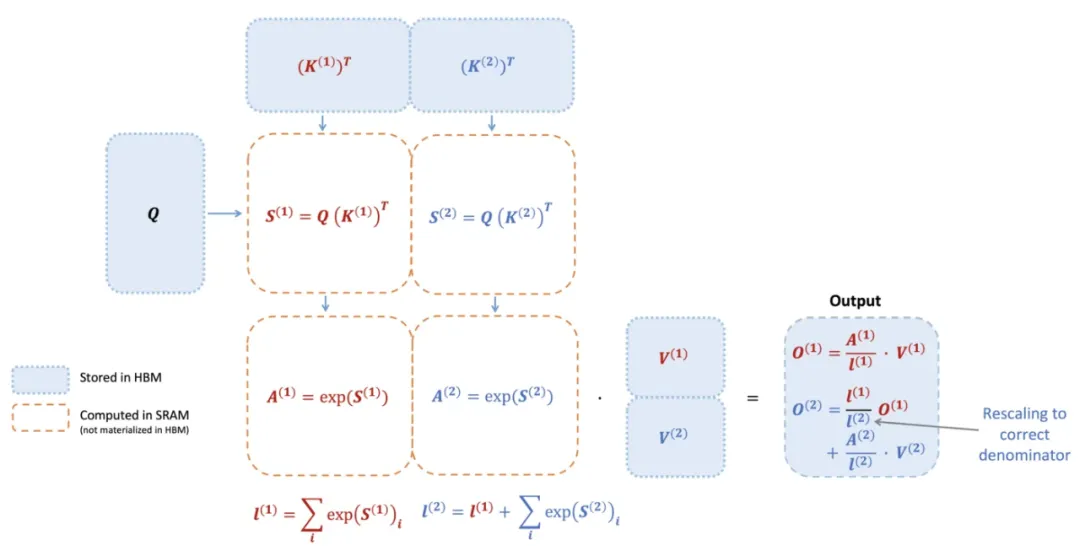

740 TFLOPS!迄今最强 FlashAttention 来了。

时隔一年,FlashAttention又推出了第三代更新,专门针对H100 GPU的新特性进行优化,在之前的基础上又实现了1.5~2倍的速度提升。