炒菜、雕刻、绘画、汽车人变形!MakeAnything用扩散Transformer解锁多任务过程生成

炒菜、雕刻、绘画、汽车人变形!MakeAnything用扩散Transformer解锁多任务过程生成人类智慧的一大特征是能够分步骤创造复杂作品,例如绘画、手工艺和烹饪等,这些过程体现了逻辑与美学的融合。

人类智慧的一大特征是能够分步骤创造复杂作品,例如绘画、手工艺和烹饪等,这些过程体现了逻辑与美学的融合。

Meta的视频版分割一切——Segment Anything Model 2(SAM 2),又火了一把。

Segment Anything Model 2(SAM 2)在传统视频目标分割任务大放异彩,引起了众多关注。然而,港中文和上海 AI Lab 的研究团队发现 SAM 2 的贪婪选择策略容易陷入「错误累积」的问题,即一次错误的分割掩码选择将影响后续帧的分割结果,导致整个视频分割性能的下降。这个问题在长视频分割任务中显得更加严重。

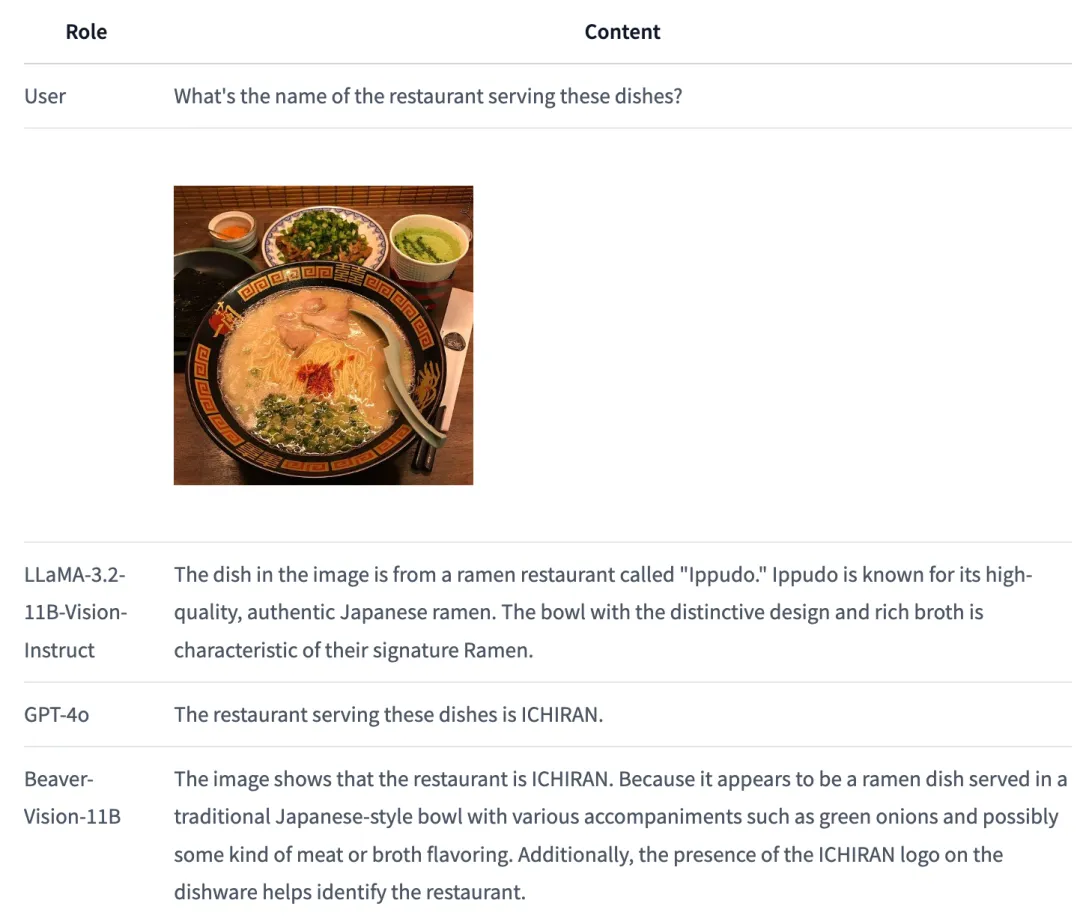

如何全模态大模型与人类的意图相对齐,已成为一个极具前瞻性且至关重要的挑战。

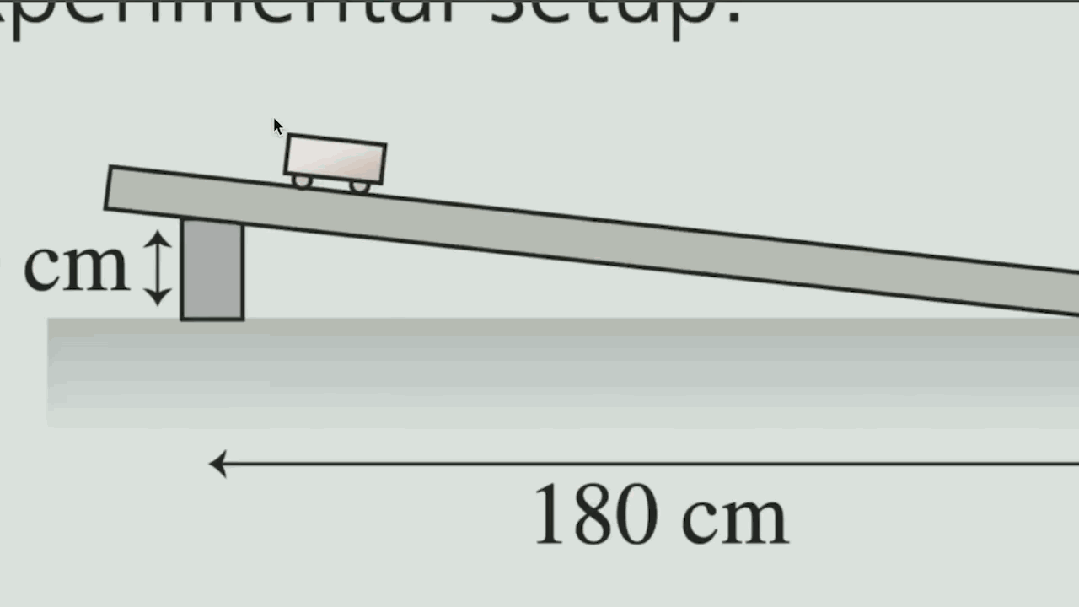

原来物理还能这么学。

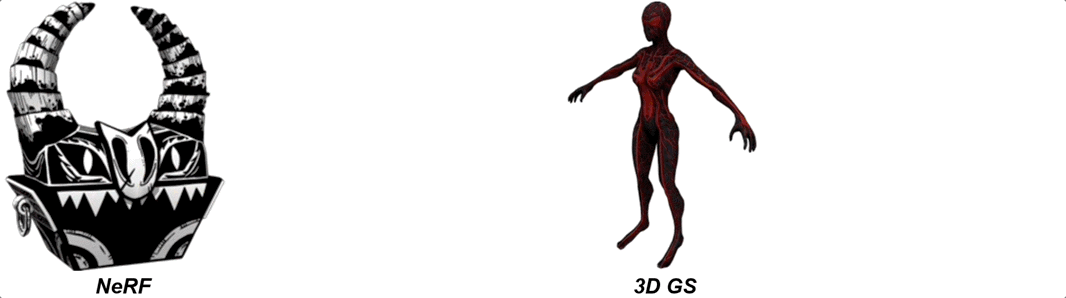

只需30秒,AI就能像3D建模师一样,在各种指示下生成高质量人造Mesh。

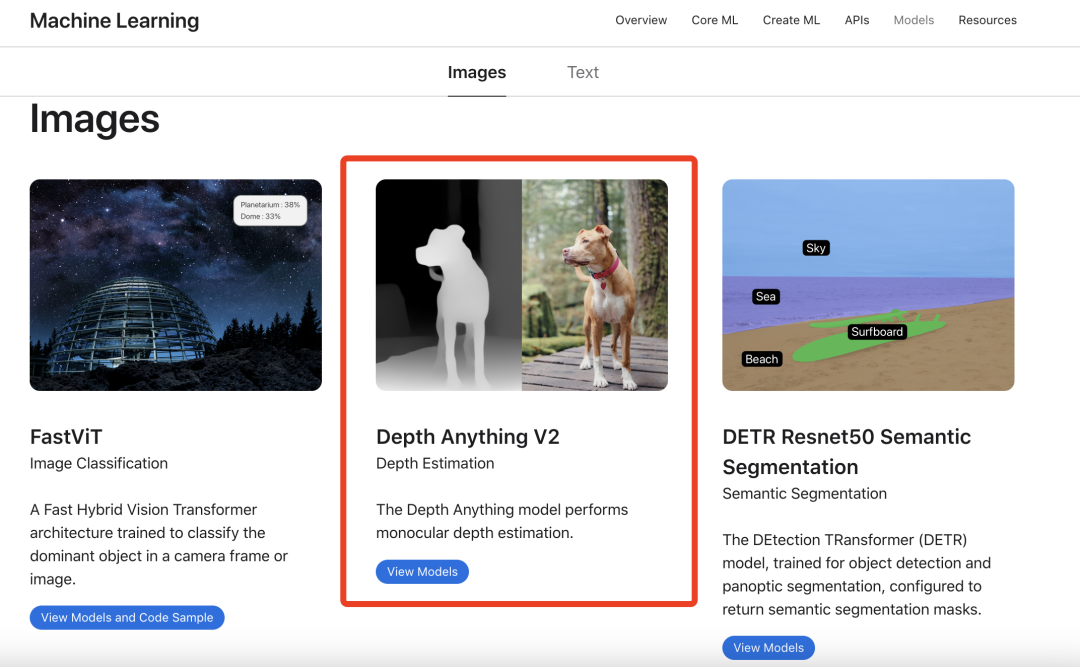

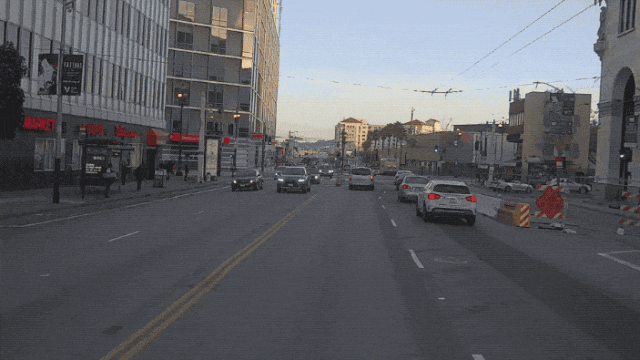

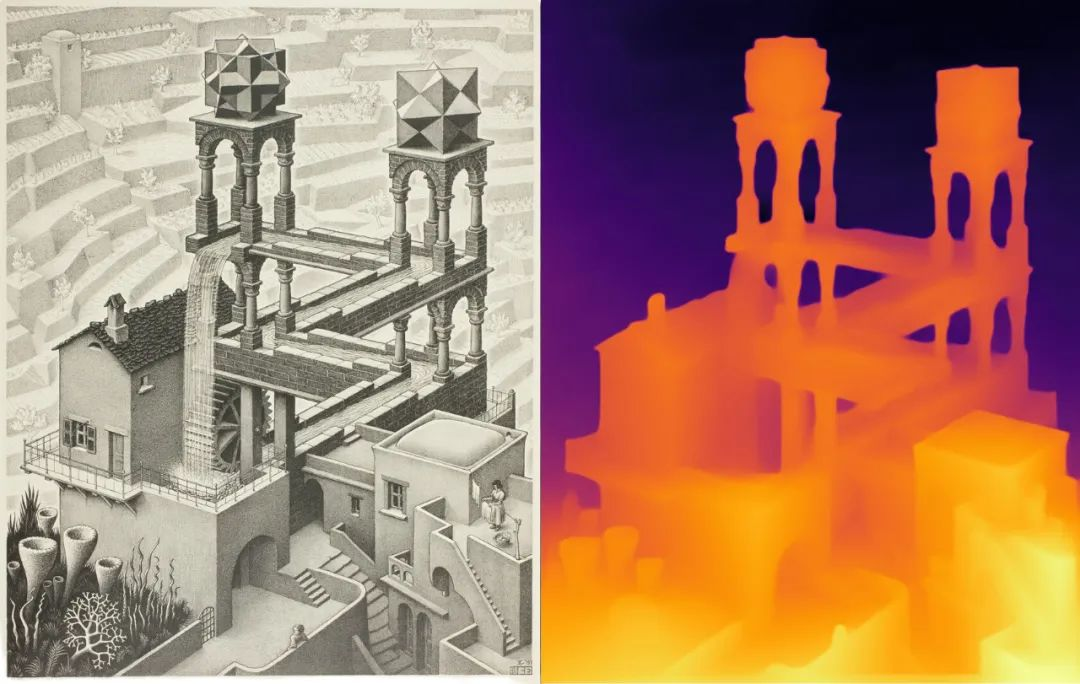

近日,字节跳动大模型团队开发的成果 Depth Anything V2 ,入选苹果公司 Core ML 模型库,目前已呈现在开发者相关页面中。

第一个针对「Segment Anything」大模型的域适应策略来了!相关论文已被CVPR 2024 接收。

来自小鹏汽车最新的一项研究——Anything in Any Scene。主打一个往真实环境里毫无违和感地“塞”进去任何东西。

人类有两只眼睛来估计视觉环境的深度信息,但机器人和 VR 头社等设备却往往没有这样的「配置」,往往只能靠单个摄像头或单张图像来估计深度。这个任务也被称为单目深度估计(MDE)。