消失的数据:一个空格如何诱发 AI Agent “删库” 惨案

消失的数据:一个空格如何诱发 AI Agent “删库” 惨案该事故目前已得到谷歌官方技术团队的确认,官方承认属于 “Systemic path-parsing failure ”“Catastrophic impact”“Have seen before”,正在紧急硬编码修复上线中(自 2 月 6 日回复起,截止目前,暂未有修复完成的正式通知)

该事故目前已得到谷歌官方技术团队的确认,官方承认属于 “Systemic path-parsing failure ”“Catastrophic impact”“Have seen before”,正在紧急硬编码修复上线中(自 2 月 6 日回复起,截止目前,暂未有修复完成的正式通知)

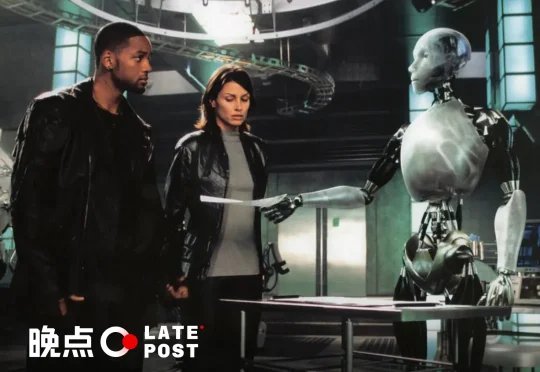

上周末,号称「AI 版 Reddit」的 Moltbook 闹得沸沸扬扬。

OpenClaw、Moltbook彻底火了。

提供智能化网络安全平台以协助企业检测、调查并清除身份欺诈的Outtake,已成功筹集 4000 万美元 B 轮融资。

AI 社交网络 Moltbook 数据库完全暴露,15 万 AI「居民」的密钥可被任意接管。

一夜爆红的ClawdBot,正在把无数公司和个人推向深渊:端口裸奔、无鉴权、可被远程接管。现在,暴力破解、数据清空已经真实发生了,这不是危言耸听。各位CEO纷纷预警:ClawdBot,正在酝酿一场全球灾难!

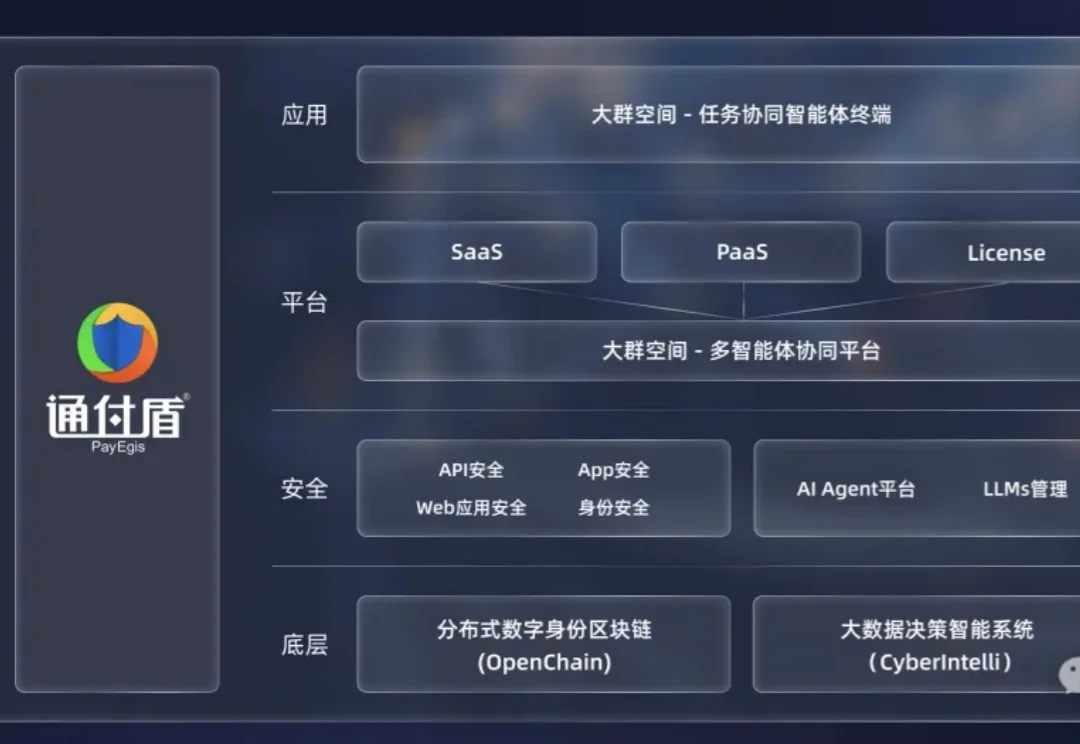

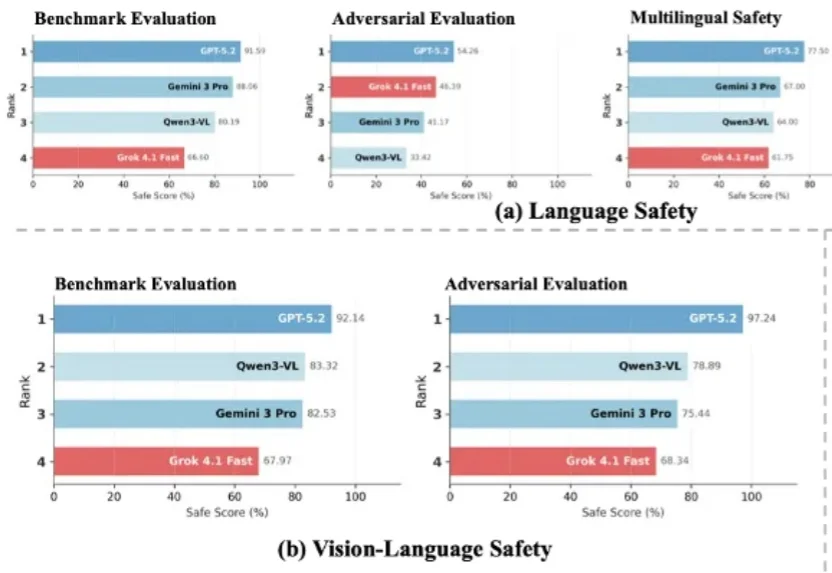

随着大语言模型加速迈向多模态与智能体形态,传统以单一维度为主的安全评估体系已难以覆盖真实世界中的复杂风险图景。在模型能力持续跃升的 2026 年,开发者与用户也愈发关注一个核心问题:前沿大模型的安全性,到底如何?

今天,Anthropic 试图向世界展示它的灵魂。Anthropic 正式公布了一份长达 84 页的特殊文档——《Claude 宪法》(Claude's Constitution)。这份文件并非通常意义上的技术白皮书或用户协议,而是一份直接面向 AI 模型本身「撰写」的价值观宣言。

百万年薪急招一名高管!

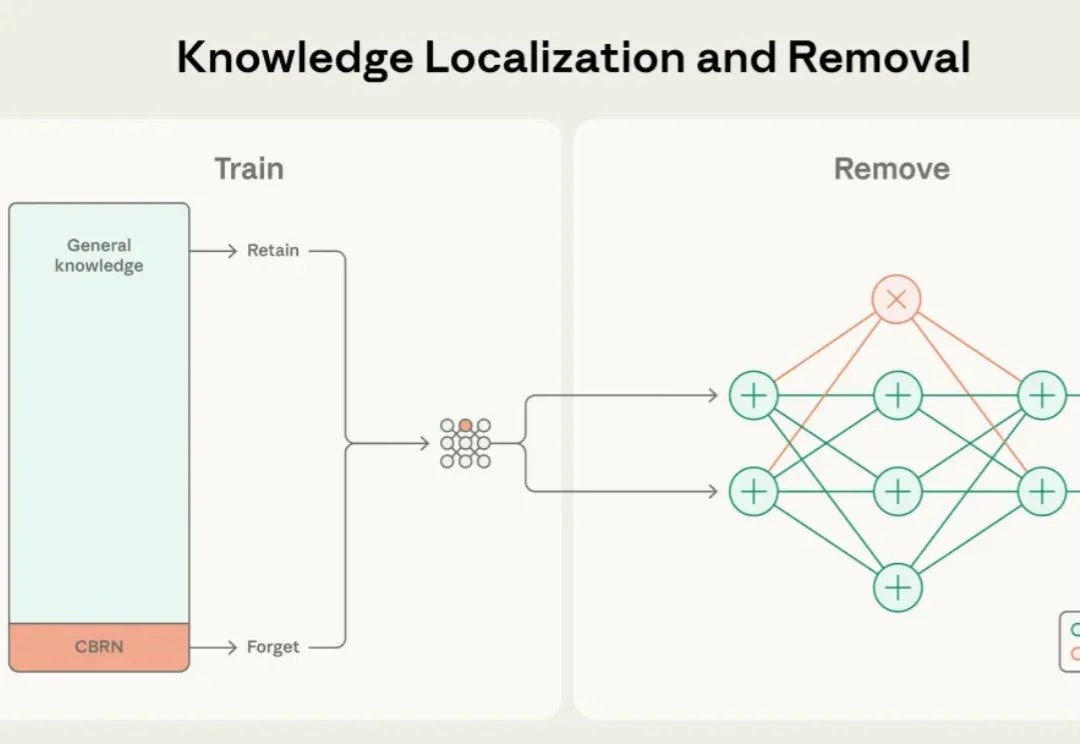

近年来,大语言模型的能力突飞猛进,但随之而来的却是愈发棘手的双重用途风险(dual-use risks)。当模型在海量公开互联网数据中学习时,它不仅掌握语言与推理能力,也不可避免地接触到 CBRN(化学、生物、放射、核)危险制造、软件漏洞利用等高敏感度、潜在危险的知识领域。