刚刚,一个2.6万亿AI独角兽诞生!英伟达微软押注,马斯克急了

刚刚,一个2.6万亿AI独角兽诞生!英伟达微软押注,马斯克急了年化经常性收入已达699亿

年化经常性收入已达699亿

谁能想到,2026 年第一个爆火出圈的 AI 互动装置,居然出现在米兰冬奥村?

当看到GLM-5正式发布后的能力,才惊觉前几天神秘模型Pony Alpha的热度还是有点保守了。

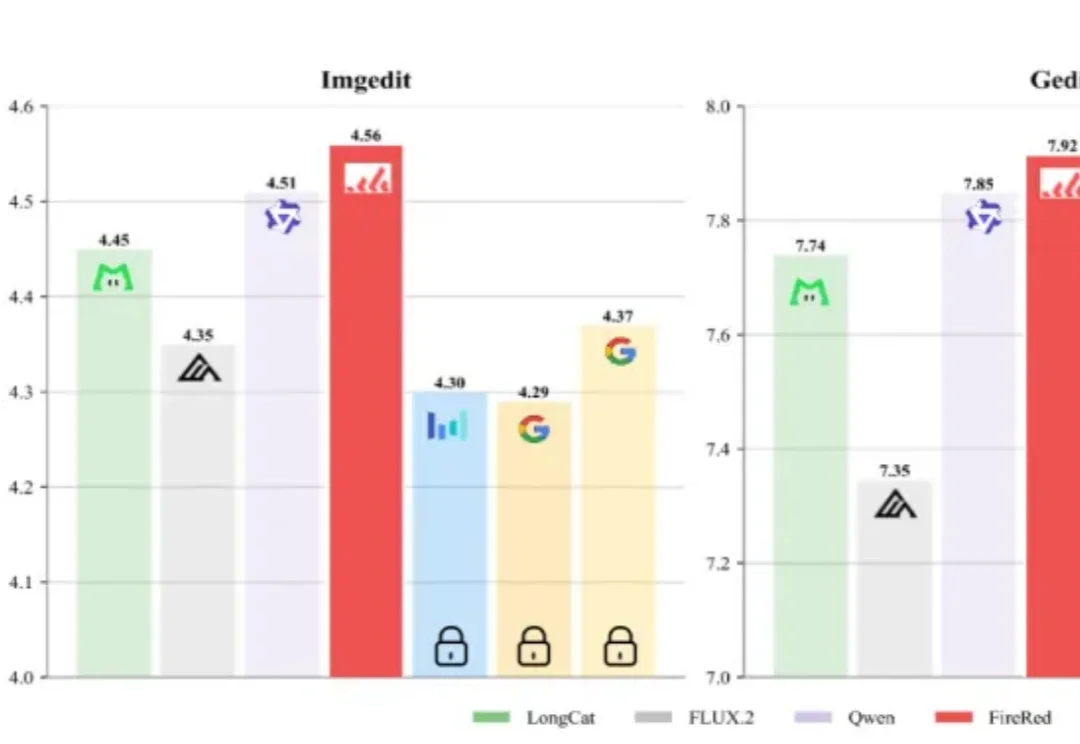

AI生图领域,又出了个“狠角色”。

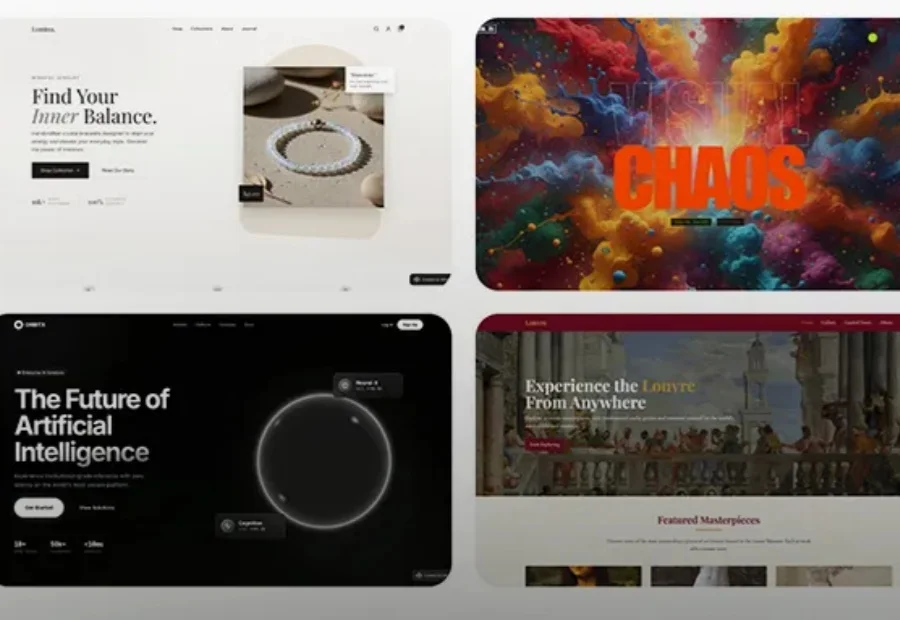

一句话做“黄金矿工”游戏、生成精美公司网站。

过去几年,大模型把自然语言处理彻底重塑了。GPT 出来之前,NLP 领域的状态是:每个任务一套模型,每个场景一批数据,每个公司一条流水线,互不通用,边界清晰。GPT 之后,这套逻辑被一个预训练底座 + 任务微调的范式整个替换掉了。

就是说,这几天还有哪档晚会节目是没有机器人现身的吗?

美国正在重建那些真正支撑国家实力的经济领域。能源、制造、物流和基础设施再次成为了焦点。

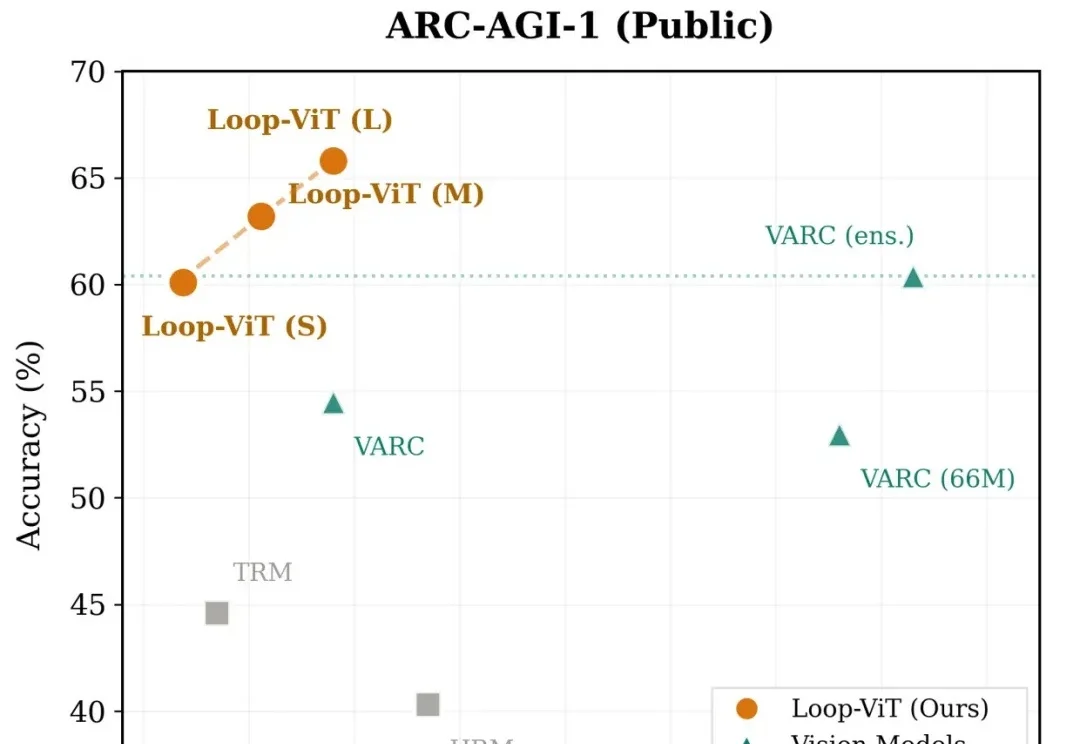

当我们解一道复杂的数学题或观察一幅抽象图案时,大脑往往需要反复思考、逐步推演。然而,当前主流的深度学习模型却走的是「一次通过」的路线——输入数据,经过固定层数的网络,直接输出答案。

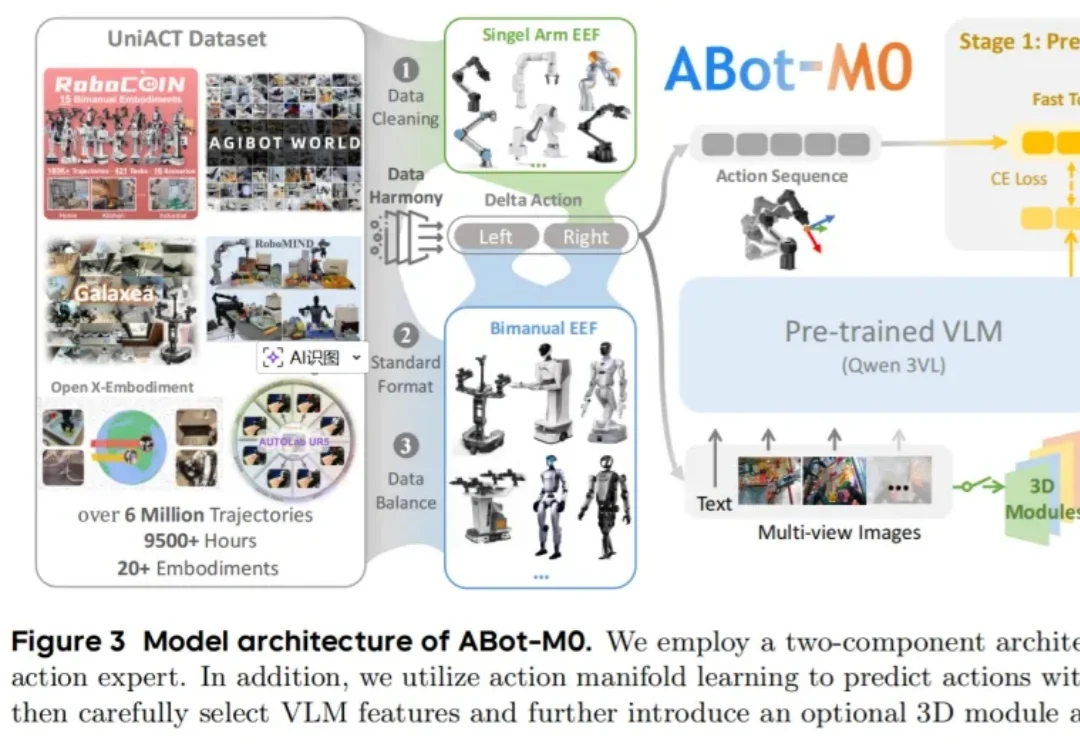

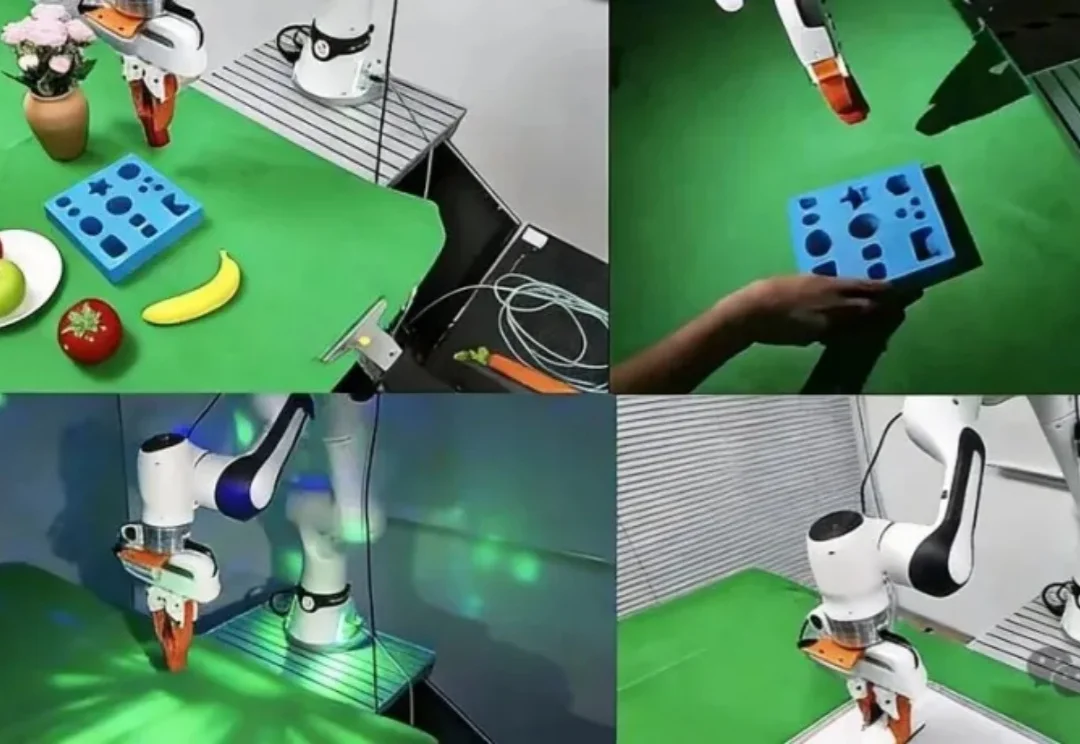

TwinRL用手机扫一遍场景构建数字孪生,让机器人先在数字孪生里大胆探索、精准试错,再回到真机20分钟跑满全桌面100%成功率——比现有方法快30%,人类干预减少一半以上。