开源界的 Opus 时刻:GLM-5 能否接住 Agentic Coding 的接力棒?

开源界的 Opus 时刻:GLM-5 能否接住 Agentic Coding 的接力棒?开源模型同样能承担复杂工程任务。

开源模型同样能承担复杂工程任务。

在大模型驱动的 Agentic Search 日益常态化的背景下,真实环境中智能体 “如何发查询、如何改写、是否真正用上检索信息” 一直缺乏系统刻画与分析。

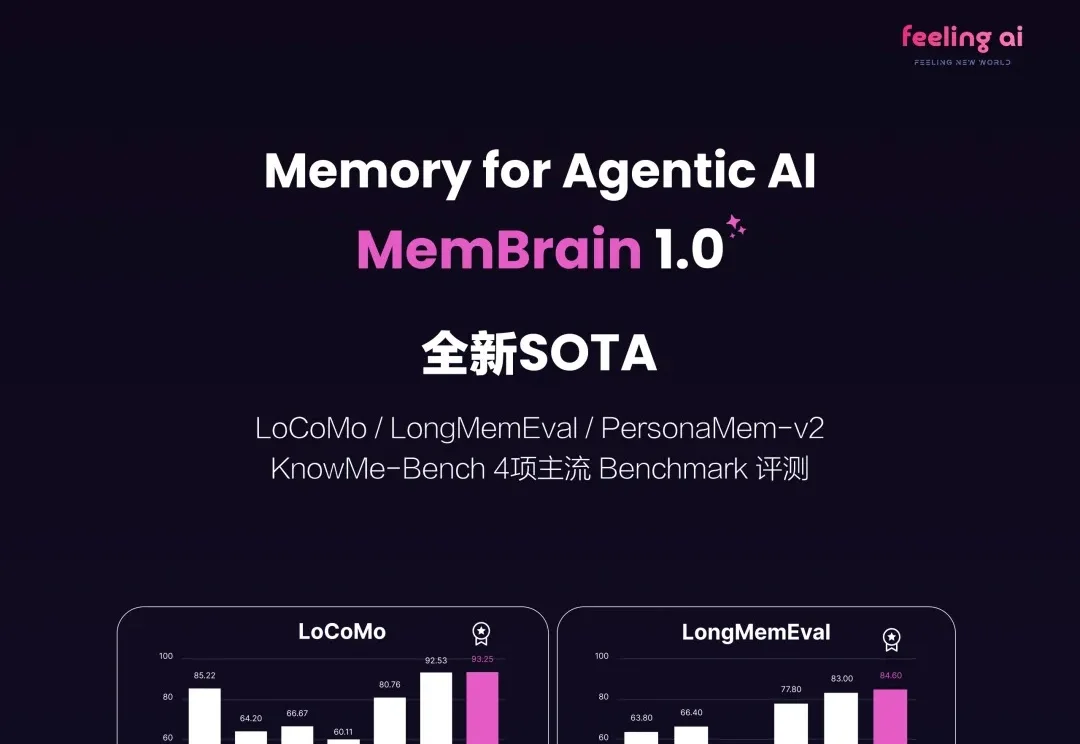

2026 刚来到 2 月,无论是底层模型大厂还是初创公司统统加速开卷,其中 Agentic Memory 方向的快速进化更是把大模型的能力上限推向了 NEXT LEVEL!

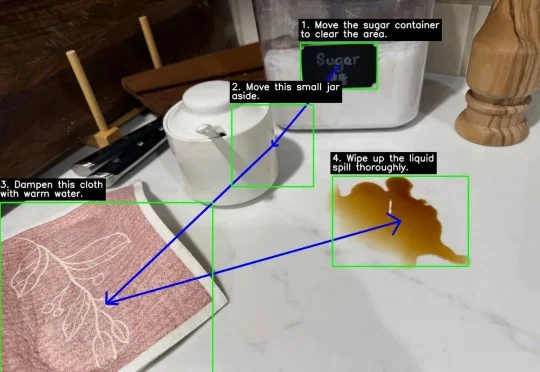

没想到吧,Google DeepMind刚刚为Gemini 3 Flash推出了一个重量级新能力:Agentic Vision(智能体视觉)。(难道是被DeepSeek-OCR2给刺激到了?)

机器人终于迎来自己的「iOS时刻」,全球首个具身Agentic OS来了:不是装个更聪明的大模型,而是给机器人配上一套真正的「操作系统」。

1月10日,很久没有公开露面的月之暗面创始人杨植麟,在一场定向邀请的行业论坛中,详细地分享了2025年Kimi的技术路线重点,以及对未来的思考。这次分享,有一个核心关键词,Agentic智能时代。这是通用大模型竞争的一个未来高地

您可能已经感受到了,从2025年开始到如今,全世界都在谈论Agentic AI或Agent(代理式AI)。从董事会到咨询公司,从更高级别的战略到街头巷尾,仿佛只要接入了大模型(LLM),所有的业务流程就能自动运转,效率就能翻倍。

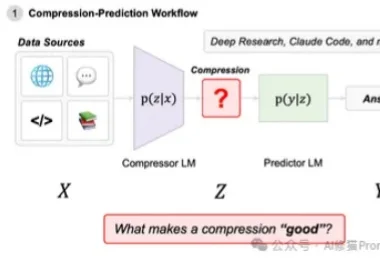

在近一年里,Agentic System(代理系统/智能体系统)正变得无处不在。从Open AI的Deep Research到Claude Code,我们看到越来越多的系统不再依赖单一模型,而是通过多模型协作来完成复杂的长窗口任务。

如果一项任务主要涉及文本处理,并且你拥有完善的数据渠道,能够获取完成该任务所需的全部文本信息,那么人工智能完成这项任务的难度就会较低。

过去两年,我们几乎默认了一件事: 人和 AI 的交互就只能靠文本框和语音。 不管是 GPT、DeepSeek、Claude,还是各种音视频 Agent,核心入口几乎清一色是一个聊天框。 但只要你真正做