2026开年关键词:Self-Distillation,大模型真正走向「持续学习」

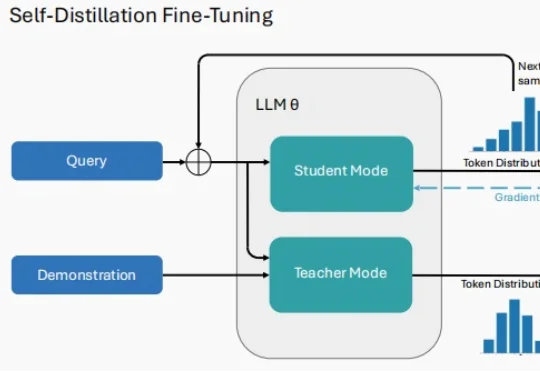

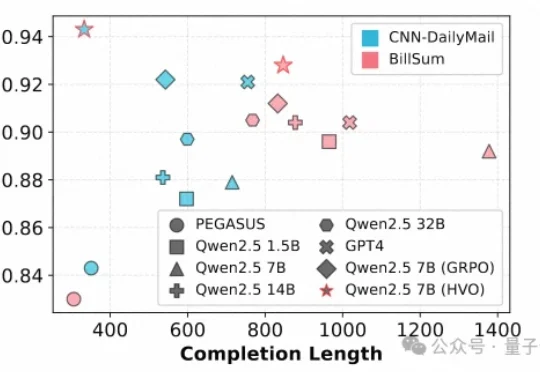

2026开年关键词:Self-Distillation,大模型真正走向「持续学习」2026 年刚拉开序幕,大模型(LLM)领域的研究者们似乎达成了一种默契。 当你翻开最近 arXiv 上最受关注的几篇论文,会发现一个高频出现的词汇:Self-Distillation。

2026 年刚拉开序幕,大模型(LLM)领域的研究者们似乎达成了一种默契。 当你翻开最近 arXiv 上最受关注的几篇论文,会发现一个高频出现的词汇:Self-Distillation。

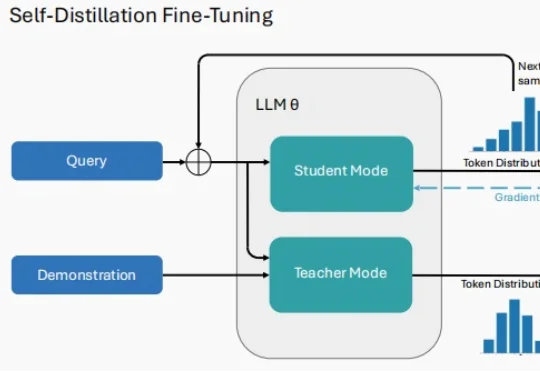

文本摘要作为自然语言处理(NLP)的核心任务,其质量评估通常需要兼顾一致性(Consistency)、连贯性(Coherence)、流畅性(Fluency)和相关性(Relevance)等多个维度。

是时候打破运动行业的「苦难叙事」了。 做一款 AI native 的运动手表,会有多少想象空间?

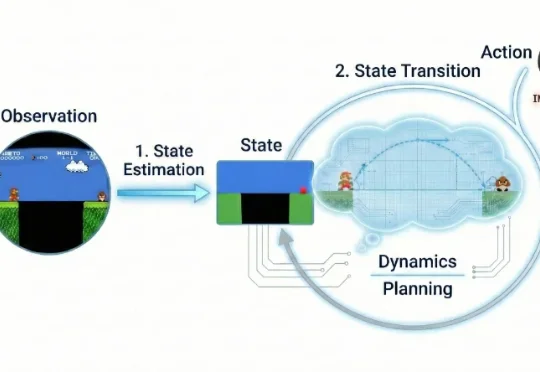

近年来,视频生成(Video Generation)与世界模型(World Models)已跃升为人工智能领域最炙手可热的焦点。从 Sora 到可灵(Kling),视频生成模型在运动连续性、物体交互与部分物理先验上逐渐表现出更强的「世界一致性」,让人们开始认真讨论:能否把视频生成从「逼真短片」推进到可用于推理、规划与控制的「通用世界模拟器」。

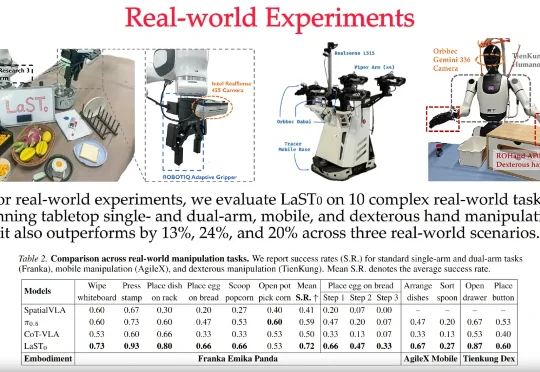

LaST₀团队 投稿 量子位 | 公众号 QbitAI 近日,至简动力、北京大学、香港中文大学、北京人形机器人创新中心提出了一种名为LaST₀的全新隐空间推理VLA模型,在基于Transformer混

英国AI音频独角兽ElevenLabs宣布完成5亿美元(约合人民币34.7亿元)的D轮融资,估值达110亿美元(约合人民币763.5亿元)。其估值较去年年初的33亿美元,实现了超230%的飞速增长。ElevenLabs联合创始人兼CEO Mati Staniszewski还透露,该公司已在考虑IPO事宜。

「暗涌Waves」独家获悉,一家成立刚不过4个月的AI-Native用户研究平台Trooly.AI已完成近千万美元的种子轮融资,投资方包括蓝驰创投、高瓴创投和王慧文。与市面上无数“超级个体”、“虚拟陪伴”、“碳基硅基共生世界”的宏大叙事不同,Trooly.AI想要用AI实现真实的商业闭环。其核心产品面向有用户调研需求的B端客户,通过多模态Voice Agent技术

这个春节,中国 AI 迎来「决战时刻」。据《The Information》援引内部消息人士透露:字节或将祭出全模态三件套;阿里除了或将发布强大的全新旗舰模型 Qwen 3.5 外,也会让千问打通支付与电商,挑战豆包;DeepSeek V4 或将携最强代码能力突袭。这不仅是技术竞赛,更是对 14 亿用户生活入口与未来互联网秩序的终极争夺。

果然,离开了OpenAI,大家都有美好的未来。(doge

大模型的出现,给许多行业带来了颠覆性的改变,运维这个向来被视为稳定、保守的领域也不例外。虽然“AIOps”这个概念早在 2016 年由 Gartner 提出,但早期的智能运维更多是利用大数据和机器学习对传统运维流程进行效率上的提升。