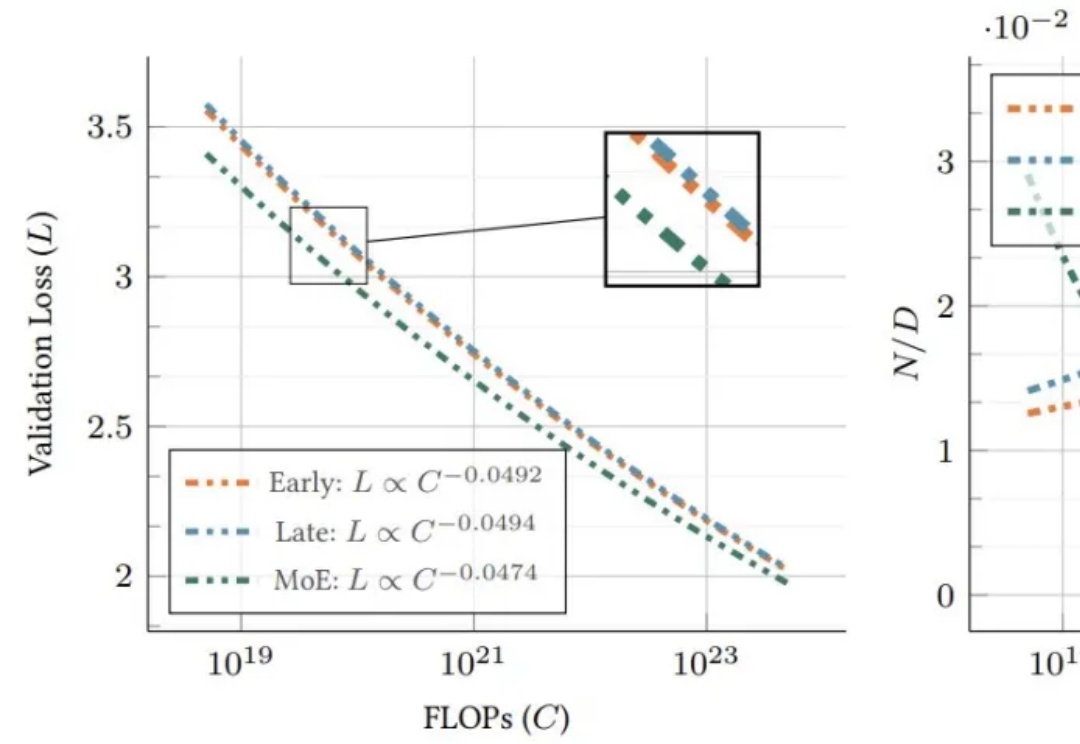

72B世界基座模型启动,小鹏的端到端智驾正在验证Scaling Laws

72B世界基座模型启动,小鹏的端到端智驾正在验证Scaling Laws最近一段时间,各家新势力都在角力部署端到端的智能驾驶系统。

最近一段时间,各家新势力都在角力部署端到端的智能驾驶系统。

让大模型进入多模态模式,从而能够有效感知世界,是最近 AI 领域里人们一直的探索目标。

科技媒体 maginative 今天(4 月 16 日)发布博文,报道称 OpenAI 宣布收购 Context.ai团队,后者是一家由 GV 支持的初创公司,以评估和分析 AI 模型见长。Context.ai的联合创始人 Henry Scott-Green(首席执行官)和 Alex Gamble(首席技术官)将加入 OpenAI,专注于研发模型评估工具。

就在刚刚,据外媒 The Verge 援引知情人士消息称,OpenAI 正在研发一个类似 X(前 Twitter)的社交网络。 项目还处于早期阶段,但据称内部已完成原型开发 2️⃣ 项目重点是 ChatGPT 的图像生成功能和社交信息流 3️⃣ CEO Sam Altman 已私下向圈外人征求反馈

刚出道的 HiDream-I1,拿下了 Hugging Face 趋势榜第二(图像榜第一),Artificial Analysis 文生图第二,排在Midjourney、Google Imagen、FLUX、SDXL 之前,仅次于 GPT-4o 。

要理解上半场,看看它的赢家。你认为到目前为止最有影响力的 AI 论文是哪些?我尝试了斯坦福大学 224N 课程的测验,答案并不令人惊讶:Transformer、AlexNet、GPT-3 等等。这些论文有什么共同点?它们提出了一些训练更好模型的基本突破。但同样,它们通过在一些基准测试上展示一些(显著的)改进来发表论文。

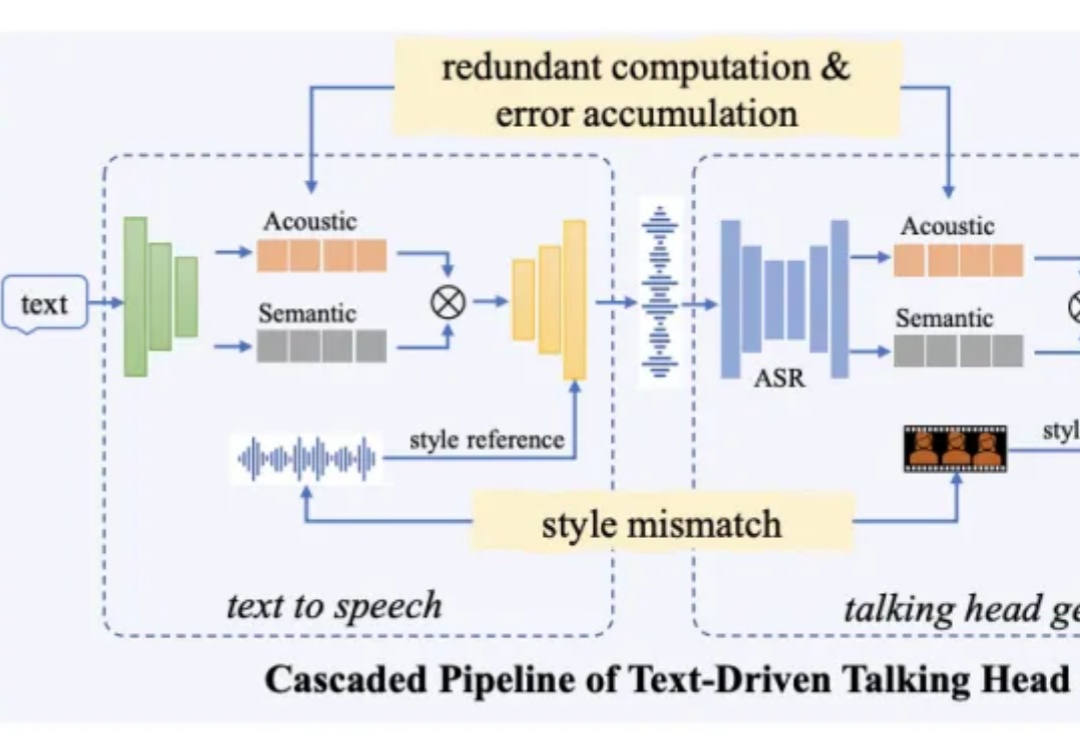

近日,阿里通义实验室推出了全新数字人视频生成大模型 OmniTalker,只需上传一段参考视频,不仅能学会视频中人物的表情和声音,还能模仿说话风格。相比传统的数字人生产流程,该方法能够有效降低制作成本,提高生成内容的真实感和互动体验,满足更广泛的应用需求。目前该项目已在魔搭社区、HuggingFace 开放体验入口,并提供了十多个模板,所有人可以直接免费使用。

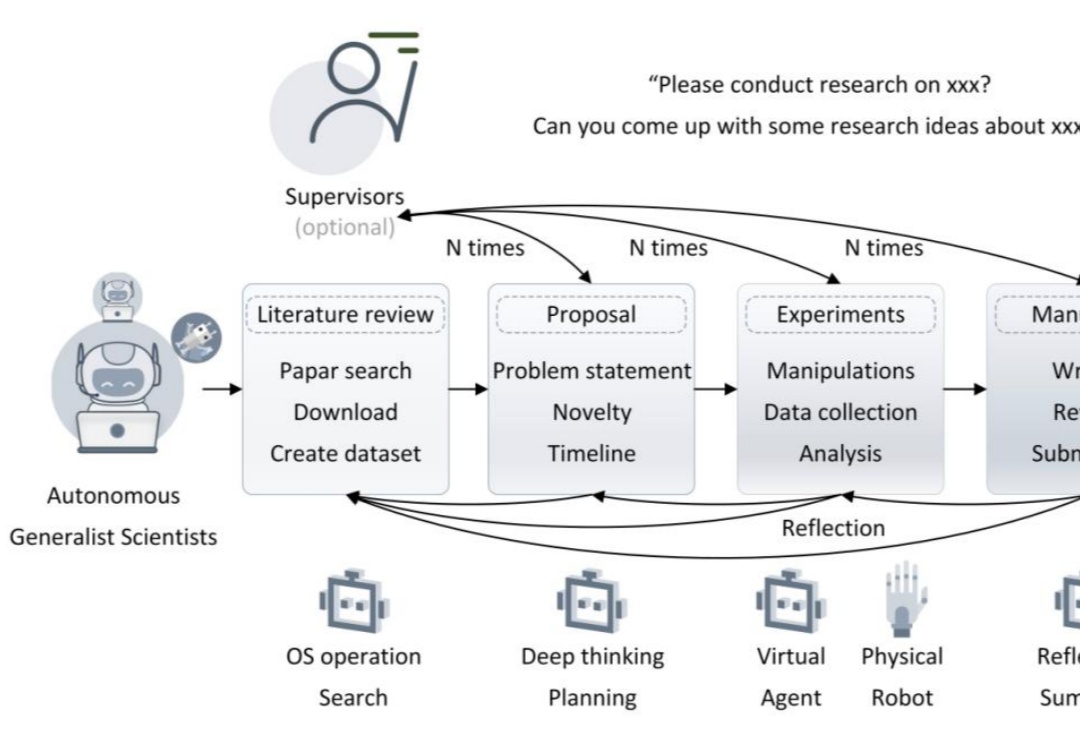

自主通才科学家的 5 个层级。

前些天,GPT-4o的多模态生图上线之后,引发全球AI社区广泛的关注,吉卜力图画全网风靡。

MiniMax尤为特殊,从一开始就跟其他玩家不在同一赛道竞争。通用大模型上,MiniMax坚持“产模一体”的理念,即所有的底座模型都要服务于产品。同处于To C赛道,Kimi主战地在国内,MiniMax战略重点在海外市场。