AI爬虫如狼似虎,维基百科已经选择认怂

AI爬虫如狼似虎,维基百科已经选择认怂本月初,代表全美2200多家新闻机构的新闻/媒体联盟(News/Media Alliance)发起“支持负责任AI”运动,呼吁监管机构强制科技巨头为AI产品使用的内容付费。但就在美国媒体抱团保卫自己的知识产权时,单打独斗的维基百科则宣布向AI厂商“投降”。

本月初,代表全美2200多家新闻机构的新闻/媒体联盟(News/Media Alliance)发起“支持负责任AI”运动,呼吁监管机构强制科技巨头为AI产品使用的内容付费。但就在美国媒体抱团保卫自己的知识产权时,单打独斗的维基百科则宣布向AI厂商“投降”。

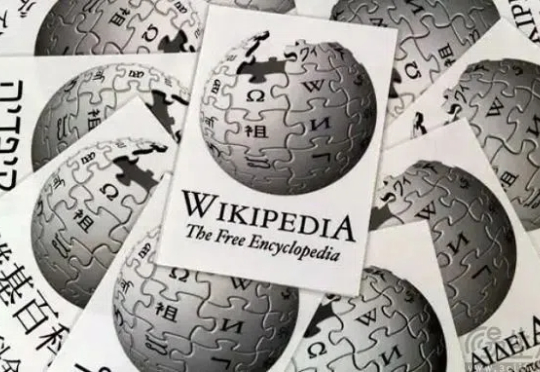

在当前大语言模型(LLMs)广泛应用于问答、对话等任务的背景下,如何更有效地结合外部知识、提升模型对复杂问题的理解与解答能力,成为 RAG(Retrieval-Augmented Generation)方向的核心挑战。

坏了,AI 当「舔狗」这件事藏不住了。今天凌晨,OpenAI CEO Sam Altman 发了一个有趣帖子,大意是:由于最近几轮 GPT-4o 的更新,导致其个性变得过于阿谀奉承,因此官方决定尽快进行修复。

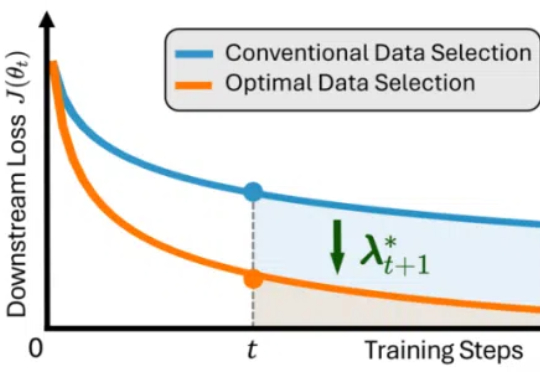

最近,DeepSeek-R1 和 OpenAI o1/03 等推理大模型在后训练阶段探索了长度扩展(length scaling),通过强化学习(比如 PPO、GPRO)训练模型生成很长的推理链(CoT),并在奥数等高难度推理任务上取得了显著的效果提升。

“定焦One”选取了市面上几家热门的AI榜单,分别是AI产品榜、Xsignal、AIGCRank、新榜,综合了月活(MAU)、日活(DAU)、下载量三个比较重要的维度,以及从业者的观点,梳理出1~3月全球AI应用的前二十及国内前十,有了以下发现:

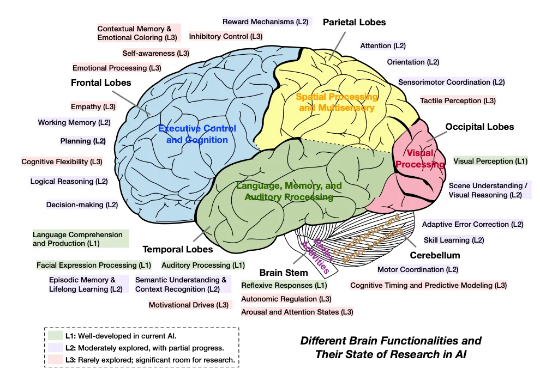

,MetaGPT & Mila 联合全球范围内 20 个顶尖研究机构的 47 位学者,共同撰写并发布了长篇综述《Advances and Challenges in Foundation Agents:

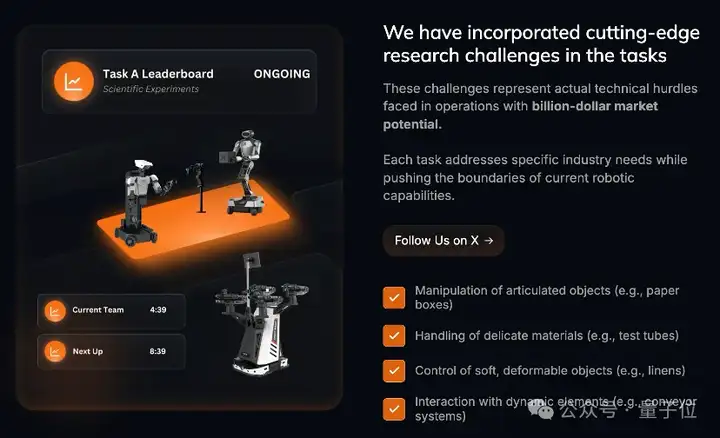

5月19-23日,ICRA 2025将在美国亚特兰大举行。届时,第一届“探索机器人能力边界双臂机器人挑战赛(WBCD,What Bimanual Can Do)”决赛也将在ICRA 2025现场拉开帷幕。

近年来,大语言模型(LLMs)在自然语言理解、代码生成与通用推理等任务上取得了显著进展,逐步成为通用人工智能的核心基石。

她21岁创立AI公司,靠5%股份逆风翻盘!Lucy Guo如何从自学编程到辍学创业,超越Taylor Swift,成为全球最年轻的白手起家女亿万富翁?Scale AI最新估值为250亿美元,这也让联合创始人Lucy Guo凭借其股份身价暴涨。

美国当地时间4月24日,谷歌母公司Alphabet公布了截至2025年3月31日的第一季度财报。财报显示,Alphabet第一季度营收为902.34亿美元,同比增长12%,不计入汇率变动的影响为同比增长14%;按照美国通用会计准则,Alphabet第一季度净利润为345.40亿美元,较去年同期的236.62亿美元相比增长46%;