开源又赢闭源!商汤8B模型空间智能碾压GPT-5,AI看懂世界又进了一步

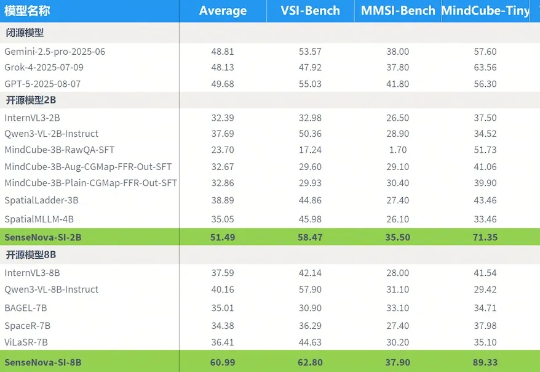

开源又赢闭源!商汤8B模型空间智能碾压GPT-5,AI看懂世界又进了一步昨晚,商汤正式发布并开源SenseNova-SI系列空间智能大模型,涵盖2B与8B两个版本。该系列模型在多个空间智能基准测试中均表现突出,其中SenseNova-SI-8B模型在VSI-Bench、MMSI-Bench、MindCube-Tiny与ViewSpatial四个核心任务上获得60.99的平均成绩

昨晚,商汤正式发布并开源SenseNova-SI系列空间智能大模型,涵盖2B与8B两个版本。该系列模型在多个空间智能基准测试中均表现突出,其中SenseNova-SI-8B模型在VSI-Bench、MMSI-Bench、MindCube-Tiny与ViewSpatial四个核心任务上获得60.99的平均成绩

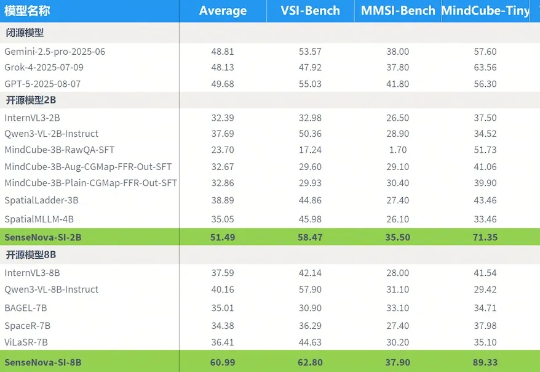

近期,新加坡AI公司WIZ.AI成功完成B轮融资,融资规模为数千万美元。本轮融资由日本三井住友银行(SMBC)旗下的SMBC Asia Rising Fund领投,泰国开泰银行(Kasikorn Bank)的创投部门Beacon Venture Capital,以及SMIC SG Holdings等机构参投。

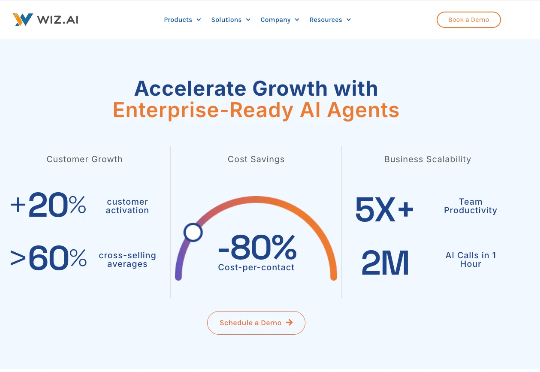

Gemini 3 还没影子,GPT 5.1 已经在路上。7 号深夜,OpenRouter 平台上线了一个全新的隐名模型。已经有眼尖动作快的网友尝鲜体验,并且认为这就是披着马甲的 GPT 5.1,暂名:Polaris Alpha。

近日,OpenAI 就公司财务状况发表公开声明而引发混乱后,面临不诚实的指控。而三天前,他的首席财务官提议政府应该“支持”该公司的基础设施贷款。她后来声称说错了话。OpenAI 首席执行官 Sam Altman 在三天前,他的首席财务官提议政府应该“支持”该公司的基础设施贷款。她后来声称说错了话。

Leonis Capital 在全球超过 10,000 家 AI 初创公司中,基于融资、招聘、用户使用情况,GitHub 趋势、新闻、ProductHunt、ARR 预估等数据和信号,筛选出了 100 家增长最快的初创公司。他们对这 100 家 AI 初创公司进行了详细分析,制作了一份 The Leonis AI 100 的研究报告。

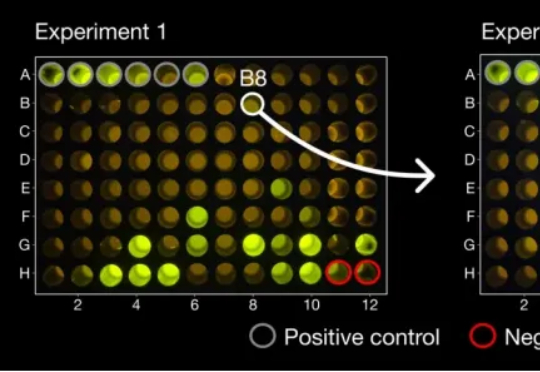

现实爽文,小扎打脸! 2023年上半年,扎克伯格在Meta大裁员,几个月之内裁掉一万人,其中就包括由十几名科学家组成的Meta-FAIR蛋白质小组。 然而,被裁掉的几名科学家不甘心,创办了AI蛋白质公

Cal AI联合创始人Zach Yadegari自7岁起学习编程,16岁卖出自己首个应用赚得近10万美元,并与另外一名高中生联合创办了一家年营收达3000万美元的AI应用公司。在被常春藤盟校拒绝后,Yadegari选择进入迈阿密大学。Yadegari认为AI时代会出现更多年轻的创业者,他给出的最重要的一条创业建议就是:立刻行动。

众所周知,大型语言模型(LLM)的根本运作方式是预测下一个 token(词元),能够保证生成的连贯性和逻辑性,但这既是 LLM 强大能力的「灵魂」所在,也是其枷锁,将导致高昂的计算成本和响应延迟。 可

这说明o1不仅能够使用语言,还能够思考语言,具备元语言能力(metalinguistic capacity )。由于语言模型只是在预测句子中的下一个单词,人对语言的深层理解在质上有所不同。因此,一些语言学家表示,大模型实际上并没有在处理语言。

11月7日,Xsignal (奇异因子) 携手中欧国际工商学院(CEIBS)AI与营销创新实验室 联合举办“AI驱动营销新范式:GEO白皮书发布暨AI搜索时代的品牌竞争力”论坛,重磅发布行业首份《AI搜索时代:从GEO到AIBE的品牌新蓝图|GEO白皮书|2026》,定义AI时代品牌新标准、重塑营销底层逻辑!