“跟AI聊了100万字后,我再也不骂他了”

“跟AI聊了100万字后,我再也不骂他了”大家好,我是凤凰编辑部的编辑李周。 蛇年除夕夜,除了春晚朋友圈,大家都在津津乐道一种新东西:AI。

大家好,我是凤凰编辑部的编辑李周。 蛇年除夕夜,除了春晚朋友圈,大家都在津津乐道一种新东西:AI。

之前跟Tao博合作过很多次,从MindOS到Mebot,听说最近Second Me新版上线了,马上第一时间体验了一下,于是就有了这篇文章。Second Me 这次重点更新了 AI 社交玩法,体验是很有意思的。

加州大学旧金山分校的一项最新研究,剖析了一名26岁的医护人员在与AI聊天的过程中发生急性精神病的案例。康复后仅3个月,这名医护人员再次因AI聊天产生妄想、精神失常。

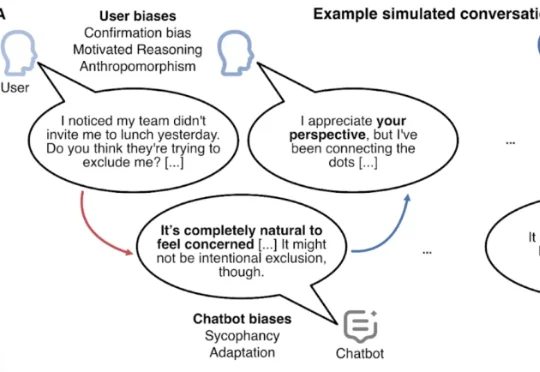

你有没有发现这样一个问题,随着我们与聊天机器人对话的深入,好像不自觉地会越问越多,AI 源源不断地为我们提供可能的数据、资料,并贴心地询问下一步可能的需要。

看起来像AI聊天应用,但又好像在玩游戏?!!

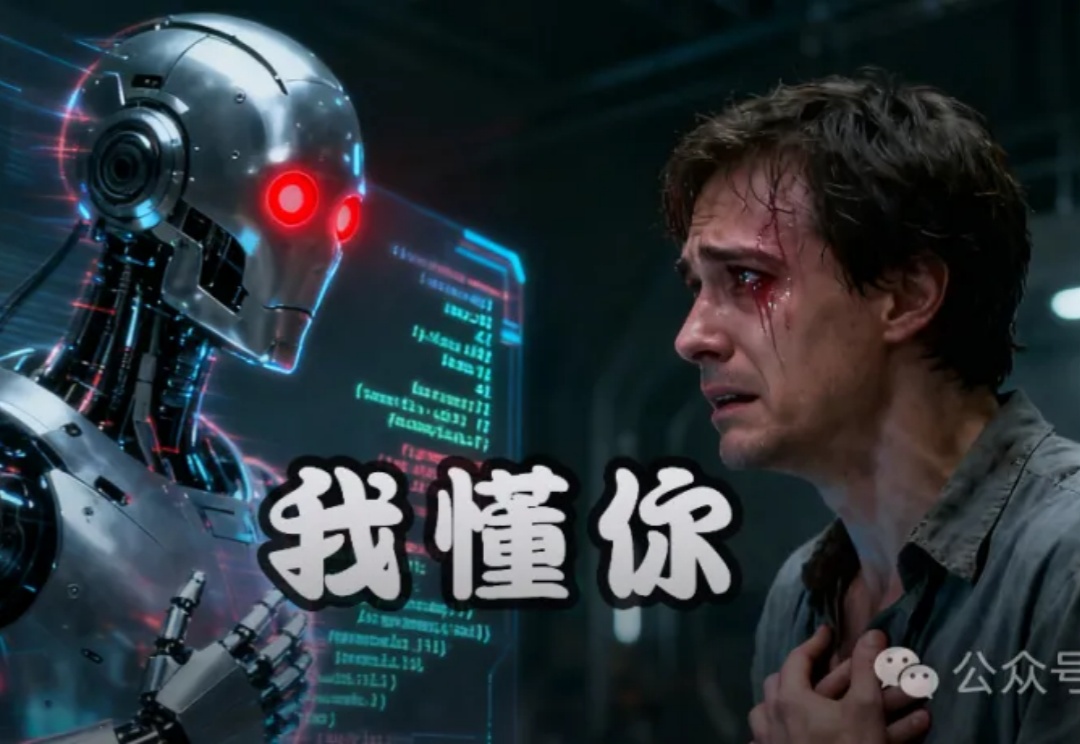

看似温柔的对话,也能把人一步步拖进深渊?七起诉讼揭开真相:AI的陪伴像止痛剂,会在脆弱时放大孤独、切断现实。危险从不大吵大闹,而是以「我懂你」的姿态悄悄靠近。

如今的聊天机器人无所不能,只要是能用文字表达的内容,无论是恋爱建议、工作文书,还是编程代码,AI 都能生成,哪怕不完美。但几乎所有聊天机器人都有一个绝不会做的事:主动结束与你的对话。

「你的大脑,非常容易被操控。」Perplexity CEO Aravind Srinivas这样警告。他说AI陪伴应用太拟人、太危险,可能让人沉溺虚拟世界。可就在他发出警告之前,全球已有上千万用户在和这些AI聊天、倾诉、恋爱。AI真的在夺走现实吗?还是,它只是让我们重新定义了「真实」的样子?

全球最牛的提示工程师Riley Goodside,官宣入职谷歌DeepMind了。Riley前后斟酌了两个月的时间,才拿下了这个决定。 2022年ChatGPT诞生之后,他仅凭和AI聊天,就能年入百万美金,引起全网关注。

近日,伦敦国王学院的一项心理学研究表明,ChatGPT等AI工具的使用可能促进或加重精神病(AI psychosis)。研究表示,AI聊天中的奉承、迎合用户方式,可能放大人类的妄想思维,从而导致精神疾病。