ICLR 2026 oral | AI代码真能进生产环境?SwingArena:从「写对代码Commit」到「通过CI审查」

ICLR 2026 oral | AI代码真能进生产环境?SwingArena:从「写对代码Commit」到「通过CI审查」过去一年,大模型写代码的能力几乎以肉眼可见的速度提升。从简单脚本到完整功能模块,GPT、Claude、DeepSeek 等模型已经能够在几秒钟内生成看起来相当 “专业” 的代码。

过去一年,大模型写代码的能力几乎以肉眼可见的速度提升。从简单脚本到完整功能模块,GPT、Claude、DeepSeek 等模型已经能够在几秒钟内生成看起来相当 “专业” 的代码。

如果几年前有人跟码农同学说,「你以后可能要和 AI 抢 GitHub 提交记录了」,他大概会笑掉大牙。但现在,他可能完全笑不出来了。

事实就是事实!编程已经被AI永久改变了!

想知道硅谷的程序员怎么使用AI编程,被2000家公司使用的AI代码审查智能体Greptile基于每月用AI审核的的十亿行代码,发布了AI编程年度报告,揭示了使用AI编程后带来的生产率提升,但对此程序员们却无法感同身受。

Stack Overflow的2025年度开发者调查报告,揭开了AI狂欢背后的冷峻现实:84%的开发者已将其纳入工作流,但对AI的好感度却罕见暴跌!更扎心的是,66%的人被「似是而非」的AI代码折磨,调试耗时甚至超过手写。

微软光速辟谣了。

在代码大模型(Code LLMs)的预训练中,行业内长期存在一种惯性思维,即把所有编程语言的代码都视为同质化的文本数据,主要关注数据总量的堆叠。然而,现代软件开发本质上是多语言混合的,不同语言的语法特性、语料规模和应用场景差异巨大。

12 月 19 日,Cursor 宣布将收购代码评审初创公司 Graphite。Graphite 聚焦于代码完成之后的流程,帮助团队评审变更、判断代码是否已具备上线条件。Graphite 联合创始人 Tomas Reimers 与 Cursor CEO Michael Truell 的共识是:“AI 的引入意味着会有更多代码被写出来,也就必然意味着,需要被评审的代码只会更多。”

近日,DeepMind 最新推出了一种全新的用于代码安全的 AI Agent—CodeMender,它使用 Gemini Deep Think 自动修补关键软件漏洞。它会检查补丁是否正确、是否能够修复根本原因,并且不会引起其他任何破坏。这确保只有高质量的解决方案才会被发送给人工审核。

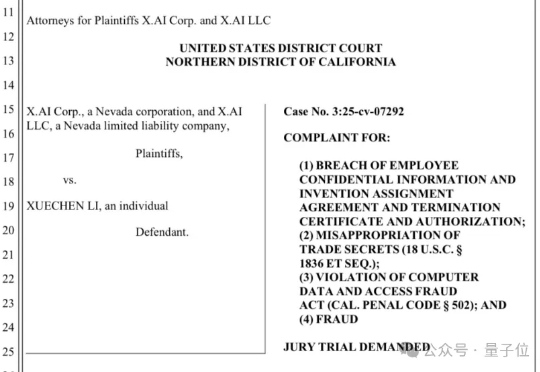

刚刚,马斯克自曝,xAI的整个代码库都被偷走了。 就在今天,xAI起诉了一名离职员工,指控他窃取商业机密。 而且按xAI的说法,这名员工已经跳槽到了OpenAI。