百元级的 AI ONE,普通人 AI 时代的第一块「敲门砖」

百元级的 AI ONE,普通人 AI 时代的第一块「敲门砖」一个百元级的「红灯」,如何成了信息焦虑时代的解药?

一个百元级的「红灯」,如何成了信息焦虑时代的解药?

近日消息,在拉斯维加斯举行的 CES 2026 上,波士顿动力与谷歌 DeepMind 宣布达成一项全新的 AI 合作伙伴关系,旨在为人形机器人开启一个全新的人工智能时代。

2024年7月14日,2024年欧洲杯锦标赛冠军赛如期举行,比赛将决出欧洲最佳国家足球队。在比赛只剩下不到五分钟时,西班牙队和英格兰队比分为1比1平,此时西班牙球员Mikel Oyarzabal在禁区顶端扑球,踢进了看似制胜的一球[1]。然而,在这次进攻中,Oyarzabal的位置接近越位,或者说离球门太远。

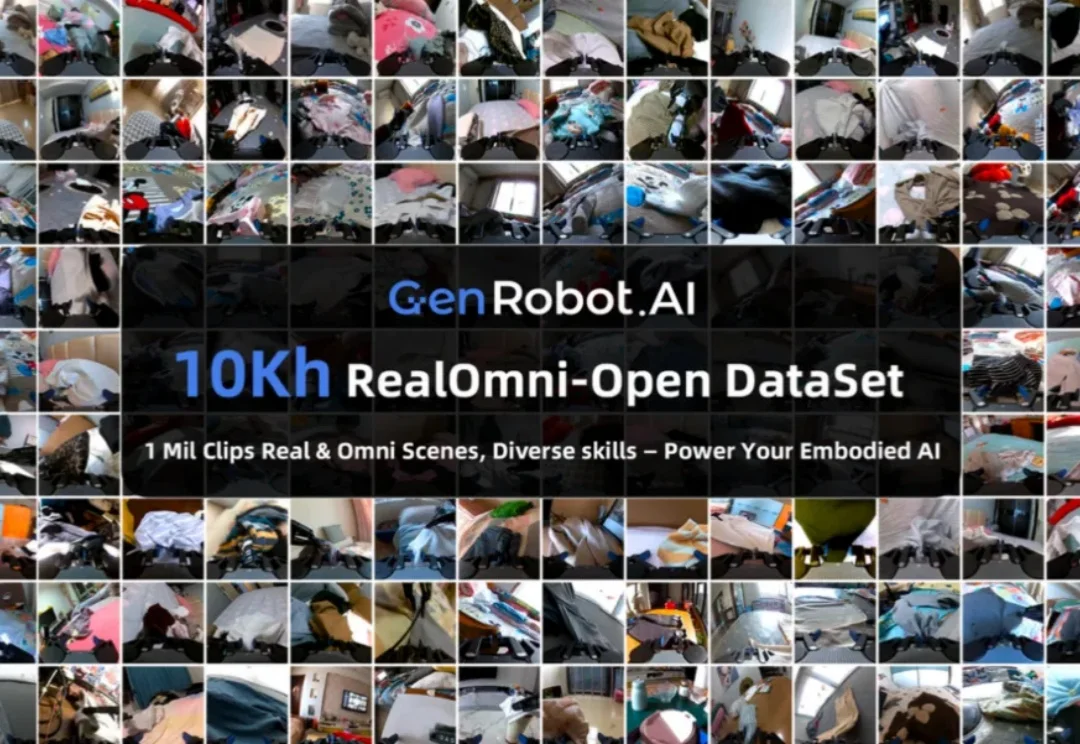

想象一下,你正在训练一个未来的家庭机器人。你希望它能像人一样,轻松地叠好一件衬衫,整理杂乱的桌面,甚至系好一双鞋的鞋带。但最大的瓶颈是什么?不是算法,不是硬件,而是数据 —— 海量的、来自真实世界的、双手协同的、长程的、多模态的高质量数据。

年末,AI圈被一则重磅消息刷屏。

对于电子产品,我们已然习惯了「出厂即巅峰」的设定:开箱的那一刻往往就是性能的顶点,随后的每一天都在折旧。

这两年一直在关注 AI,Claude Code 给我带来的震撼,和当初 Nano Banana 在画图领域的革命,几乎是一个级别。

flomo 是我今年用过的应用里,少数真正把 AI 从「好玩」做到「好用」的产品。

2025 年,人工智能的发展重心正在发生一次根本性转移:从追求模型的规模,转向构建其理解与解决复杂现实问题的能力。在这一转型中,高质量数据正成为定义 AI 能力的新基石。作为人工智能数据服务的前沿探索者,数据堂深度参与并支撑着这场变革的每一个关键环节。本文将深入解读 2025 年 AI 五大技术趋势及其背后的数据需求变革。

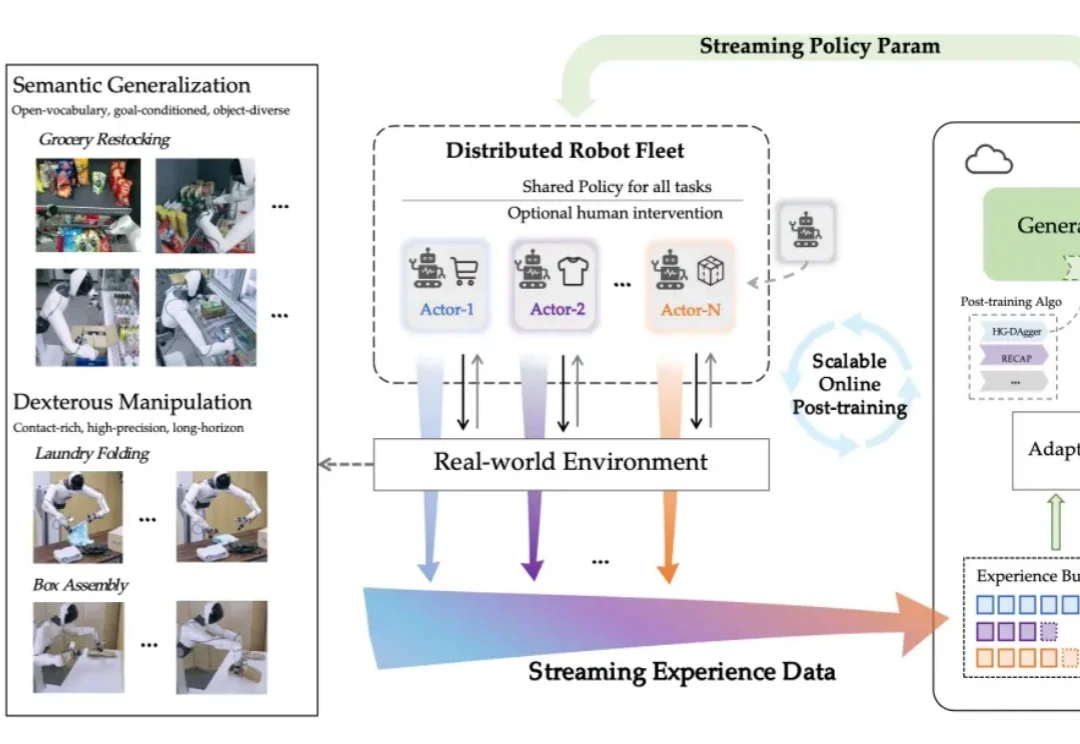

现实世界不是 demo,人形机器人该如何进入真实世界?