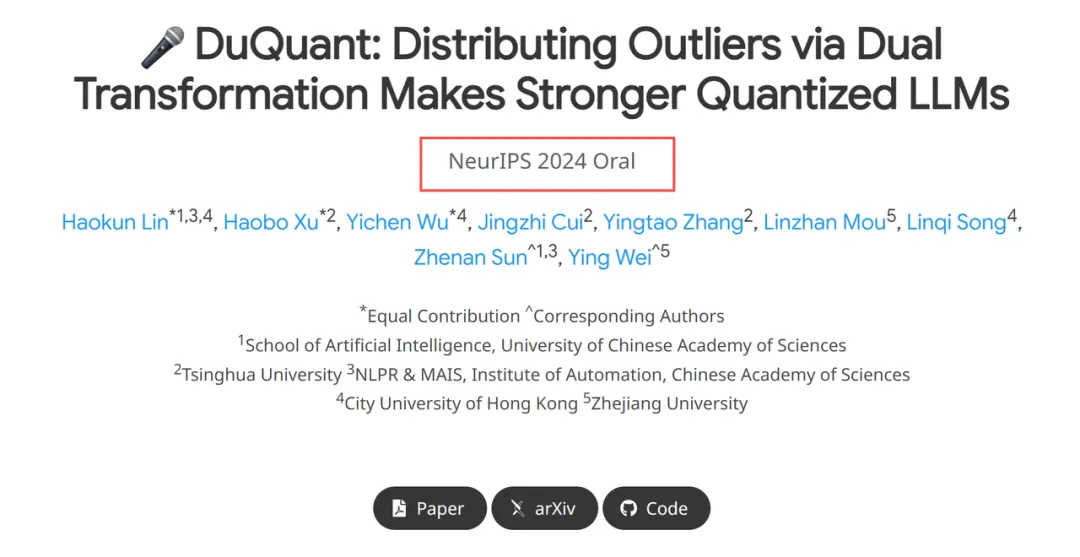

50s完成7B模型量化,4bit达到新SOTA,大模型低比特量化有新招了 | NeurIPS 2024 Oral

50s完成7B模型量化,4bit达到新SOTA,大模型低比特量化有新招了 | NeurIPS 2024 Oral消除激活值(outliers),大语言模型低比特量化有新招了—— 自动化所、清华、港城大团队最近有一篇论文入选了NeurIPS 2024(Oral Presentation),他们针对LLM权重激活量化提出了两种正交变换,有效降低了outliers现象,达到了4-bit的新SOTA。