速递|谷歌投资AI 3D设计应用Rooms,此前已创建超过 100 万个“房间”

速递|谷歌投资AI 3D设计应用Rooms,此前已创建超过 100 万个“房间”3D 设计应用 Rooms 刚刚获得更多资金。该应用于 2023 年进入测试版,由前谷歌员工开发,允许用户使用超过 10,000 个项目的库构建和编码互动 3D 房间和迷你游戏,并可以使用编程语言 Lua 进一步编辑。

3D 设计应用 Rooms 刚刚获得更多资金。该应用于 2023 年进入测试版,由前谷歌员工开发,允许用户使用超过 10,000 个项目的库构建和编码互动 3D 房间和迷你游戏,并可以使用编程语言 Lua 进一步编辑。

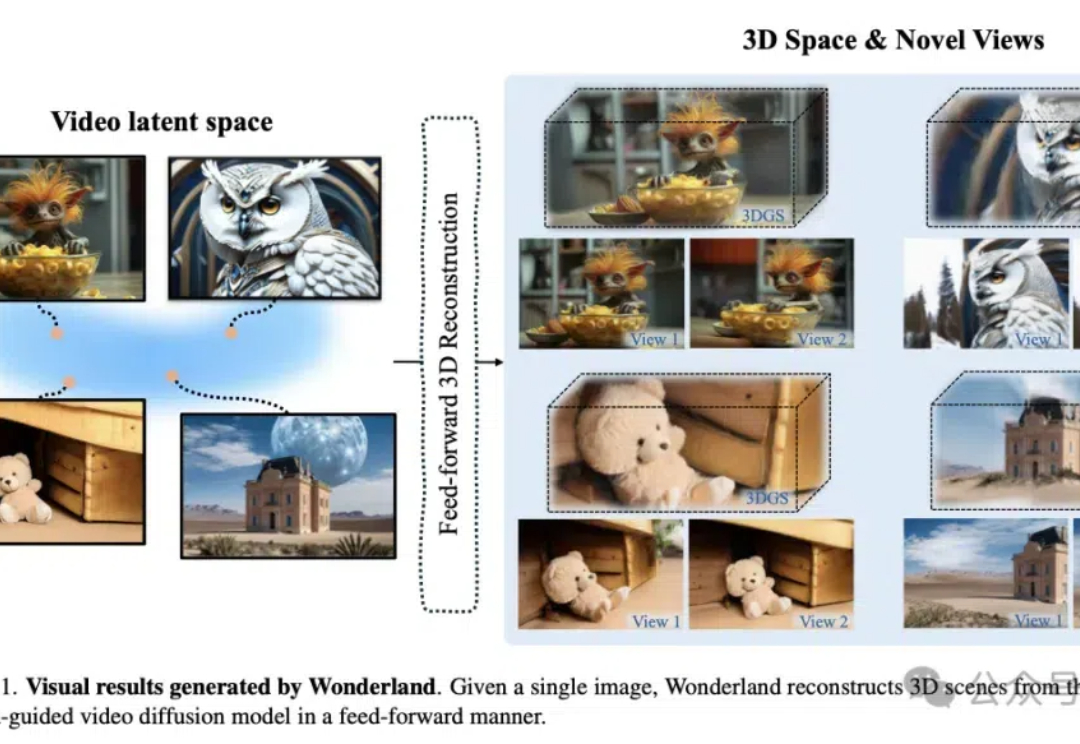

在人类的认知中,从单张图像中感知并想象三维世界是一项天然的能力。我们能直观地估算距离、形状,猜想被遮挡区域的几何信息。然而,将这一复杂的认知过程赋予机器却充满挑战。

游戏本质上是虚拟模拟,而虚拟模拟在过去的几十年里,一直是为了好玩而设计的。但是,我们将越来越多地看到它们在现实世界中用于各种用例,无论是培训、学习和发展,还是用于机器人和其他自主系统的训练场,亦或是可视化,来让人们实时看到事物变得栩栩如生。

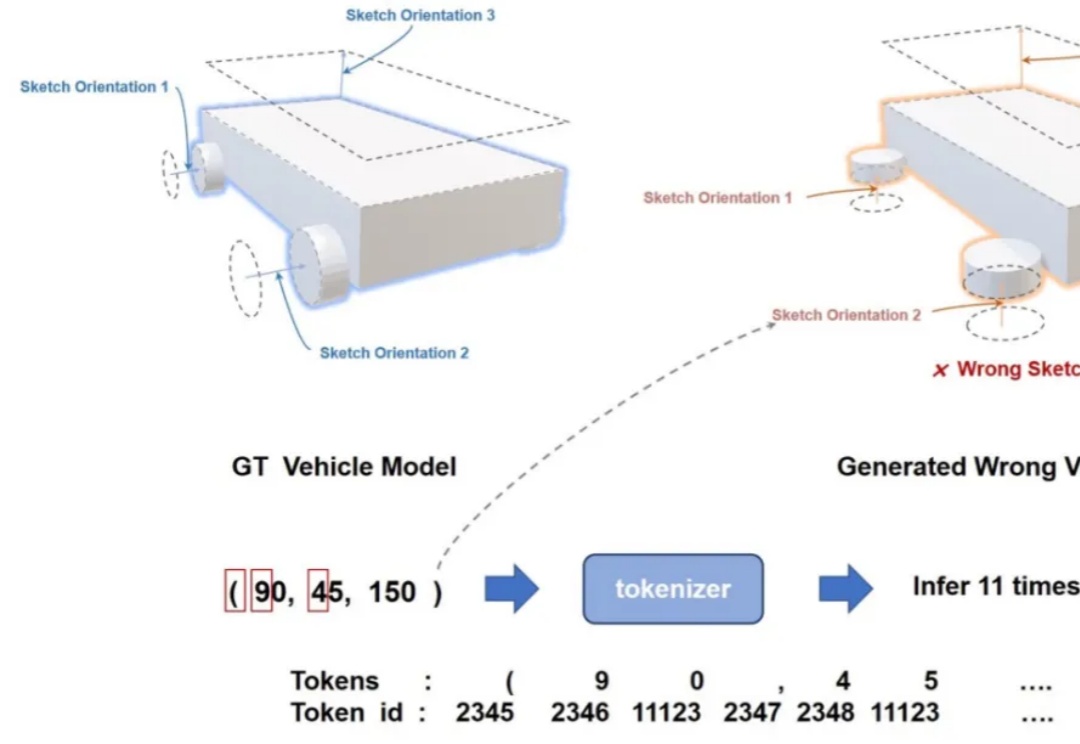

计算机辅助设计(CAD)已经成为许多行业设计、绘图和建模的标准方法。如今,几乎每一个制造出来的物体都是从参数化 CAD 建模开始的。

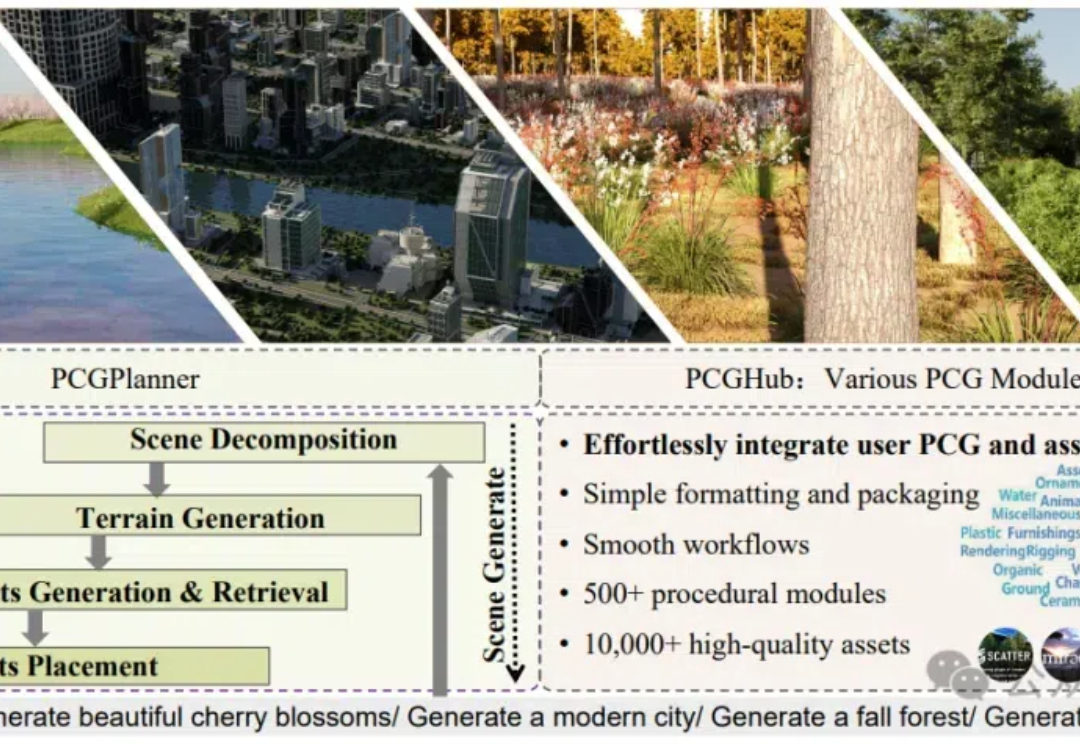

SceneX是一个创新的3D场景生成框架,能根据简单的文字描述快速创建高质量、逼真的虚拟场景,大幅提高构建虚拟世界的效率和灵活性。

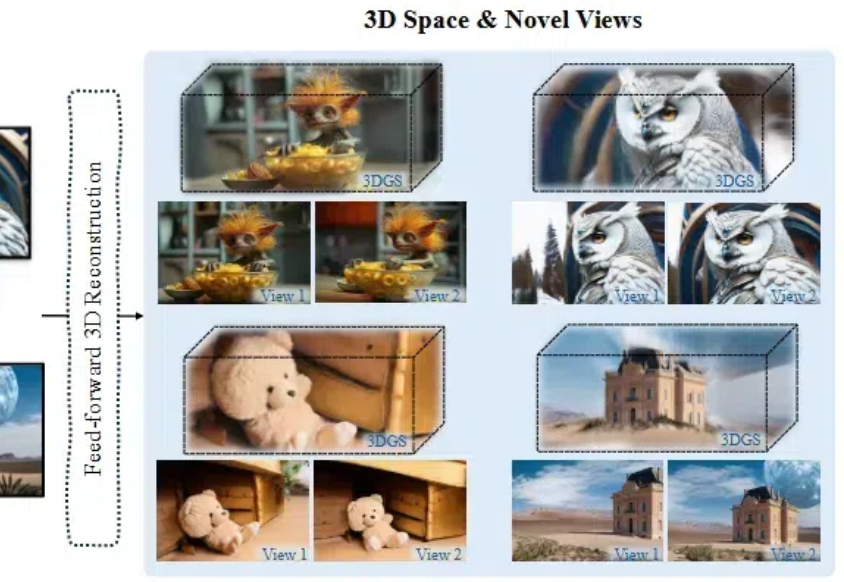

只需一张图,就能生成高质量、广范围的3D场景! 泰迪熊、花园、山谷都从平面图片变成了仿佛触手可及的立体物品。

全球用户累计生成700万3D模型,海外上千用户上传自己生成的3D动画短片……

我们生活在一个感官丰富的 3D 世界中,视觉信号围绕着我们,让我们能够感知、理解和与之互动。

梵蒂冈联合Iconem与微软,通过40万张照片和AI技术,在不到一个月内完成圣彼得大教堂的3D复刻,完美还原这座400多年历史的地标。2025禧年临近,无论身处何地,皆可零距离感受这一宗教与艺术奇迹。

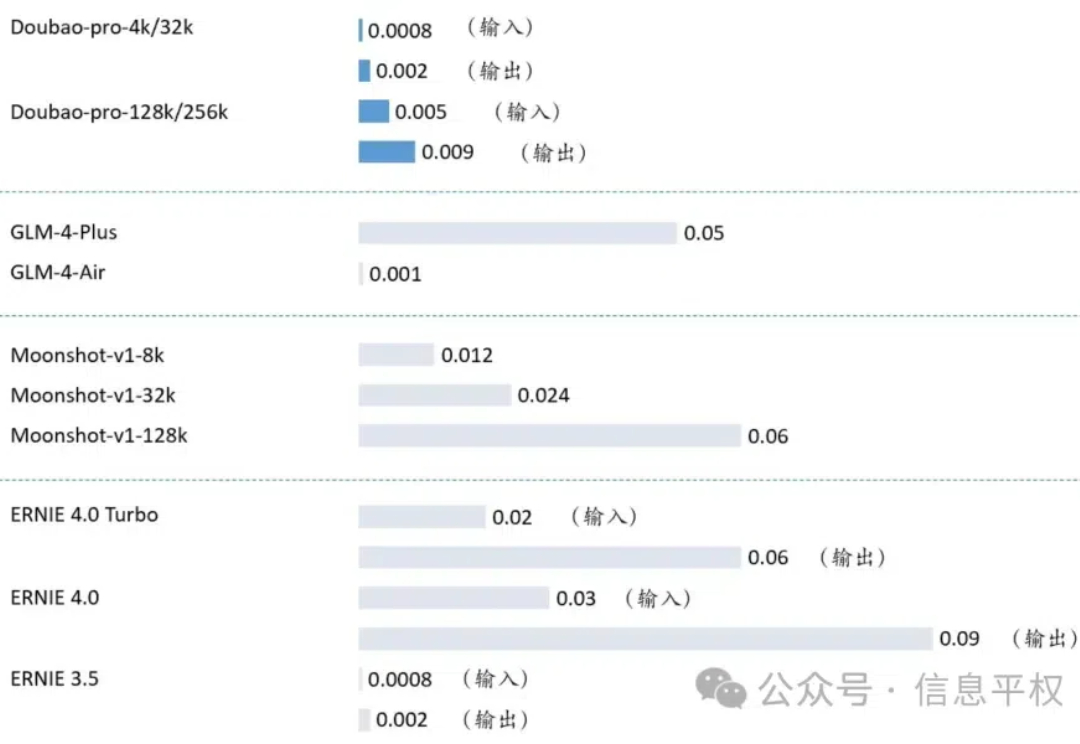

字节前几天的发布会,上线了一堆新的模型:视觉理解、3D 生成,以及全线降价