刚刚,谷歌摊牌:Genie 3让你1秒「进入」名画,人人可造交互世界!

刚刚,谷歌摊牌:Genie 3让你1秒「进入」名画,人人可造交互世界!谷歌最新发布的Genie 3世界模型,正以惊人AI能力颠覆想象:从文本生成交互式空间,到进入经典名画如《苏格拉底之死》和《夜游者》自由探索,甚至训练3D模型实现沉浸式体验!

谷歌最新发布的Genie 3世界模型,正以惊人AI能力颠覆想象:从文本生成交互式空间,到进入经典名画如《苏格拉底之死》和《夜游者》自由探索,甚至训练3D模型实现沉浸式体验!

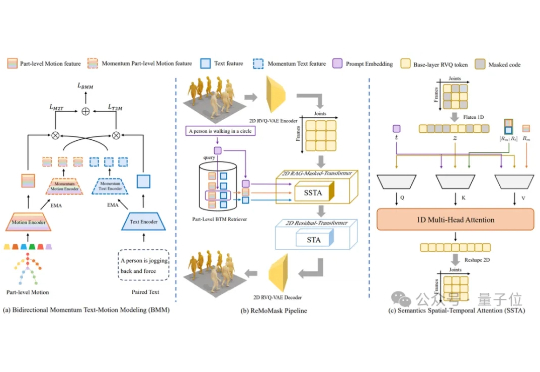

北京大学提出了ReMoMask:一种全新的基于检索增强生成的Text-to-Motion框架。它是一个集成三项关键创新的统一框架:(1)基于动量的双向文本-动作模型,通过动量队列将负样本的尺度与批次大小解耦,显著提高了跨模态检索精度;(2)语义时空注意力机制,在部件级融合过程中强制执行生物力学约束,消除异步伪影;(3)RAG-无分类器引导结合轻微的无条件生成以增强泛化能力。

只需一句话,就能生成可实时交互的3D世界。 刚刚,谷歌DeepMind发布了新一代通用世界模型Genie 3。

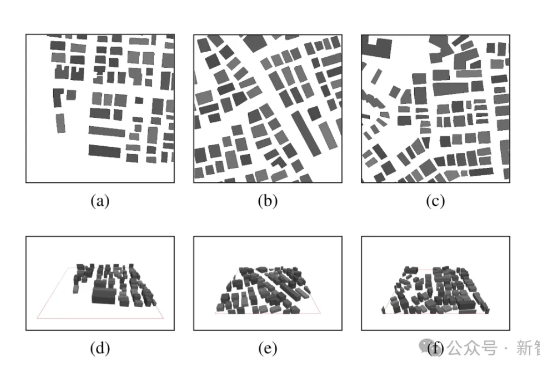

当前环境感知通信正逐步成为第六代移动通信系统(6G)的核心使能技术之一。为支撑其在复杂三维环境下的部署需求,西安电子科技大学、香港中文大学(深圳)和加拿大滑铁卢大学的研究团队联合提出了一个面向6G的高分辨率多模态三维无线电图谱数据集UrbanRadio3D,并构建了基于扩散模型的三维无线电图生成框架RadioDiff-3D。

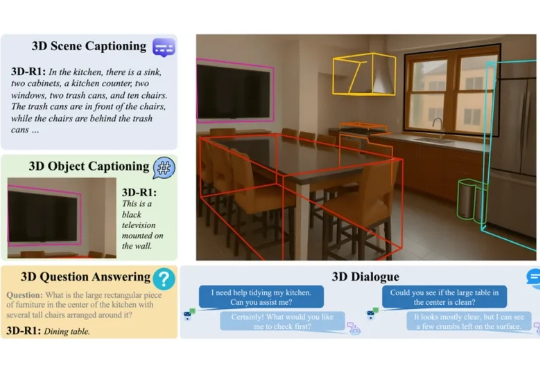

在人工智能快速发展的今天,我们已逐渐习惯于让 AI 识别图像、理解语言,甚至与之对话。但当我们进入真实三维世界,如何让 AI 具备「看懂场景」、「理解空间」和「推理复杂任务」的能力?这正是 3D 视觉语言模型(3D VLM)所要解决的问题。

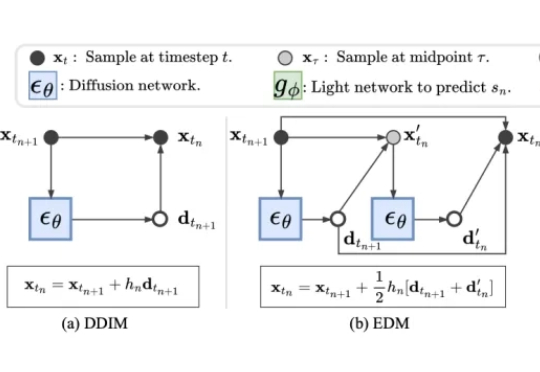

近年来,扩散模型(Diffusion Models)凭借出色的生成质量,迅速成为图像、视频、语音、3D 内容等生成任务中的主流技术。从文本生成图像(如 Stable Diffusion),到高质量人脸合成、音频生成,再到三维形状建模,扩散模型正在广泛应用于游戏、虚拟现实、数字内容创作、广告设计、医学影像以及新兴的 AI 原生生产工具中。

在高质量3D生成需求日益增长的背景下,如何高效生成结构精良、几何精细的三维资产,已成为AIGC和数字内容创作领域的关键挑战。

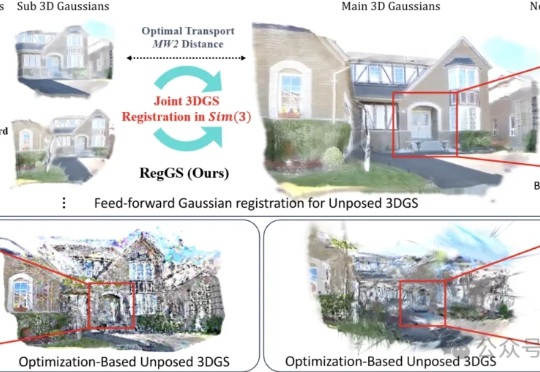

想象一下,你随便用手机拍了几张家里的照片,没有精确的相机位置,甚至照片之间重叠都很少。 现在,一个新算法能把这些零散的2D图片,“拼”成一个厘米级精度的3D数字模型,效果好到可以直接放进VR头显里“云旅游”。

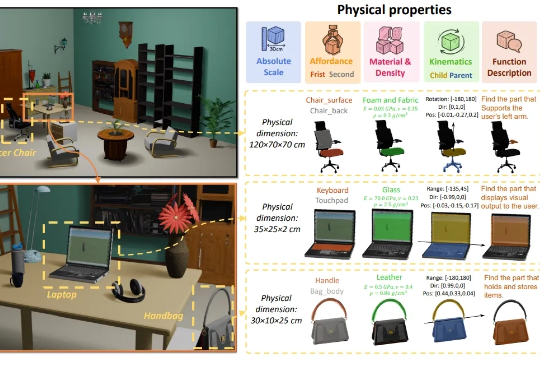

3D生成又补齐了一块重要拼图——物理属性! 南洋理工大学-商汤联合研究中心S-Lab,及上海人工智能实验室合作提出了PhysXNet,号称首个系统性标注的物理基础3D数据集。

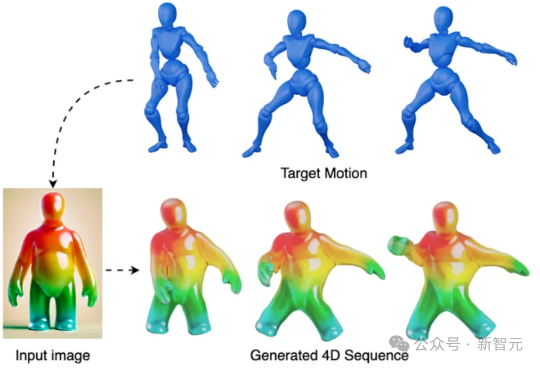

PhysRig是UIUC与Stability AI联合提出的首个面向角色动画的可微物理绑定框架。通过将刚性骨架嵌入弹性软体体积,并使用Material Point Method(MPM)进行可微分物理模拟,PhysRig能够自然还原皮肤、脂肪、尾巴等柔性结构的变形过程,显著提升角色动画的真实感,解决传统LBS无法克服的体积丢失与变形伪影问题。