效果好到刷屏的Nano Banana,学术特供版热乎出炉!

名字就是如此直观——PaperBanana,给你每天都在头痛的Paper用上Banana。(试图押韵skr)

而且这一次是由谷歌北大强强联手打造。

知道你想马上看效果,别急,三个官方案例这就给大家搬上桌。

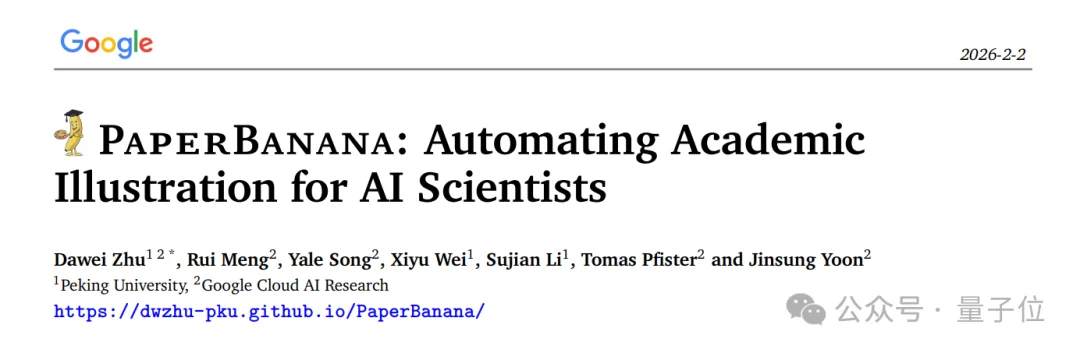

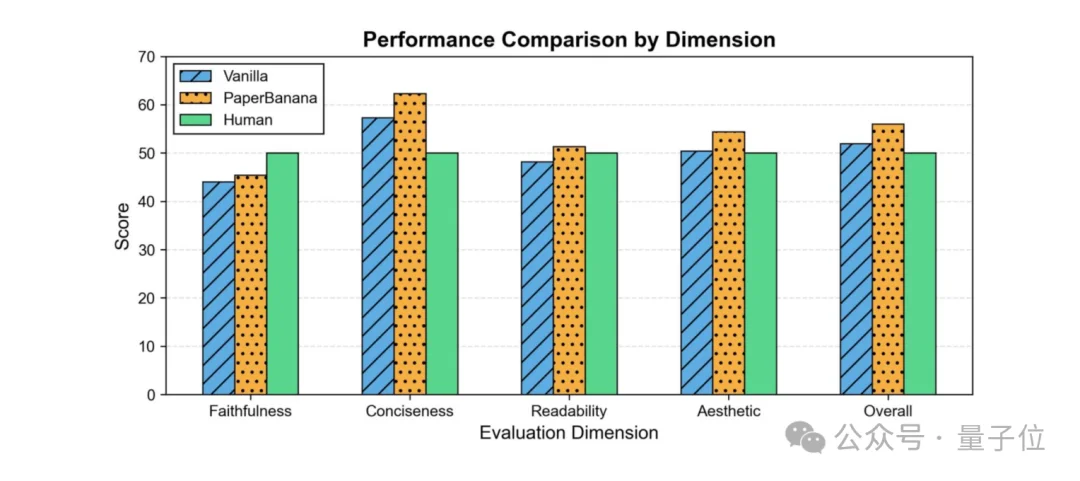

在相同输入下,人类绘制、原版Nano Banana与PaperBanana生成的论文插图对比如下:

综合评估显示,PaperBanana在美观性、简洁性与逻辑清晰度上均全面优于原版。

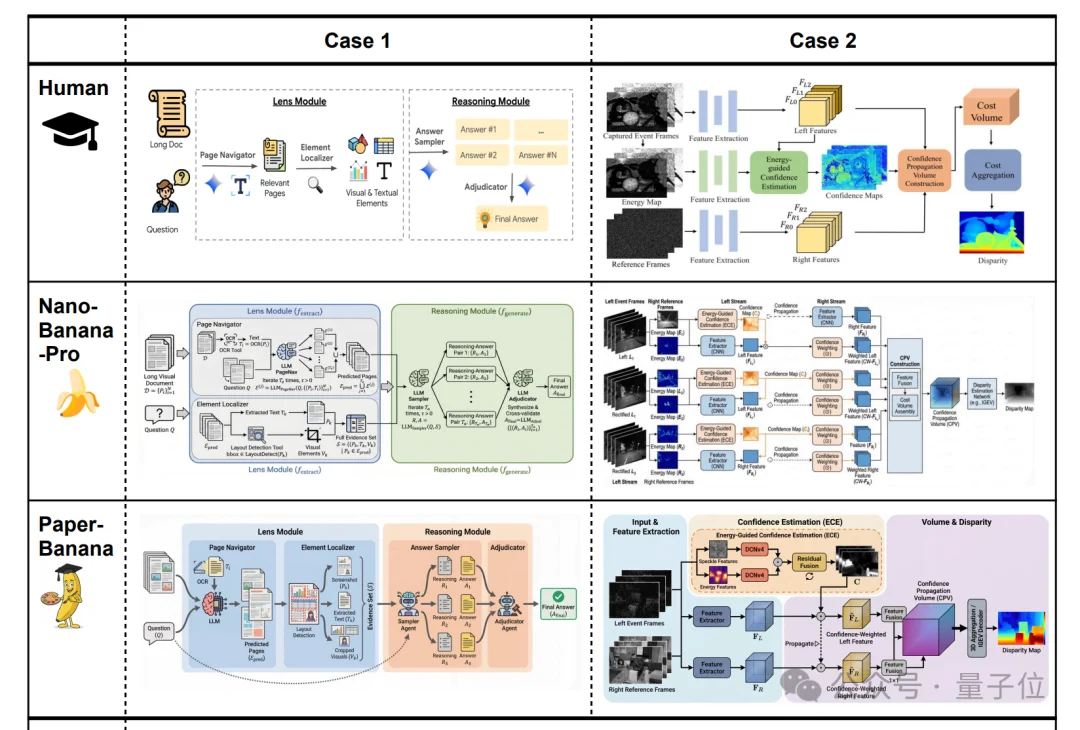

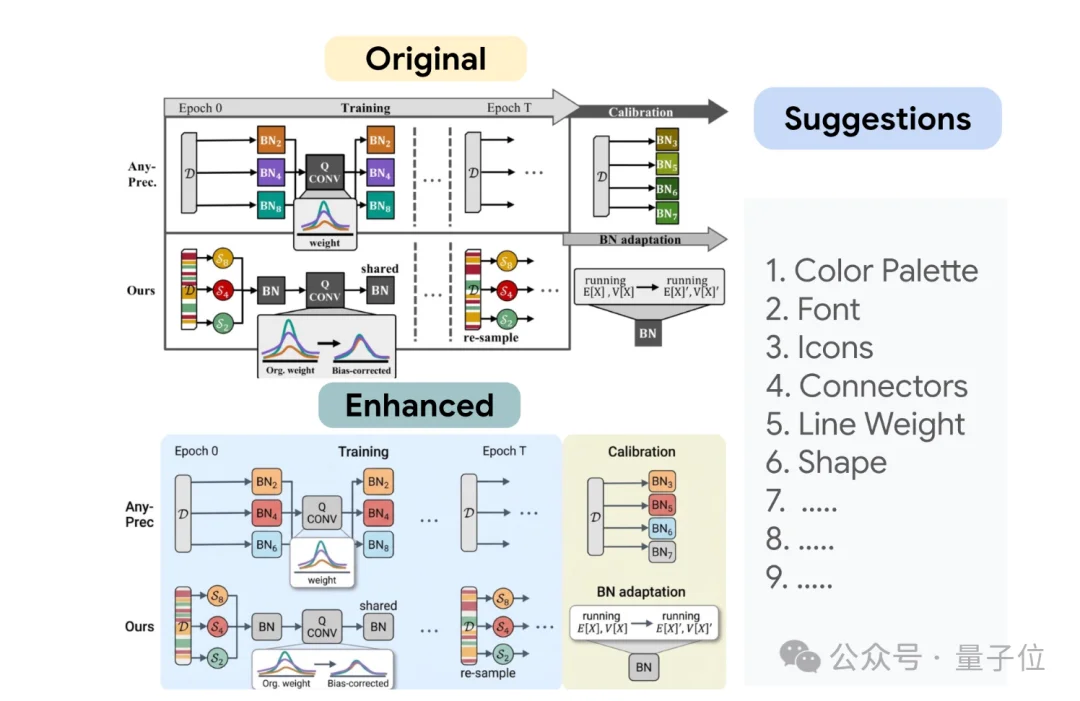

而且它还能直接优化人工绘制的插图,瞅瞅右边,是不是高级感一下就上去了。

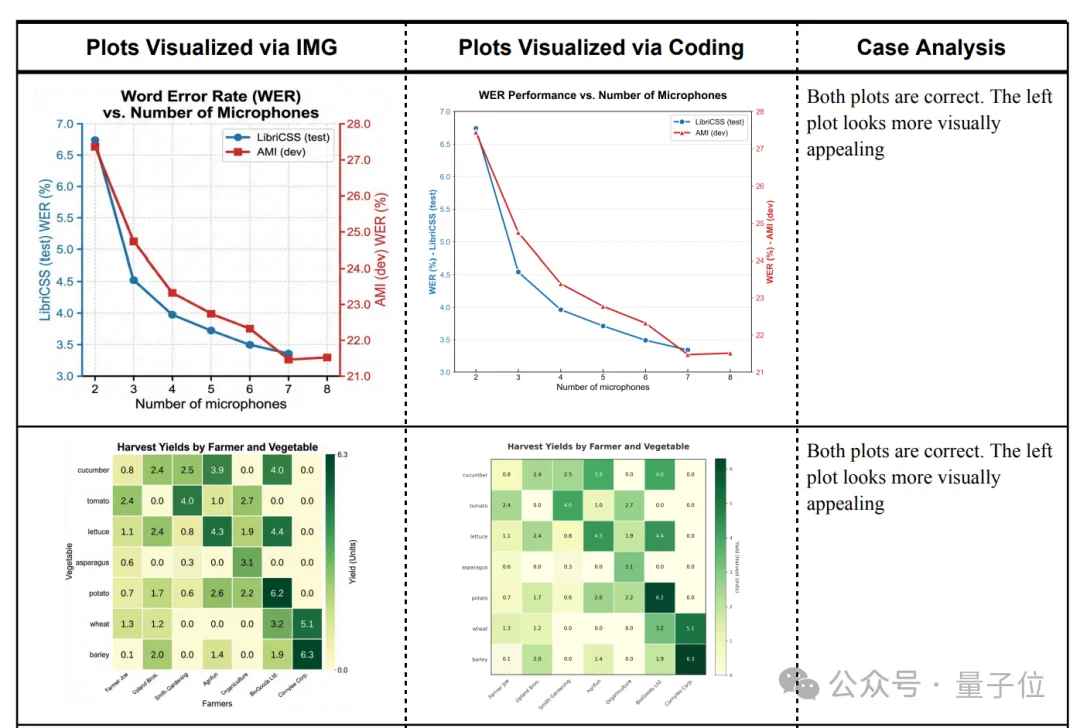

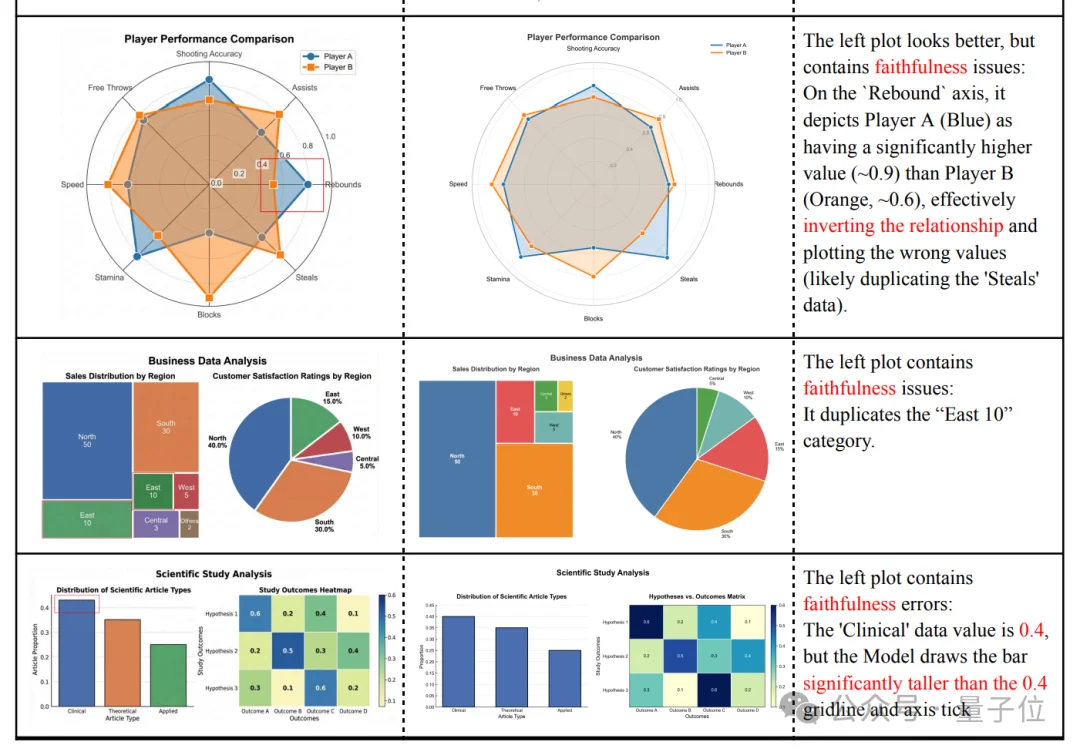

此外,由于PaperBanana还提供代码出图功能 (即利用Gemini-3-Pro自动生成并执行Python可视化代码出图),所以它还能用来生成需要数值100%精准的各种图表。

好好好,既能拿捏高级感,又不忘精准度,应该没有学术人不爱吧~

论文作者表示,PaperBanana为全自动生成可用于出版的插图铺平了道路。

我们希望这个框架能成为连接复杂科学概念与高效视觉叙事的桥梁,赋能每一位研究者,用专业级的视觉语言清晰呈现其发现。

而在看到其效果之后,一众网友也纷纷感叹“学术插图”这个老大难总算是要被攻克了。

想想以前的日子,真真是要落泪了~

研究人员花费4个小时在Figma中绘制一张图,简直令人难以置信。

那么,学术版PaperBanana是如何炼造的呢?

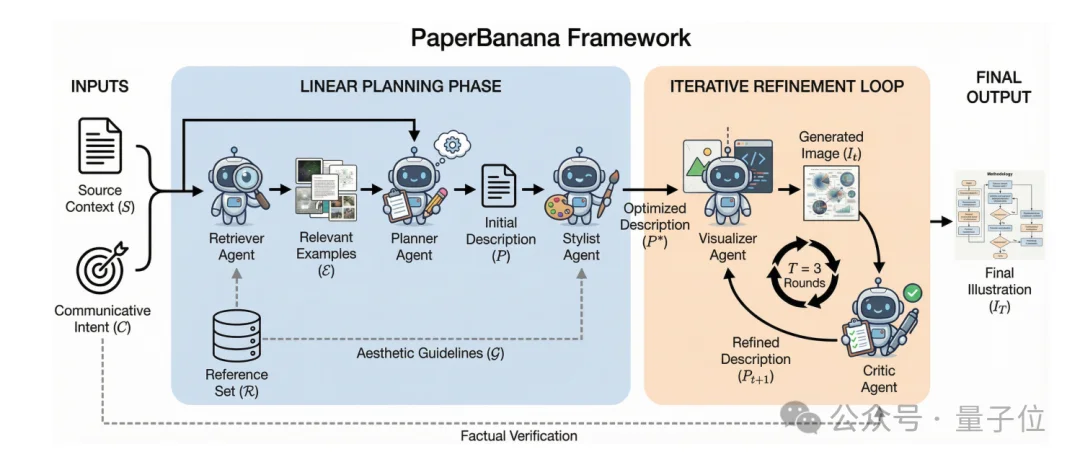

用一个模型生图怎么够,现在都是多智能体齐上阵了。

没错,PaperBanana背后就是5个分工明确的智能体在起作用。

下面这张图清晰展示了它们的工作流程:

划重点,连这张图也是PaperBanana自己生成的。

论文作者表示,这一过程参考了人类制作论文插图的流程。

以制作一个模型架构图为例,通常研究人员会先去看看顶会里类似工作的图是怎么画的,找找灵感和规范。

这一步就对应了检索智能体的工作。

然后就需要根据参考来规划自己的图该怎么画,“我的方法有几个关键模块?”、“数据流和逻辑顺序是怎样的?”,在想清所有关键问题后,脑子里大概就有一幅架构蓝图了。

而到这一步还不是真正动笔的时候,因为还需要结合自己的图以及之前看过的“顶会审美”标准,来给蓝图加点设计感。

有了这两样东西(蓝图+审美),现在就可以真正出图了。

并且出完之后,研究人员往往还需要检查一番,以确保出图正确无误。

怎么样?是不是一环扣一环、且全都一一对应上了。

而在了解完PaperBanana的工作方式后,接下来的问题在于:

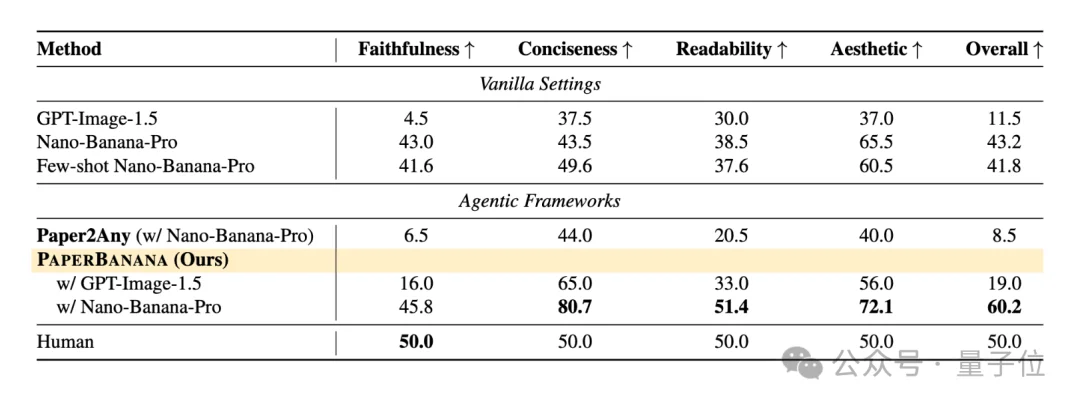

怎么评估PaperBanana的生图效果?

对此,团队还专门构建了一个PaperBananaBench。该基准内容源自NeurIPS 2025——

他们从5275篇论文中随机采样2000篇,经过滤、人工校验后,得到584个有效样本,然后将其均分为292个测试样本和292个参考样本。

这292个参考样本,每一个都提取了完整的(S, C, I)三元组:

参考样本集构成了一个高质量的“学术插图数据库”,主要供检索智能体进行查询和匹配。

而与之对应的292个测试样本,在评估时则仅提供S、C作为输入。其对应的I作为隐藏的标准答案,不参与生成过程,仅用于最终的质量比对与评分。

准备到这里,接下来就是具体生成和评估了。

裁判方面,他们采用了“VLM-as-a-Judge”(大模型当裁判)的评估范式——

让强大的视觉语言模型(如Gemini-3-Pro)作为评委,将PaperBanana生成的图与测试集中隐藏的标准答案I进行逐项对比。

对比的维度主要有四个:忠实性、简洁性、可读性、美观性。

若PaperBanana表现优于标准图得100分,劣于得0分,持平得50分,最终计算总分。

而实验结果表明,PaperBanana在所有维度上全面超越了传统的单模型直接生成(Vanilla)等基线方法。

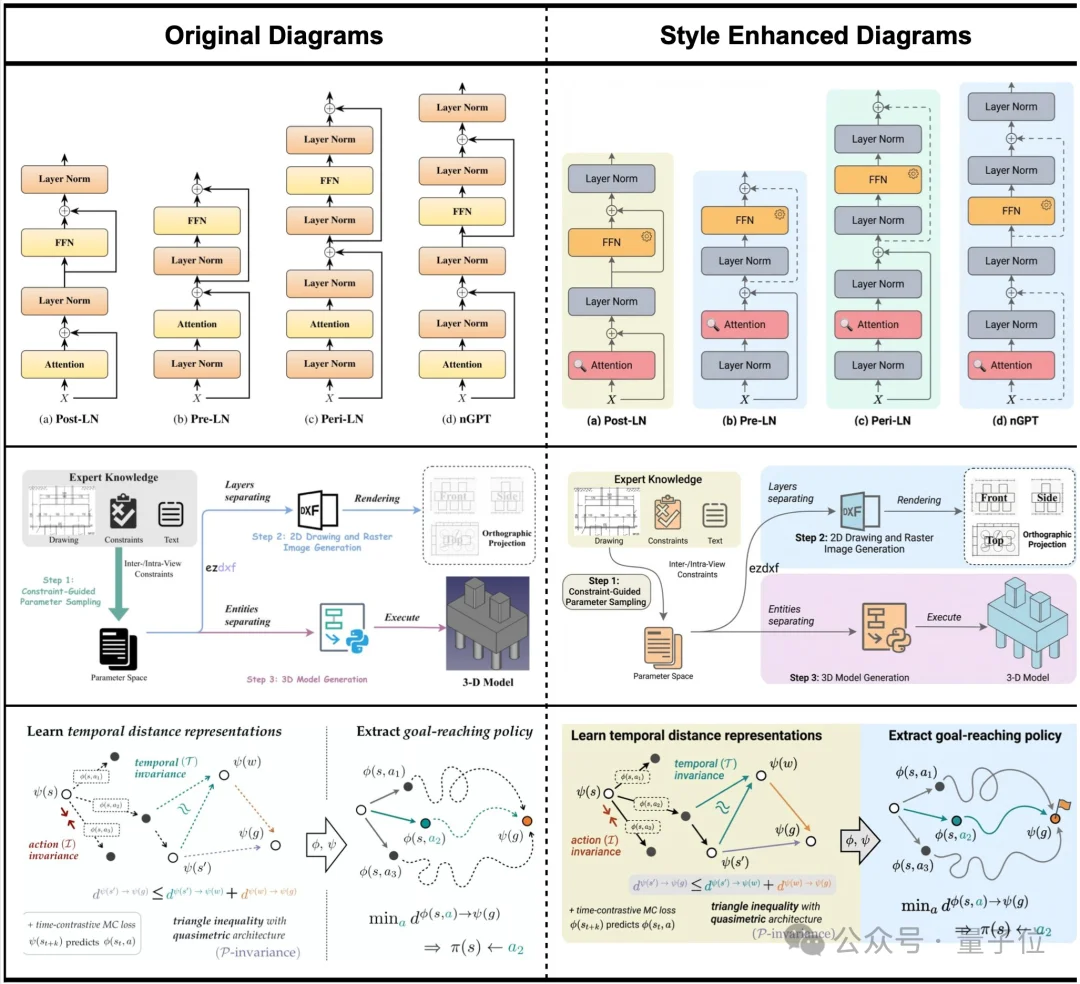

这里需要说明,在生成图表方面,PaperBanana有两种模式:

一种是代码生成模式(默认)。让Gemini-3-Pro这类模型自动写Python可视化代码(如Matplotlib),再运行代码出图。优点是可以保证数值绝对准确,适合需要严格精度的场景。

另一种是直接生图模式(可选方式)。跳过代码,让图像生成模型直接根据文本描述生成图表。优点是视觉效果更顶,但数值容易出现幻觉问题。

左图直接生图模式下,红框圈选出来的就是一些错误问题,而右侧的代码生图模式明显无误,但美观度略逊。

最后的消融实验证明,检索参考、风格优化、批判迭代这三个环节缺一不可,它们共同保证了最终图像的“准确”与“好看”。

不过也需要提醒,PaperBanana目前仍有一些局限性,比如它作为生图还无法编辑,同时在很多细节忠实度方面仍比不上人类手工作业。

所以,更保险的做法或许是,让它帮你优化以前绘制过的图。

在下面这套“手图蜕变”流程下,很多图都能变得更美观、更高级……当然也更容易入顶会的眼(doge)。

最后介绍下PaperBanana背后的团队。

一共7人,可以清晰分成两拨——

一拨来自北大,主要提供NLP与多模态理解的学术根基;另一拨来自Google Cloud AI Research,负责多模态系统与工业化视角。

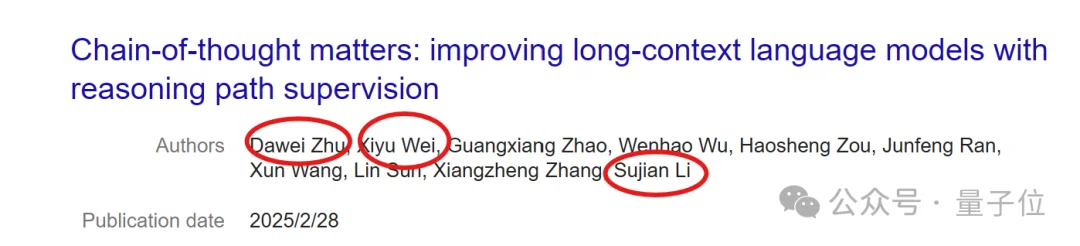

署名第一的Dawei Zhu(兼通讯作者),本硕博均就读于北大,现为北大四年级博士生。

他重点研究长上下文建模和多模态数据,之前在微软亚洲研究院实习过,目前是Google Cloud AI Research学生研究员,PaperBanana也是他在谷歌期间参与的项目。

借着北大这条线,另外两位来自北大的分别是Xiyu Wei和Sujian Li(兼通讯作者)。

Sujian Li目前是北大计算机学院长聘副教授,也是Dawei Zhu的博导,主要研究自然语言处理、信息抽取等。

而Xiyu Wei目前是北大二年级硕士生,曾和Dawei Zhu合作过一篇关于拓展上下文的论文,另外和导师Sujan Li的一篇论文《QuRL:Rubrics As Judge For Open-Ended Queston Answering》刚被ICLR 2026接收。

而其他几位来自Google Cloud AI Research的分别是:

负责人Tomas Pfister、高级研究科学家Yale Song、研究科学家Rui Meng和Jinsung Yoon(兼通讯作者)。

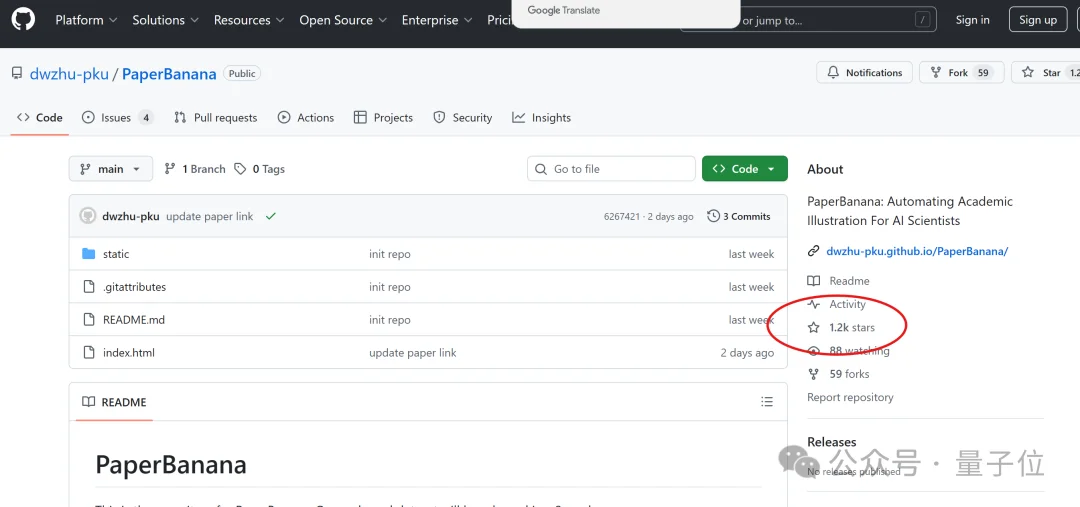

截至目前,PaperBanana已在开源社区GitHub揽获上千star,感兴趣可以继续关注。

项目主页:

https://dwzhu-pku.github.io/PaperBanana/

论文:

https://arxiv.org/abs/2601.23265

GitHub地址:

https://github.com/dwzhu-pku/PaperBanana

参考链接:

[1]https://x.com/AlphaSignalAI/status/2018815238829928711

[2]https://x.com/dwzhu128/status/2018405593976103010

文章来自于“量子位”,作者 “一水”。

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】字节工作流产品扣子两大核心业务:Coze Studio(扣子开发平台)和 Coze Loop(扣子罗盘)全面开源,而且采用的是 Apache 2.0 许可证,支持商用!

项目地址:https://github.com/coze-dev/coze-studio

【开源免费】n8n是一个可以自定义工作流的AI项目,它提供了200个工作节点来帮助用户实现工作流的编排。

项目地址:https://github.com/n8n-io/n8n

在线使用:https://n8n.io/(付费)

【开源免费】DB-GPT是一个AI原生数据应用开发框架,它提供开发多模型管理(SMMF)、Text2SQL效果优化、RAG框架以及优化、Multi-Agents框架协作、AWEL(智能体工作流编排)等多种技术能力,让围绕数据库构建大模型应用更简单、更方便。

项目地址:https://github.com/eosphoros-ai/DB-GPT?tab=readme-ov-file

【开源免费】VectorVein是一个不需要任何编程基础,任何人都能用的AI工作流编辑工具。你可以将复杂的工作分解成多个步骤,并通过VectorVein固定并让AI依次完成。VectorVein是字节coze的平替产品。

项目地址:https://github.com/AndersonBY/vector-vein?tab=readme-ov-file

在线使用:https://vectorvein.ai/(付费)

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md