长期以来,多模态代码生成(Multimodal Code Generation)的训练严重依赖于特定任务的监督微调(SFT)。尽管这种范式在 Chart-to-code 等单一任务上取得了显著成功 ,但其 “狭隘的训练范围” 从根本上限制了模型的泛化能力,阻碍了通用视觉代码智能(Generalized VIsioN Code Intelligence)的发展 。同时,「SFT-only」的范式在确保代码可执行性和高视觉保真度方面存在显著瓶颈 。

在此背景下,中科院 & 美团研究团队推出了 VinciCoder ,一个旨在打破 SFT 瓶颈的统一多模态代码生成模型。VinciCoder 首次将强化学习的奖励机制从文本域转向视觉域,提出视觉强化学习(ViRL) ,专攻 SFT 无法解决的视觉保真度难题。

本文提出的系统性框架 VinciCoder,通过 “大规模 SFT + 粗细粒度 ViRL” 的两阶段策略,有效统一了从图表、网页、SVG 到科学绘图(LaTeX、化学分子)等多样化代码生成任务 。

数据代码模型权重已开源。

该论文同样对传统 SFT 范式的局限性进行了深入分析,发现其关键问题在于训练目标与最终任务之间存在 “视觉鸿沟”:

这种 “视觉 - 代码” 监督的缺失,直接导致了两个关键问题:

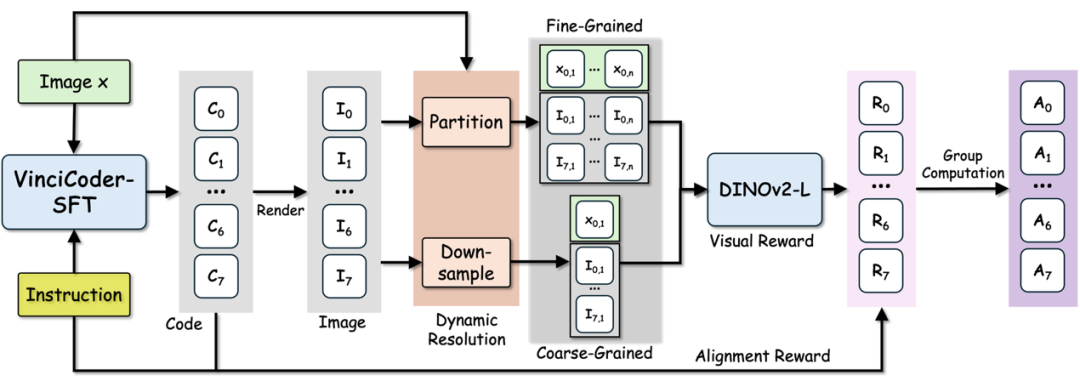

考虑到 SFT 的根本局限性,研究者认为必须引入一个能够提供全局视觉反馈的机制。然而,传统的 RL 方法依赖难以泛化的 “基于规则的文本奖励” 。VinciCoder 的破局点在于 —— 将奖励机制从文本域彻底转向视觉域 。

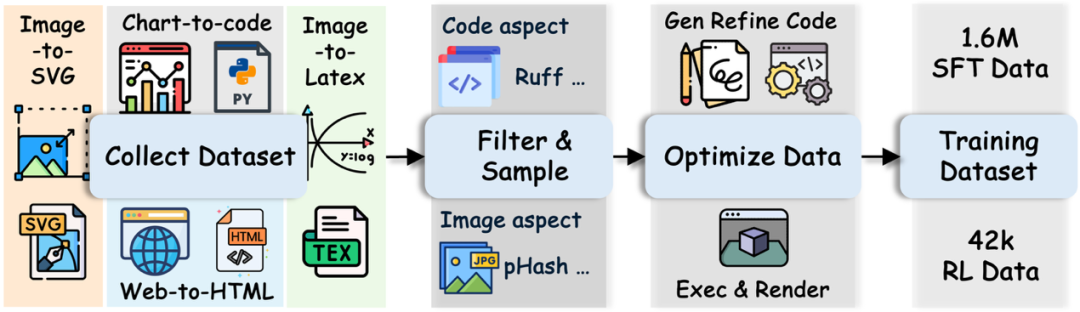

VinciCoder 的核心思路是:用大规模、多样化的 SFT 构建强大的代码基础能力 ,再通过创新的 ViRL 策略专门优化 SFT 无法触及的视觉保真度和可执行性 。训练框架由「1.6M 大规模 SFT 阶段」和「42k 粗细粒度 ViRL 阶段」两部分组成 ,核心是通过两阶段协作,同时实现强大的代码理解与高保真的视觉对齐。

研究团队首先构建了一个包含 1.6M 图像 - 代码对的大规模监督微调(SFT)语料库 。该语料库不仅覆盖了直接代码生成任务,还引入 “视觉代码优化” 的新任务 。在这项任务中,模型会接收到一个目标图像和一个 “有缺陷” 的代码片段(包含逻辑错误或只能部分渲染)。模型的目标是修正这段代码,使其视觉输出与目标图像精确对齐 。这一设计极大地提升了模型在代码层面的纠错和优化能力,为后续的强化学习阶段奠定了坚实基础 。

传统 SFT 训练在多模态代码生成上存在根本缺陷:它缺乏 “视觉 - 代码” 的闭环反馈 ,且无法保证代码的全局可执行性 。

为解决此问题,VinciCoder 引入了视觉强化学习 (ViRL) 框架 。该框架摒弃了传统强化学习中脆弱的、基于规则的 “文本奖励” ,转而从视觉直接获取奖励信号 。

其核心突破在于一套粗 - 细粒度(Coarse-to-fine)视觉奖励机制:

据我们所知,VinciCoder 是第一个应用强化学习(RL)来实现统一视觉代码生成领域中 “跨领域视觉保真度” 提升的视觉语言模型 。

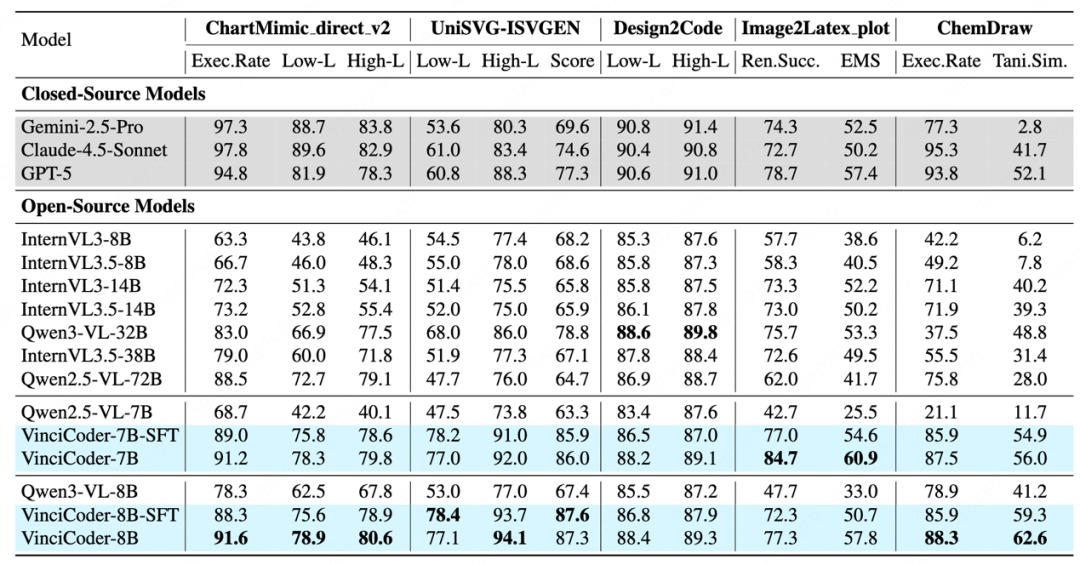

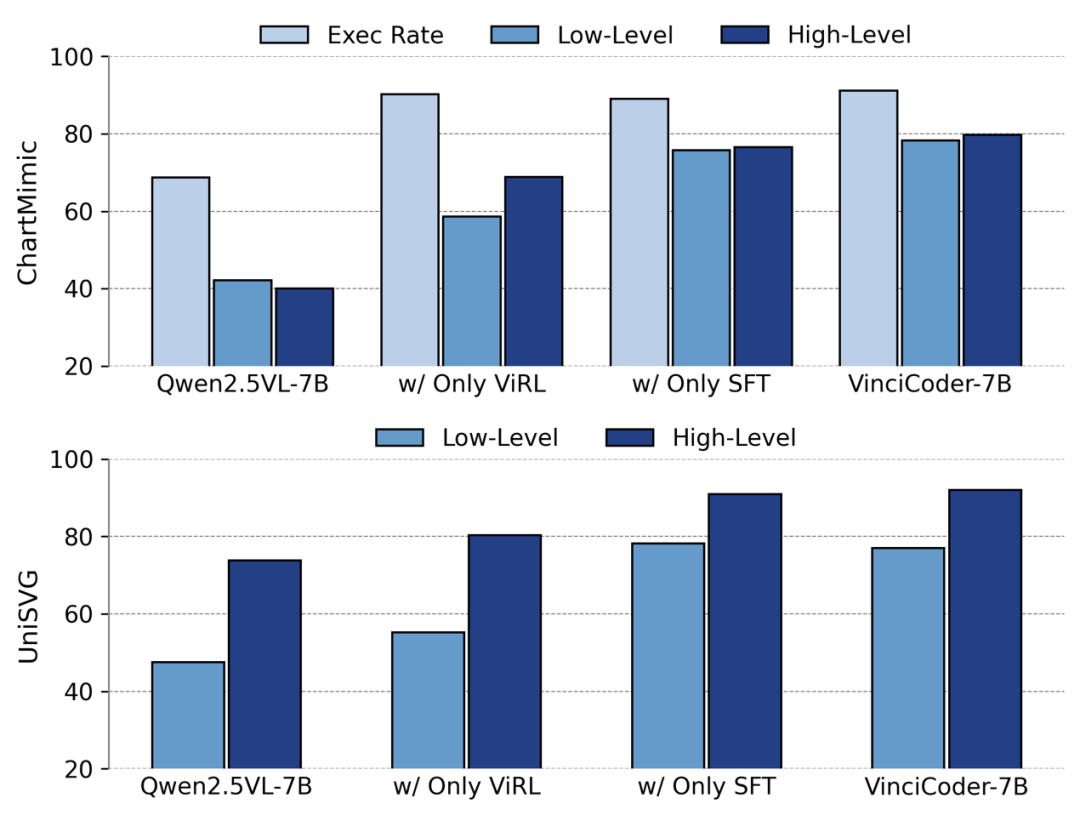

论文在五大多模态代码生成基准上进行了全面实验,对比了包括 Qwen、InternVL 等开源模型以及 Gemini-2.5-Pro、Claude-4.5、GPT-5 等闭源模型 ,核心结果如下:

实验结果令人瞩目:VinciCoder 在多个主流多模态代码生成基准上均取得了卓越表现。

VinciCoder 的研究不仅在技术上取得了重大突破,也为多模态代码生成领域提供了全新的研究范式:

VinciCoder 的核心价值并非单纯地堆砌 SFT 数据,而是通过 “SFT + 粗细粒度 ViRL” 的组合,证明了 “以视觉反馈指导代码生成” 的可行性与优越性。这一思路不仅解决了传统 SFT 范式在可执行性与视觉保真度上的痛点,也为后续通用多模态智能体的研发提供了新的思路。

在总体思路上,该论文的思路与 R1-Style 方法高度相关,都验证了强化学习在提升基础模型高级能力上的巨大潜力。VinciCoder 的成功探索表明,RL 不仅可以用于优化数学推理等文本任务,更可以作为连接 “视觉” 与 “代码” 两大模态的桥梁,解决 SFT 无法企及的跨模态对齐难题。

更多细节请参阅原论文。

文章来自于“机器之心”,作者 “机器之心”。

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner