英伟达赢麻了!马斯克xAI超级算力工厂曝光,10万块H100、数十亿美元

英伟达赢麻了!马斯克xAI超级算力工厂曝光,10万块H100、数十亿美元最近几年,随着大语言模型的飞速发展与迭代,科技巨头们都竞相投入巨额财力打造超级计算机(或大规模 GPU 集群)。他们认为,更强大的计算能力是实现更强大 AI 的关键。

最近几年,随着大语言模型的飞速发展与迭代,科技巨头们都竞相投入巨额财力打造超级计算机(或大规模 GPU 集群)。他们认为,更强大的计算能力是实现更强大 AI 的关键。

算力基础设施建设,北京市有了最新的大动作—— 《北京市算力基础设施建设实施方案(2024-2027年)》

Llama 3诞生整整一周后,直接将开源AI大模型推向新的高度。

大模型发展至今,还能带给开发者哪些惊喜呢? 在 4 月 16 日举办的 2024 百度 Create AI 开发者大会上,百度智能云扔下一颗「重磅炸弹」,重新定义了计算机的核心系统软件 —— 操作系统。

【新智元导读】GPT-5还未发布,GPT-6已经在路上了?微软工程师曝出,为GPT-6搭建10万个H100训练集群,整个电网却被搞崩。通往AGI大关,还需要破解电力难题。

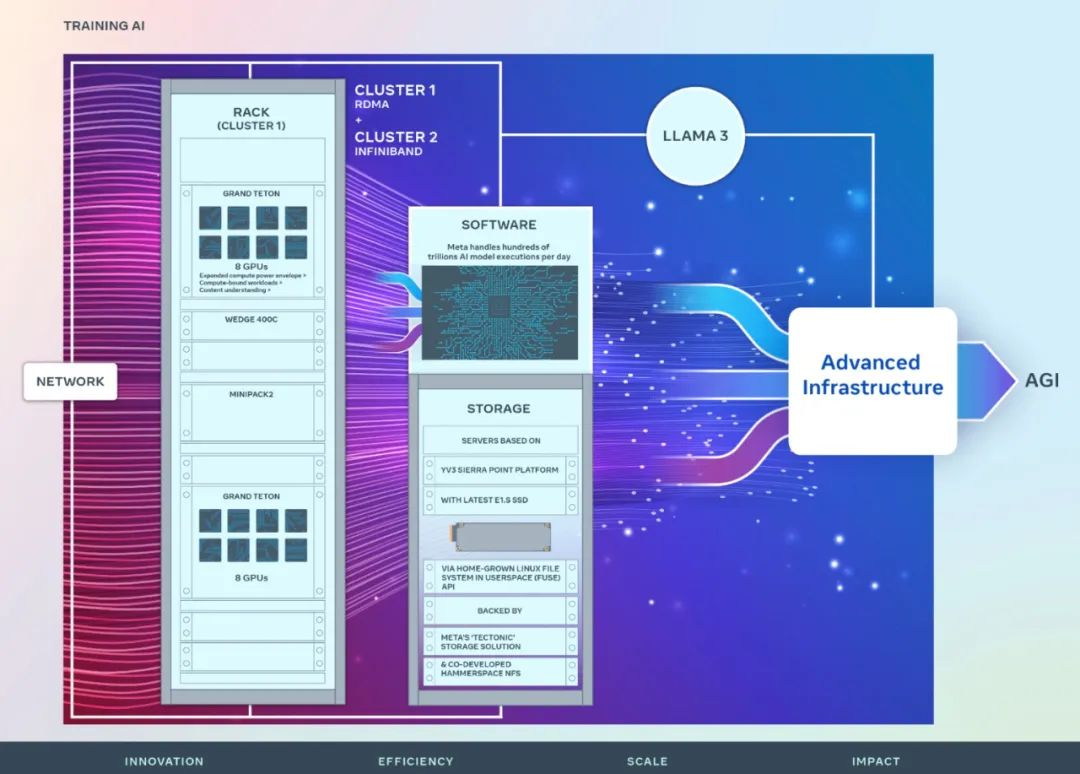

LLM开源从Infra做起!Meta公布了自己训练Llama 3的H100集群细节,看来Llama 3快来了。

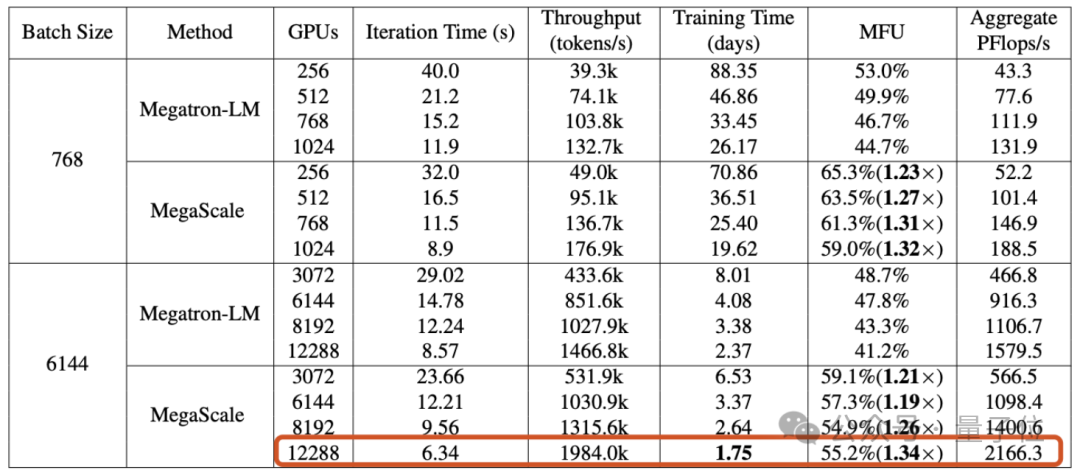

刚刚,Meta 宣布推出两个 24k GPU 集群(共 49152 个 H100),标志着 Meta 为人工智能的未来做出了一笔重大的投资。

随着对Sora技术分析的展开,AI基础设施的重要性愈发凸显。

世界上最快超算集群Frontier,用8%的GPU训练出了一个万亿级规模的大模型,而且是在AMD硬件平台之上完成。研究人员将训练的细节和克服的困难写成了一篇论文,展示了如何用非英伟达的生态完成大模型训练的技术框架和细节。

在过去的一段时间里,“AI-native”成为所有工具的一个显著探索趋势,不论是算力集群的智算中心,还是数据库侧的向量数据库,再或者是不断进化的算法,都在以一种更适配大模型架构的方式被推演出来。