MIT韩松团队长上下文LLM推理高效框架DuoAttention:单GPU实现330万Token上下文推理

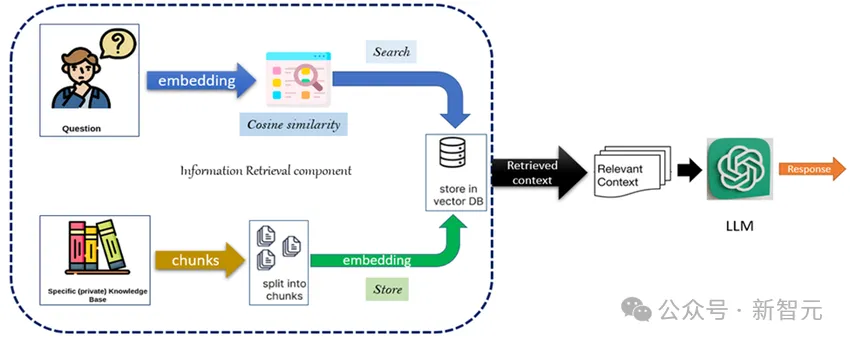

MIT韩松团队长上下文LLM推理高效框架DuoAttention:单GPU实现330万Token上下文推理TL;DR:DuoAttention 通过将大语言模型的注意力头分为检索头(Retrieval Heads,需要完整 KV 缓存)和流式头(Streaming Heads,只需固定量 KV 缓存),大幅提升了长上下文推理的效率,显著减少内存消耗、同时提高解码(Decoding)和预填充(Pre-filling)速度,同时在长短上下文任务中保持了准确率。