英伟达“AI盒子”升级发布软件和服务,黄仁勋打造物理世界的数字副本

英伟达“AI盒子”升级发布软件和服务,黄仁勋打造物理世界的数字副本英伟达NIM新升级,助力AI在多领域应用。

来自主题: AI资讯

10916 点击 2024-07-30 11:38

英伟达NIM新升级,助力AI在多领域应用。

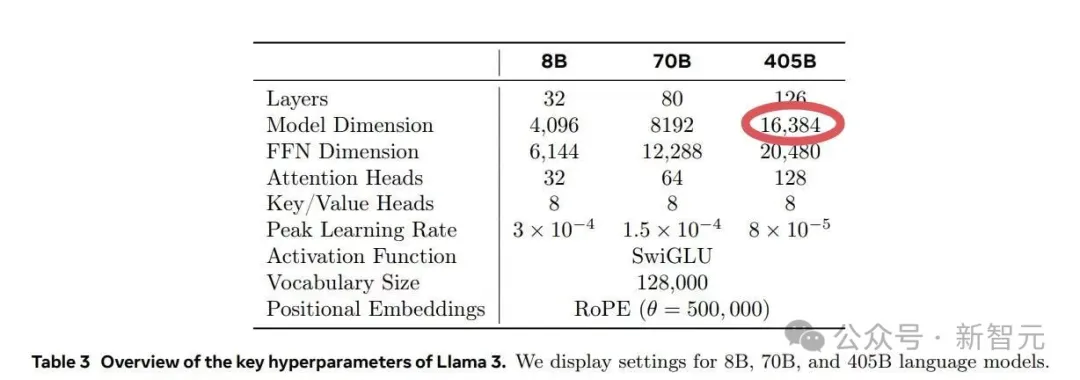

适逢Llama 3.1模型刚刚发布,英伟达就发表了一篇技术博客,手把手教你如何好好利用这个强大的开源模型,为领域模型或RAG系统的微调生成合成数据。

在Meta的Llama 3.1训练过程中,其运行的1.6万个GPU训练集群每3小时就会出现一次故障,意外故障中的半数都是由英伟达H100 GPU和HBM3内存故障造成的。

一周全球AI热点

一半以上的故障都归因于 GPU 及其高带宽内存。

芯片巨头英伟达,在AI时代一直被类比为在淘金热中“卖铲子”的背后赢家。

外媒爆料,英伟达将于明年推出一款专为中国市场定制的AI芯片,甚至还专研了一款与之搭配的服务器,这在英伟达历史上还是首次。

让“老年痴呆”被更早发现的AI医疗,正重获资本青睐

从去年开始,奥特曼就已经开始满世界飞,到处找人拉投资、谈合作,在积极推进他在OpenAI内部实现「自研芯片」的计划。如今,这个和英伟达「脱钩」的想法终于有了一点实际进展。

GPT-4o mini头把交椅还未坐热,Mistral AI联手英伟达发布12B参数小模型Mistral Nemo,性能赶超Gemma 2 9B和Llama 3 8B。