RTX 50系显卡、消费级AI超算,综合12篇官博看黄仁勋如何炸场CES2025

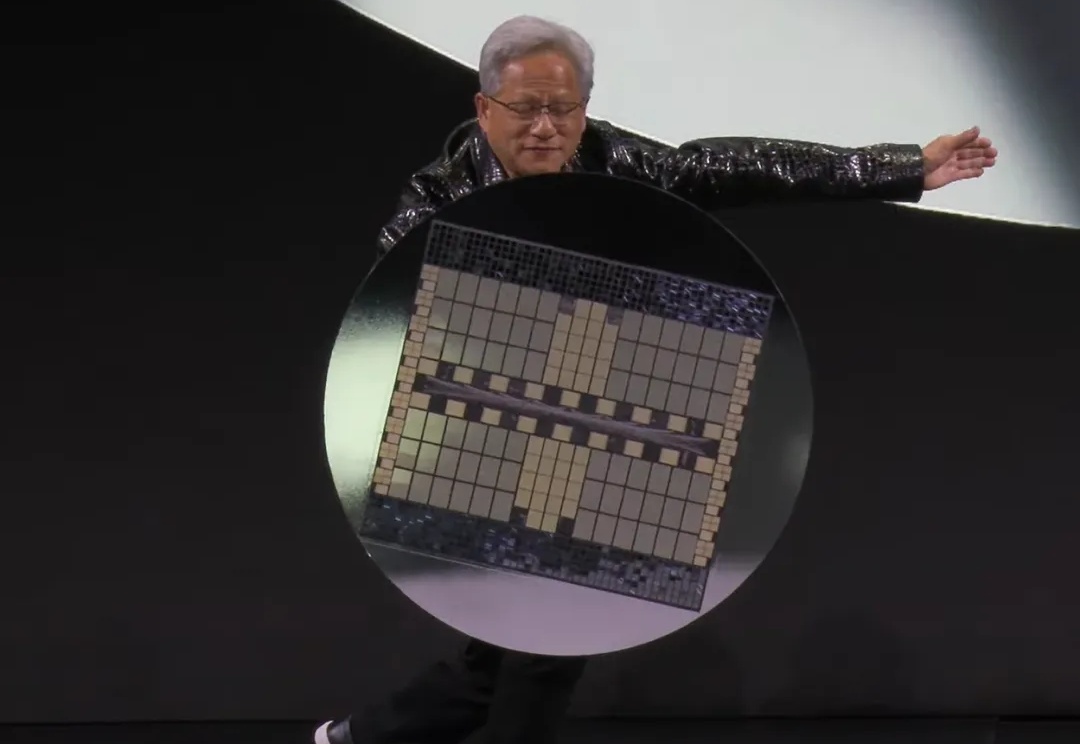

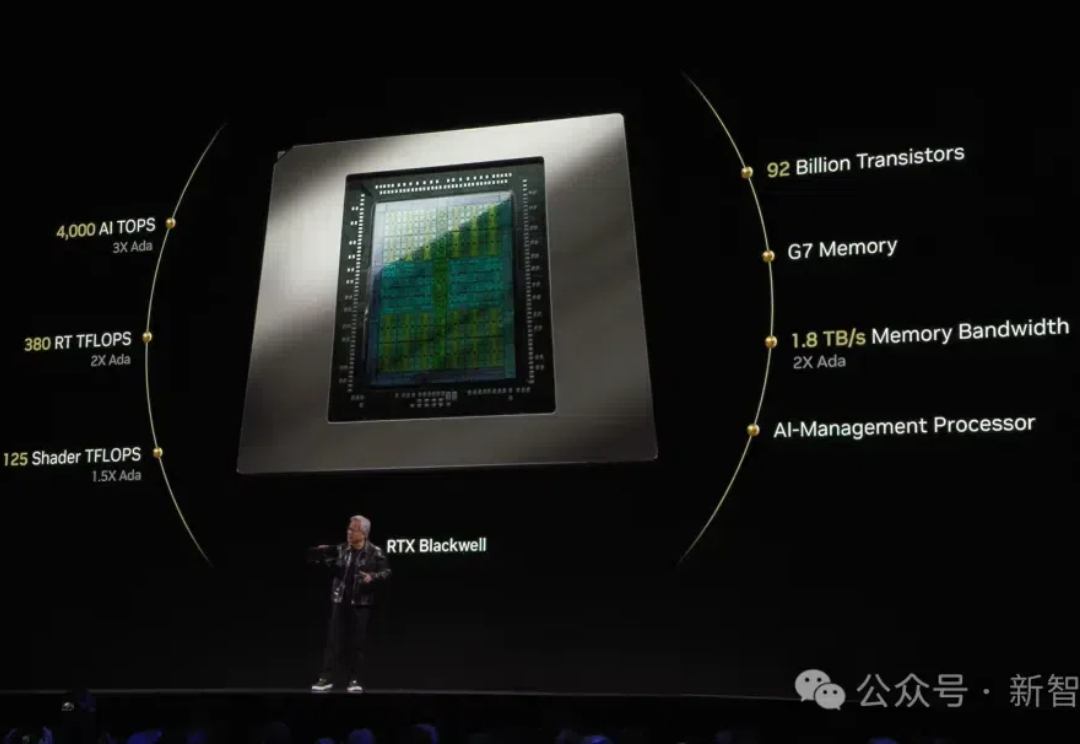

RTX 50系显卡、消费级AI超算,综合12篇官博看黄仁勋如何炸场CES2025三句话提提神, RTX 5070显卡性能媲美4090,价格只要1/3;

三句话提提神, RTX 5070显卡性能媲美4090,价格只要1/3;

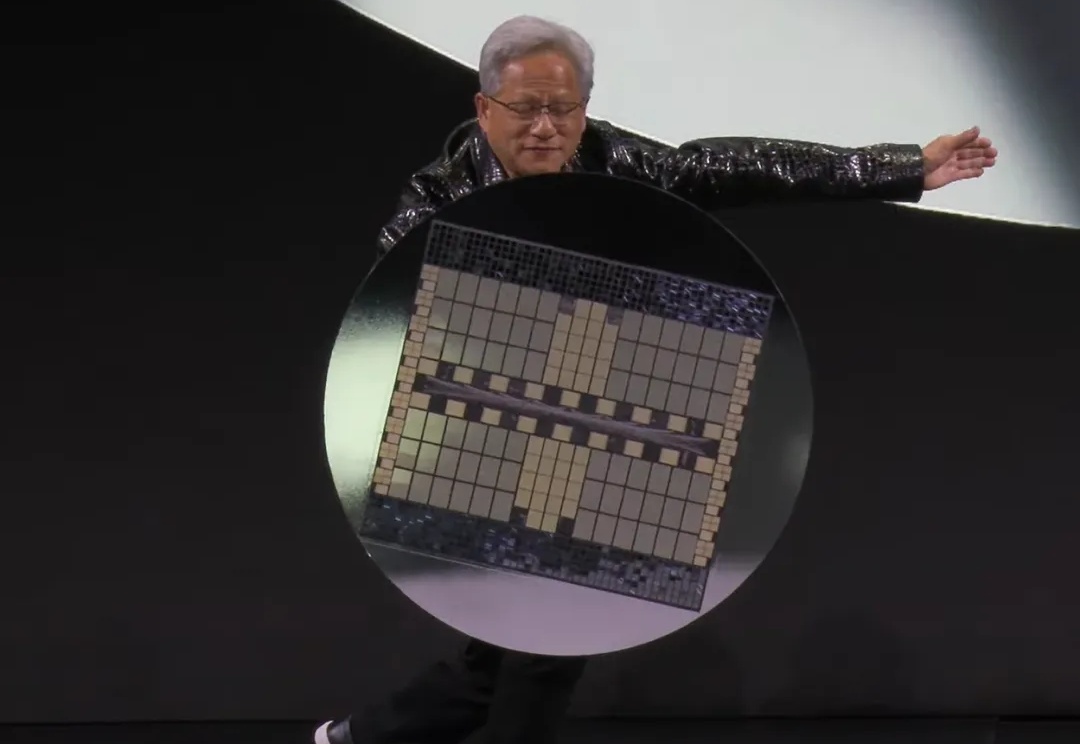

就在刚刚,RTX 5090震撼发布,国行版定价16499元!同时震撼亮相的,还有全球最小AI超算Project Digits,在办公桌上就能跑出数据中心级算力!这一刻老黄摆出别致pose,吸引了全球目光。

游戏玩家最为关心得为英伟达献出多少大洋,黄仁勋却寥寥几页带过了消费级显卡,把大段叙述留给了AI,以及智能体、世界模型、机器人、自动驾驶、超算等因AI渗透发生进展的领域,未来又将如何被英伟达改变。

上周末,外媒 VideoCardz 获得了一张非公版 RTX 5090 的包装盒照片,实锤了新一代旗舰显卡将使用 32GB GDDR7 显存。

最新的AI投资指南

历经8个月,斥资约7亿美元,英伟达终于完成对AI初创Run:ai的收购,进一步完善了在AI领域的布局。Run:ai两位创始人表示,他们将会对软件进行开源。

根据 The Information 报道,字节跳动计划 2025 年斥资 70 亿美元投入英伟达最新的 Blackwell 芯片,该计划由张一鸣主导。

苹果要搞人形机器人这事儿现在传得沸沸扬扬。 最近他们确实有新动作——开发了一套机器人感知系统! 系统名为ARMOR,软硬件协同增强机器人的“空间意识”,能动态防碰撞的那种。

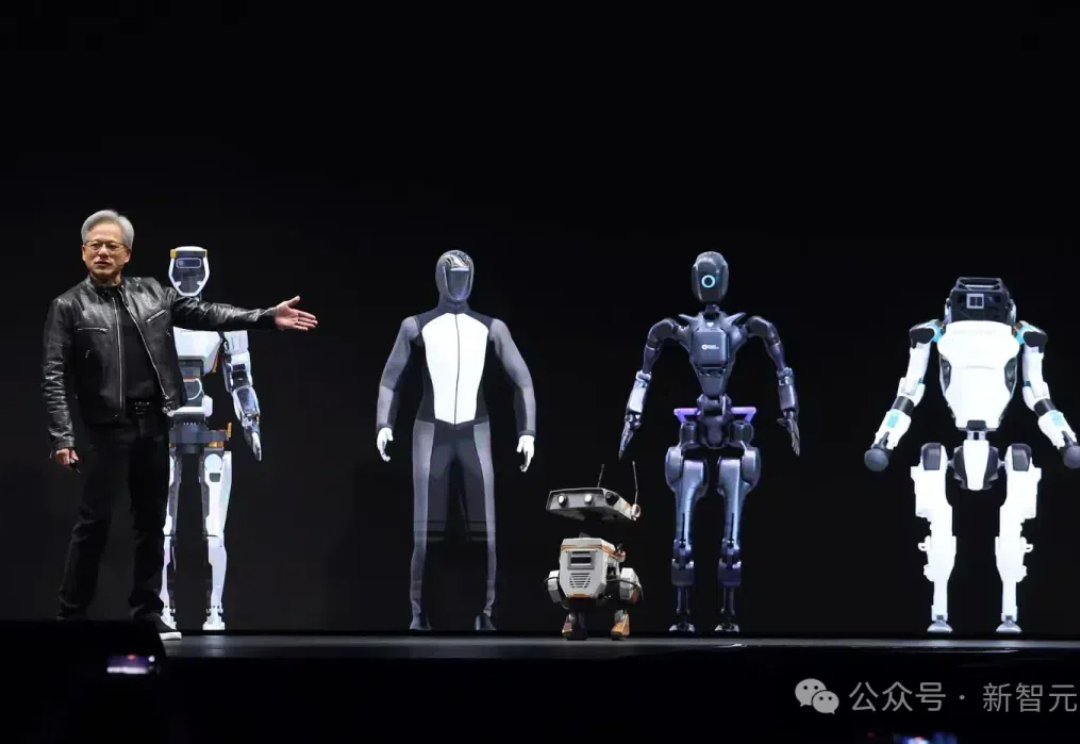

谷歌、亚马逊等巨头纷纷摆脱GPU依赖,于是英伟达选择押注机器人!现在,英伟达已开发了机器人全套解决方案,计划在明年年中发布全新一代人形机器人专用小型计算机Jetson Thor。全球机器人市场,或将迎来大爆发。

一个来自中国的开源模型,让整个AI圈再次惊呼“来自东方的神秘力量”。 昨天,国内知名大模型创业公司“深度求索”通过官方公众号宣布上线并同步开源 DeepSeek-V3模型,并公布了长达53页的训练和技术细节。