10美元成功复现DeepSeek顿悟时刻,3B模型爆发超强推理!微软论文实锤涌现

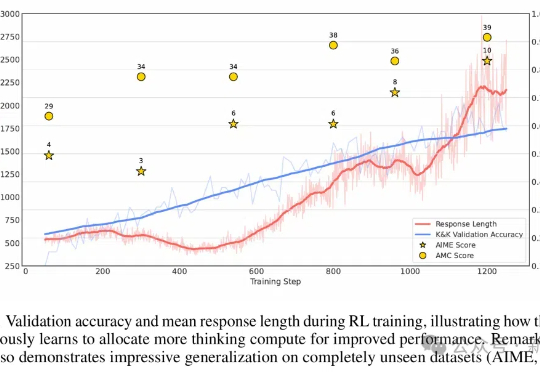

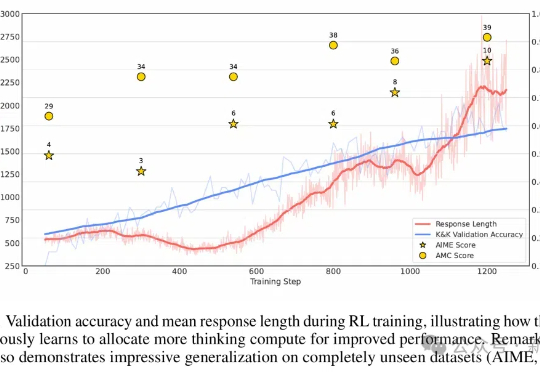

10美元成功复现DeepSeek顿悟时刻,3B模型爆发超强推理!微软论文实锤涌现不到10美元,3B模型就能复刻DeepSeek的顿悟时刻了?来自荷兰的开发者采用轻量级的RL算法Reinforce-Lite,把复刻成本降到了史上最低!同时,微软亚研院的一项工作,也受DeepSeek-R1启发,让7B模型涌现出了高级推理技能。

不到10美元,3B模型就能复刻DeepSeek的顿悟时刻了?来自荷兰的开发者采用轻量级的RL算法Reinforce-Lite,把复刻成本降到了史上最低!同时,微软亚研院的一项工作,也受DeepSeek-R1启发,让7B模型涌现出了高级推理技能。

世界模型(World Model)作为近年来机器学习和强化学习的研究热点,通过建立智能体对其所处环境的一种内部表征和模拟,能够加强智能体对于世界的理解,进而更好地进行规划和决策。

开源AI短剧神器来了!来自昆仑万维,一次性开源两大视频模型——国内首个面向AI短剧创作的视频生成模型SkyReels-V1;国内首个SOTA级别基于视频基座模型的表情动作可控算法SkyReels-A1。

DreamTech,由牛津大学、南京大学等顶尖高校研究者组成的AI创业团队,在春节期间公布了他们在3D生成方向上的新工作成果——Neural4D 2.0(初版名为Direct3D),提出了创新性的3D Assembly Generation算法思路及更高效的模型架构

2月8日,共达地创新技术(深圳)有限公司(以下简称“共达地”)市场负责人李苏南在办公室向记者演示了他们自主研发的“神器”:只需规划好AI应用场景,上传视频、图片等原始数据并定义标注类别,机器便如同经验丰富的AI工程师,自动分析数据特点

谷歌DeepMind的AI,终于拿下IMO金牌了!六个月前遗憾摘银,如今一举得金,SKEST新算法立大功。这不,它首破解了2009 IMO最难几何题,辅助作图的神来之笔解法让谷歌研究员当场震惊。

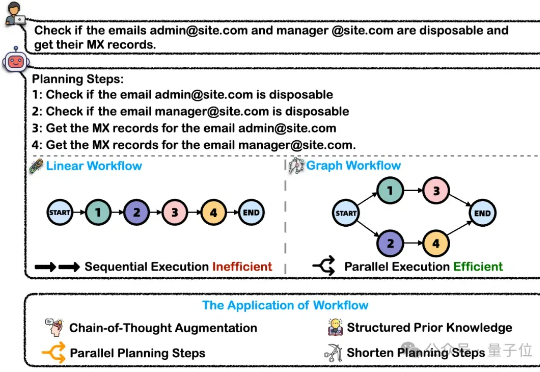

在处理这类复杂任务的过程中,大模型智能体将问题分解为可执行的工作流(Workflow)是关键的一步。然而,这一核心能力目前缺乏完善的评测基准。为解决上述问题,浙大通义联合发布WorfBench——一个涵盖多场景和复杂图结构工作流的统一基准,以及WorfEval——一套系统性评估协议,通过子序列和子图匹配算法精准量化大模型生成工作流的能力。

新一代 Kaldi 团队是由 Kaldi 之父、IEEE fellow、小米集团首席语音科学家 Daniel Povey 领衔的团队,专注于开源语音基础引擎研发,从神经网络声学编码器、损失函数、优化器和解码器等各方面重构语音技术链路,旨在提高智能语音任务的准确率和效率。

宠物大模型健康公司重庆绮算法科技有限公司(以下简称“绮算法”) 作为智谱Z计划企业,近日获得千万元级战略投资,由Z基金独投,融得资金将主要用于产品研发和商业化落地。源合资本担任独家财务顾问,负责后续融资。

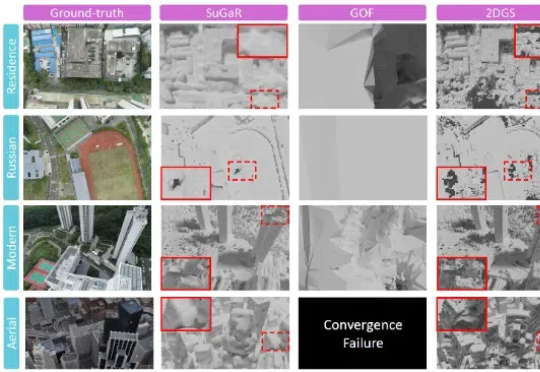

来自中科院自动化所的研究团队提出了用于大规模复杂三维场景的高效重建算法 CityGaussianV2,能够在快速实现训练和压缩的同时,得到精准的几何结构与逼真的实时渲染体验。该论文已接受于 ICLR`2025,其代码也已同步开源。