交大高金朱宁:经济学家视角下AI时代的范式思维转变 | MEET2026

交大高金朱宁:经济学家视角下AI时代的范式思维转变 | MEET2026问题虽然留给大家思考了,但身为一名经济学家,他还是从专业角度为我们勾勒了一幅清晰而令人警醒的图景:当算力、创意、时间这些曾被视为“稀缺”的人类核心优势逐渐被AI吞没,那么以这些稀缺性为基础构建起来的整套经济学逻辑——从资源配置、生产结构到收入分配,无疑也将随之被撼动。

问题虽然留给大家思考了,但身为一名经济学家,他还是从专业角度为我们勾勒了一幅清晰而令人警醒的图景:当算力、创意、时间这些曾被视为“稀缺”的人类核心优势逐渐被AI吞没,那么以这些稀缺性为基础构建起来的整套经济学逻辑——从资源配置、生产结构到收入分配,无疑也将随之被撼动。

AI领域共分成四个层次:AI技术应用、AI的算法算力、AI的体系架构、AI哲学。其中,「AI哲学」超越AI技术应用、算法算力、体系架构,属于最顶层阶段——「形而下者谓之器、形而上者谓之道」,将超越AI的「器」、「技」、「法」、「术」层面,上升到AI更高的「道」的层面。

AI基建市场,再现黑马!近日,此前名不见经传的荷兰AI基础设施公司Nebius,在短短3个月间连续斩获微软价值194亿美元(约合人民币1379亿元)与Meta价值30亿美元(约合人民币213亿元)的两笔算力大单,引发业界关注。

面对谷歌TPU的攻势,英伟达开始紧张了。

觉得大模型消耗的算力过大,英伟达推出的8B模型Orchestrator化身「拼好模」,通过组合工具降本增效,使用30%的预算,在HLE上拿下37.1%的成绩。

Googel和IBM十年打不穿的量子天花板,被一块1万qubit的芯片掀开了?巨头还在百级徘徊,量子突然跨进了能落地的时代。更讽刺的是,真正接住这场变革的,是早已埋伏在算力入口的英伟达。

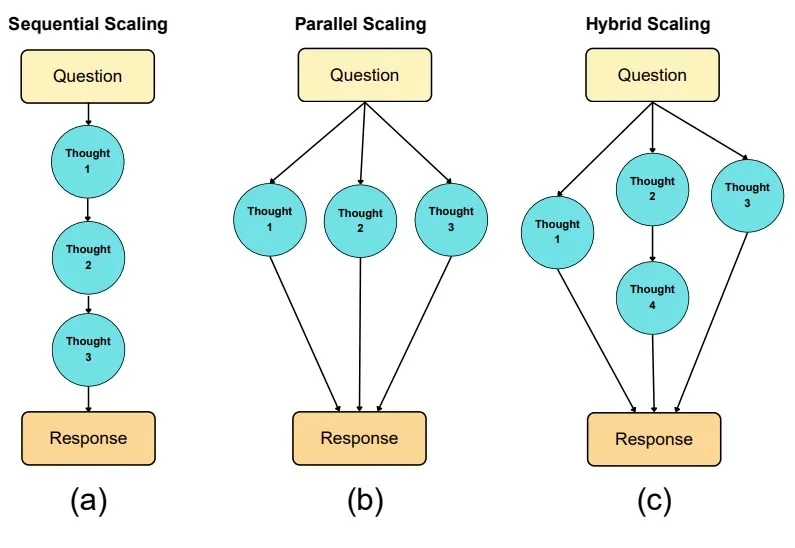

如果说大模型的预训练(Pre-training)是一场拼算力、拼数据的「军备竞赛」,那么测试时扩展(Test-time scaling, TTS)更像是一场在推理阶段进行的「即时战略游戏」。

为了打破英伟达的算力垄断,谷歌正在扶持云服务商Fluidstack分发自研TPU芯片,目前该公司正洽谈一轮7亿美元的巨额融资。最有意思的是,本轮融资的潜在领投方,竟是被OpenAI「扫地出门」的天才研究员阿申布伦纳。在这场算力豪赌中,谷歌的野心、前OpenAI核心成员的复仇与资本的狂热正交织在一起。

NeurIPS 2025见证了历史性的分流:清华大学以微弱差距逼近谷歌,中国AI完成了从数量堆叠向底层架构创新的「质变」突围。在圣地亚哥与墨西哥城的双会场之间,签证壁垒切割了物理空间。这是一场关于算力、人才与技术定义权的「双城记」。

在工业界动辄十万卡的暴力美学面前,学术界正沦为算力的「贫民窟」。当高校人均不足0.1张卡时,AI科研的主导权之争或许已经没有了悬念。