20人团队提前实现DeepSeek构想,AI算力变天?直击大模型算力成本痛点

20人团队提前实现DeepSeek构想,AI算力变天?直击大模型算力成本痛点20人国内团队,竟然提前2年预判到了DeepSeek的构想?玉盘AI的全新计算架构方案浮出水面后,直接震动业内:当前AI算力的核心瓶颈,他们试图从硬件源头解决!

20人国内团队,竟然提前2年预判到了DeepSeek的构想?玉盘AI的全新计算架构方案浮出水面后,直接震动业内:当前AI算力的核心瓶颈,他们试图从硬件源头解决!

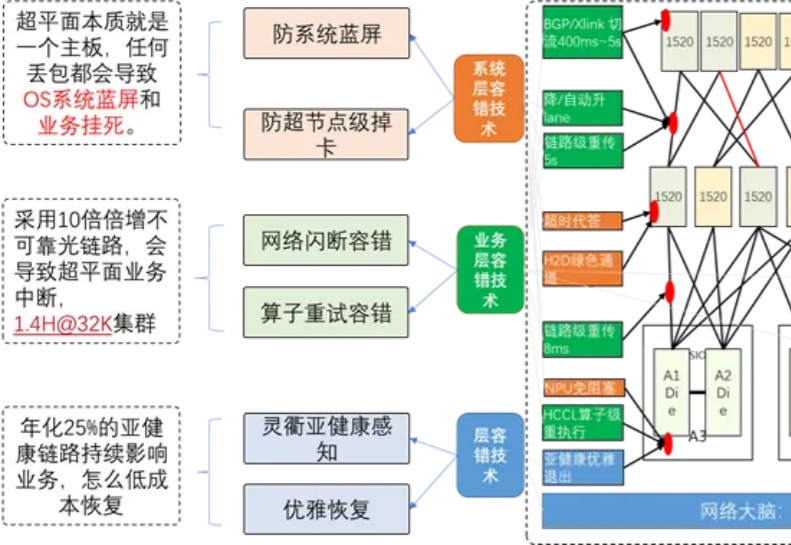

大模型的落地能力,核心在于性能的稳定输出,而性能稳定的底层支撑,是强大的算力集群。其中,构建万卡级算力集群,已成为全球公认的顶尖技术挑战。

付费订阅或许是一切AI助手的归宿,继OpenAI的ChatGPT、谷歌的Gemini,以及Anthropic的Cluade之后,Meta的AI助手Meta AI也准备提供付费订阅服务了。在日前举行的Meta年度股东大会上,扎克伯格除了确认Meta AI已实现10亿月活跃用户的成绩之余,还宣称“随着Meta AI不断改进,未来也将有机会推出付费推荐或额外算力使用的订阅服务。”

你是否注意到,现在的 AI 越来越 "聪明" 了?能写小说、做翻译、甚至帮医生看 CT 片,这些能力背后离不开一个默默工作的 "超级大脑工厂"——AI 算力集群。

国内大厂探索AI变现呈现四类方式:模型产品(订阅)、模型服务(MaaS)、AI功能嵌入主业、算力基础设施。百度、阿里、腾讯、华为处于第一梯队,AI显著拉动营收增长;快手、字节、美图属第二梯队,AI提效主业或打造爆款应用初见成效;科大讯飞、昆仑万维尚处投入期。虽部分路径初步盈利,但巨额研发投入远超当前回报,尚无企业实现AI正现金流,技术投入更多带来市值提升效应。

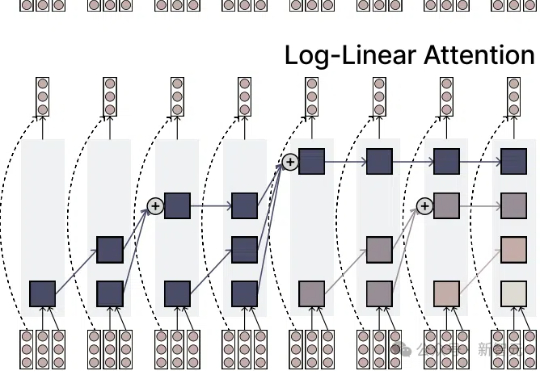

注意力机制的「平方枷锁」,再次被撬开!一招Fenwick树分段,用掩码矩阵,让注意力焕发对数级效率。更厉害的是,它无缝对接线性注意力家族,Mamba-2、DeltaNet 全员提速,跑分全面开花。长序列处理迈入log时代!

hi 家人们,端午假期开心嘛! 除了休息工作,这次假期,我还和一位好久不见的老朋友约了一个聊天局。

生成式AGI已经颠覆了人们的生活,但AI工具并没有随着用户使用场景的融合而整合。各个赛道的头部玩家依靠独家的数据库发展模型,现有算力和数据量难以支撑多模态和跨业务领域拓展,急需形成用户粘性的市场竞争也使得AI的生成稳定性被优先考虑。

年入790亿,ICT龙头冲刺A+H上市。

OpenAI的o3推理模型席卷AI界,算力暴增10倍,能力突飞猛进!但专家警告:最多一年,推理模型可能一年内撞上算力资源极限。OpenAI还能否带来惊喜?