腾讯混元最新开源:一键生成电影级音效,性能表现全面SOTA

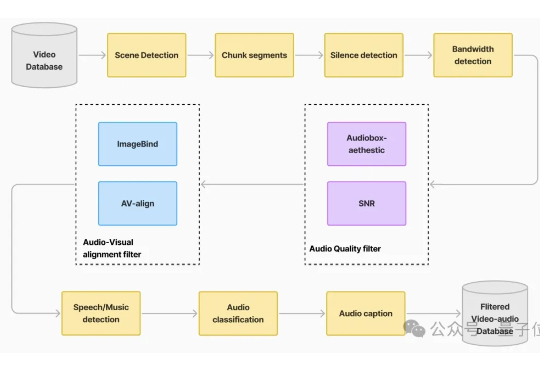

腾讯混元最新开源:一键生成电影级音效,性能表现全面SOTA自带声音的视频生成模型,开源版开卷! 最新赶到的是腾讯混元:刚刚正式开源端到端的视频音效生成模型HunyuanVideo-Foley。

自带声音的视频生成模型,开源版开卷! 最新赶到的是腾讯混元:刚刚正式开源端到端的视频音效生成模型HunyuanVideo-Foley。

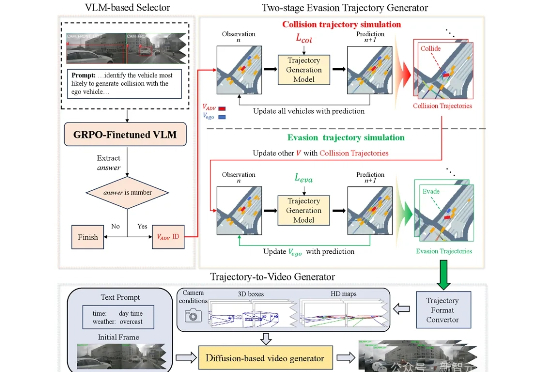

浙江大学与哈工大(深圳)联合推出SafeMVDrive,利用扩散模型结合VLM实现批量化多视角真实域的安全关键视频生成。该方法在保持画质与真实感的同时,显著增强了驾驶场景的危险性。生成的场景用于端到端自动驾驶系统的极限压测,可使得模型的碰撞率提升50倍。

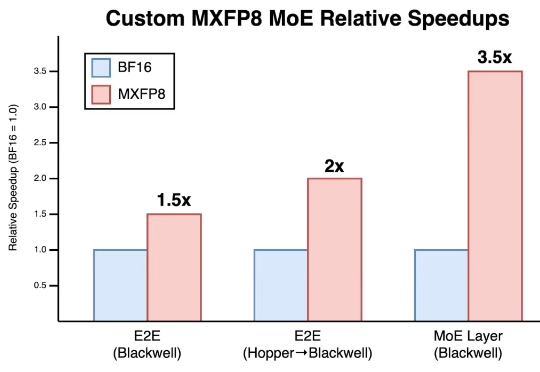

在构建更强大的 AI 模型的这场竞赛中,传统路径很简单:升级到最新最强大的硬件。但 Cursor 发现释放下一代 GPU 的真正潜力远非即插即用那么简单。

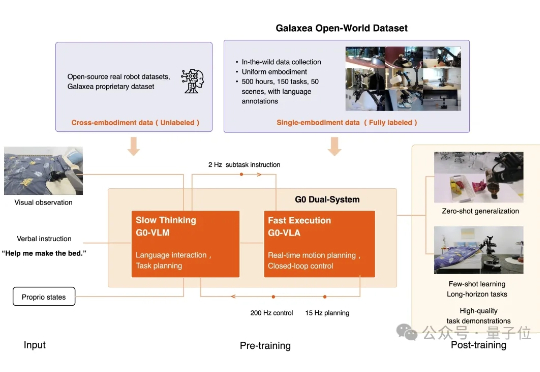

仅凭少量后训练微调,机器人就能完全自主、连续不断地完成床铺整理任务。 而它的每一步思考与动作实时投放在大屏幕上。

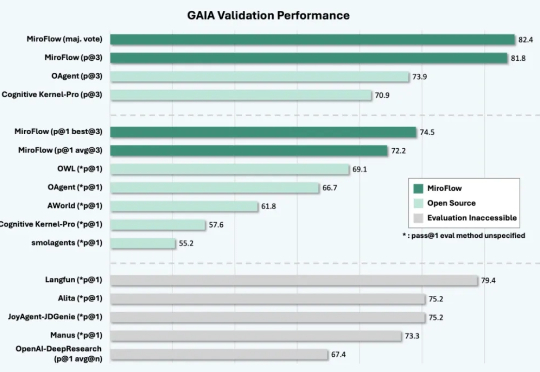

全栈开源生态系统:涵盖Agent框架(MiroFlow)、模型(MiroThinker)、数据(MiroVerse)和训练基础设施(MiroTrain / MiroRL)的全栈开源方案,所有组件和流程均开放共享,便于学习、复用与二次开发。

九天基础大模型3.0震撼发布!在2025世界人工智能大会上,九天基础大模型端到端技术全面升级

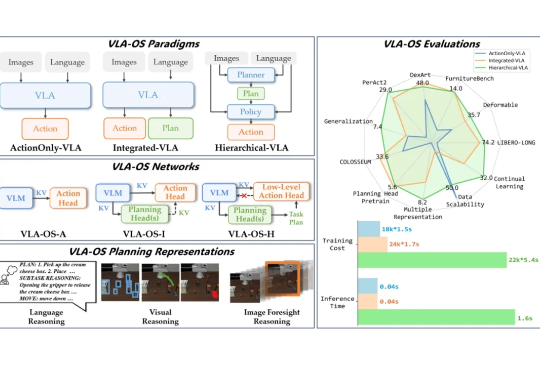

为什么机器人能听懂指令却做不对动作?语言大模型指挥机器人,真的是最优解吗?端到端的范式到底是不是通向 AGI 的唯一道路?这些问题背后,藏着机器智能的未来密码。

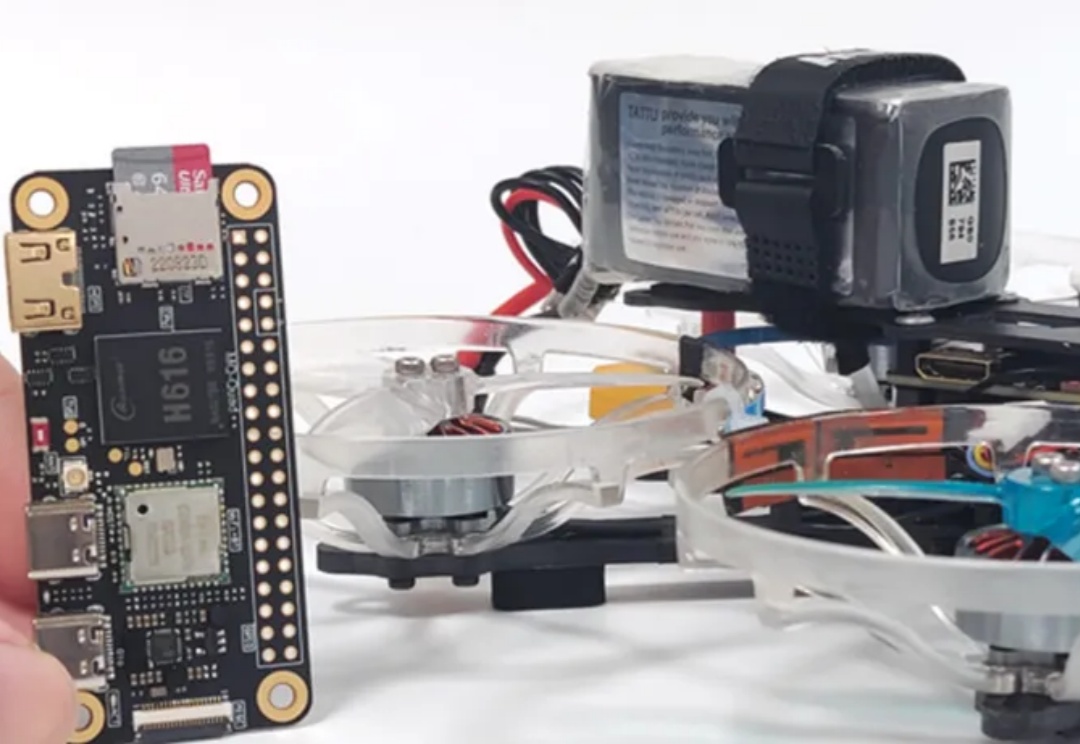

上海交通大学研究团队提出了一种融合无人机物理建模与深度学习的端到端方法,实现了轻量、可部署、可协同的无人机集群自主导航方案,其鲁棒性和机动性大幅领先现有方案。

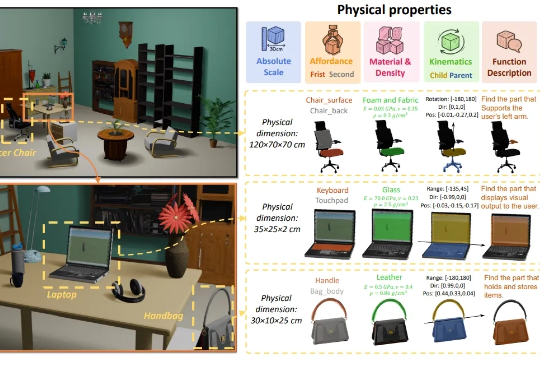

3D生成又补齐了一块重要拼图——物理属性! 南洋理工大学-商汤联合研究中心S-Lab,及上海人工智能实验室合作提出了PhysXNet,号称首个系统性标注的物理基础3D数据集。

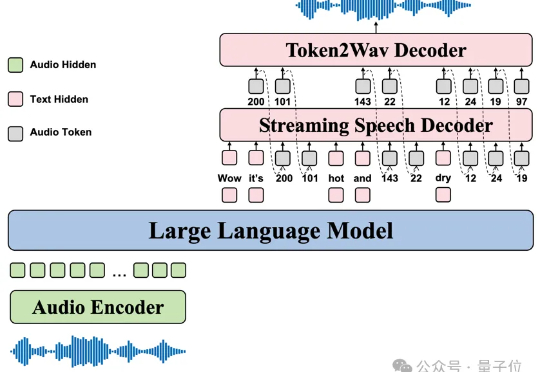

GPT-4o、Gemini这些顶级语音模型虽然展现了惊人的共情对话能力,但它们的技术体系完全闭源。