刚刚,2024诺贝尔物理学奖授予AI教父Geoffrey Hinton、John Hopfield

刚刚,2024诺贝尔物理学奖授予AI教父Geoffrey Hinton、John Hopfield2024年诺贝尔物理学奖揭晓,今年颁给了约翰·霍普菲尔德(John J. Hopfield)和图灵奖得主、AI教父杰弗里·辛顿(Geoffrey E. Hinton),以表彰他们利用人工神经网络进行机器学习的基础发现和发明。

2024年诺贝尔物理学奖揭晓,今年颁给了约翰·霍普菲尔德(John J. Hopfield)和图灵奖得主、AI教父杰弗里·辛顿(Geoffrey E. Hinton),以表彰他们利用人工神经网络进行机器学习的基础发现和发明。

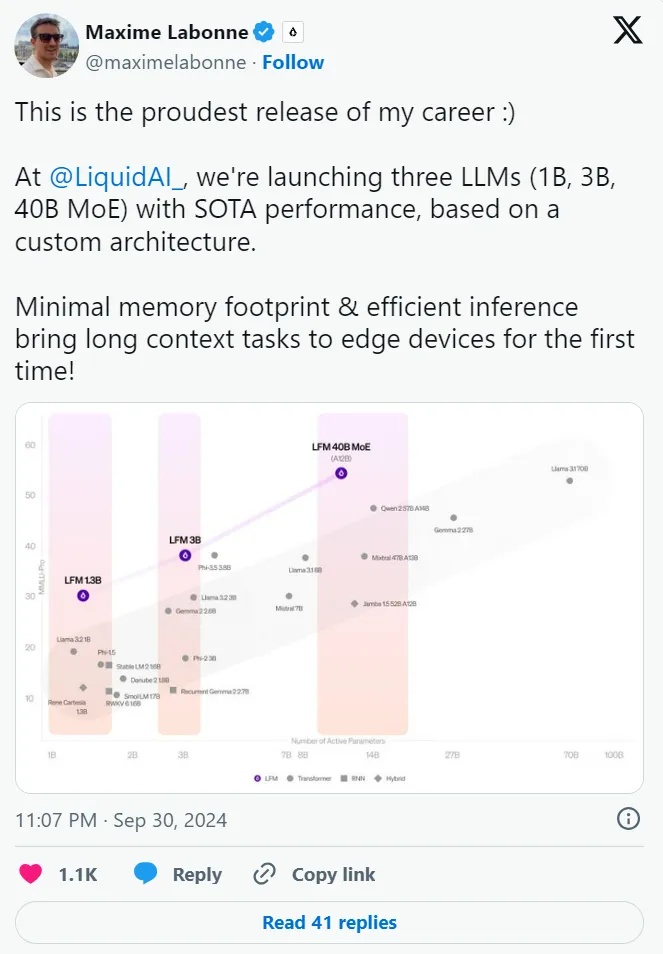

一个受线虫启发的全新架构,三大「杯型」均能实现 SOTA 性能,资源高度受限环境也能部署。移动机器人可能更需要一个虫子的大脑。

中科大成果,拿下图学习“世界杯”单项冠军! 由中科大王杰教授团队(MIRA Lab)提出的首个具有最优性保证的大语言模型和图神经网络分离训练框架,在国际顶级图学习标准OGB(Open Graph Benchmark)挑战赛的蛋白质功能预测任务上斩获「第一名」,该纪录从2023年9月27日起保持至今。

Sutton 等研究人员近期在《Nature》上发表的研究《Loss of Plasticity in Deep Continual Learning》揭示了一个重要发现:在持续学习环境中,标准深度学习方法的表现竟不及浅层网络。研究指出,这一现象的主要原因是 "可塑性损失"(Plasticity Loss):深度神经网络在面对非平稳的训练目标持续更新时,会逐渐丧失从新数据中学习的能力。

DeepMind最近的研究提出了一种新框架AligNet,通过模拟人类判断来训练教师模型,并将类人结构迁移到预训练的视觉基础模型中,从而提高模型在多种任务上的表现,增强了模型的泛化性和鲁棒性,为实现更类人的人工智能系统铺平了道路。

KAN的诞生,开启了机器学习的新纪元!而这背后,竟是MIT华人科学家最先提出的实践想法。从KAN到KAN 2.0,这个替代MLP全新架构正在打开神经网络的黑盒,为下一步科学发现打开速通之门。

复杂的神经网络被 AI 揭开。

基于图神经网络的方法被广泛应用于不同问题并且显著推动了相关领域的进步,包括但不限于数据挖掘、计算机视觉和自然语言处理。考虑到图神经网络已经取得了丰硕的成果,一篇全面且详细的综述可以帮助相关研究人员掌握近年来计算机视觉中基于图神经网络的方法的进展,以及从现有论文中总结经验和产生新的想法。

DeepMind联合帝国理工学院的学者,专注于用神经网络方法对量子力学中经典的薛定谔方程进行近似求解。继2020年提出FermiNet后,团队的最新成果——求解量子激发态,登上Science。

人工神经网络、深度学习方法和反向传播算法构成了现代机器学习和人工智能的基础。但现有方法往往是一个阶段更新网络权重,另一个阶段在使用或评估网络时权重保持不变。这与许多需要持续学习的应用程序形成鲜明对比。