基于昇腾算力突破AI求解,最高加速100倍!| 华为GTS&深圳市大数据研究院

基于昇腾算力突破AI求解,最高加速100倍!| 华为GTS&深圳市大数据研究院基于昇腾算力的矩阵运算改进求解器框架,大幅提升Local Optimum跳出能力。

基于昇腾算力的矩阵运算改进求解器框架,大幅提升Local Optimum跳出能力。

近日,95后初创公司AID Lab团队宣布完成了数百万天使+轮融资,本轮融资由室内设计领域头部上市公司矩阵纵横(矩阵股份:301365)领投。

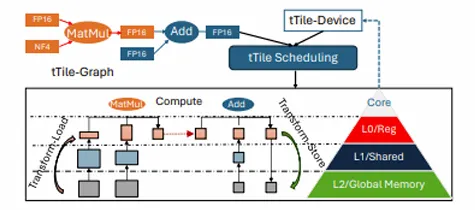

在现代 AI 模型的快速迭代中,如何在保持模型精度的同时提升计算效率成为关键课题。尤其在大规模 AI 推理中,非结构化稀疏矩阵的计算效率低下成为难以突破的瓶颈。面对这一挑战,我们自主研发了 CROSS—— 一种创新的端到端稀疏编译优化方案,为 AI 推理带来细粒度稀疏计算的加速效果。

Tech星球独家获悉,快手已先行在App Store上线了“可灵AI”独立APP,加码在移动端的AI创作布局。产品侧方面,快手“可灵AI”已形成了网页版、APP、小程序、海外版等多端跨平台的产品矩阵。

大模型热,企业落地难?就在刚刚,百川智能推出「1+3」产品矩阵,一站式解决大模型商业化难题。「系列优质通用数据+领域增强训练工具链」,仅需10分钟就能让企业自主成为模型定制增强专家,实现行业最佳的多场景可用率。

最近一张用AI批量做号的微信截图流传在各个群里,有人自爆用AI在小红书做了一个庞大的虚假账号矩阵,通过售卖账号进行变现。

在人工智能领域,模型参数的增多往往意味着性能的提升。但随着模型规模的扩大,其对终端设备的算力与内存需求也日益增加。低比特量化技术,由于可以大幅降低存储和计算成本并提升推理效率,已成为实现大模型在资源受限设备上高效运行的关键技术之一。然而,如果硬件设备不支持低比特量化后的数据模式,那么低比特量化的优势将无法发挥。

T-MAC是一种创新的基于查找表(LUT)的方法,专为在CPU上高效执行低比特大型语言模型(LLMs)推理而设计,无需权重反量化,支持混合精度矩阵乘法(mpGEMM),显著降低了推理开销并提升了计算速度。

暗壳AI由矩阵纵横孵化,现开启新一轮融资。

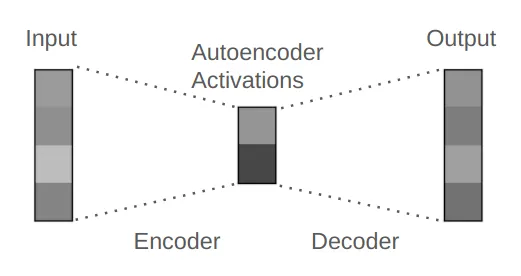

简而言之:矩阵 → ReLU 激活 → 矩阵