技术Blog-4 | 新一代InfLLM:可训练的稀疏注意力机制

技术Blog-4 | 新一代InfLLM:可训练的稀疏注意力机制本文深入剖析 MiniCPM4 采用的稀疏注意力结构 InfLLM v2。作为新一代基于 Transformer 架构的语言模型,MiniCPM4 在处理长序列时展现出令人瞩目的效率提升。传统Transformer的稠密注意力机制在面对长上下文时面临着计算开销迅速上升的趋势,这在实际应用中造成了难以逾越的性能瓶颈。

本文深入剖析 MiniCPM4 采用的稀疏注意力结构 InfLLM v2。作为新一代基于 Transformer 架构的语言模型,MiniCPM4 在处理长序列时展现出令人瞩目的效率提升。传统Transformer的稠密注意力机制在面对长上下文时面临着计算开销迅速上升的趋势,这在实际应用中造成了难以逾越的性能瓶颈。

视觉注意力机制,又有新突破,来自香港大学和英伟达。

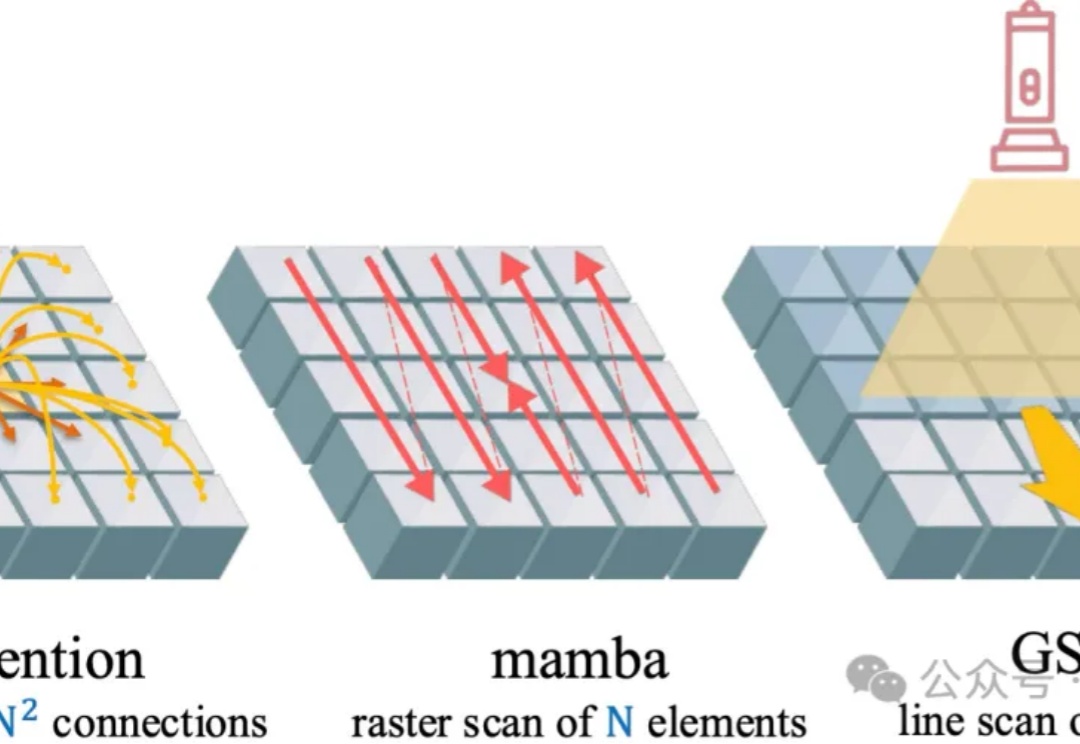

在大语言模型蓬勃发展的背景下,Transformer 架构依然是不可替代的核心组件。尽管其自注意力机制存在计算复杂度为二次方的问题,成为众多研究试图突破的重点

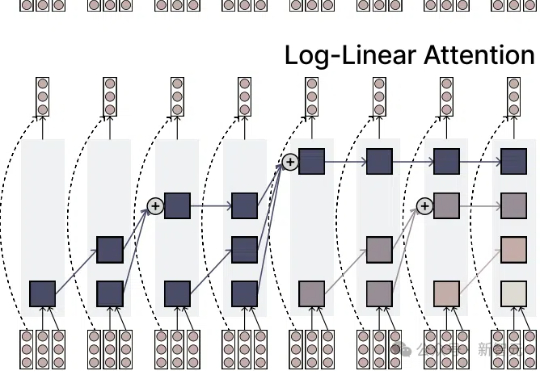

注意力机制的「平方枷锁」,再次被撬开!一招Fenwick树分段,用掩码矩阵,让注意力焕发对数级效率。更厉害的是,它无缝对接线性注意力家族,Mamba-2、DeltaNet 全员提速,跑分全面开花。长序列处理迈入log时代!

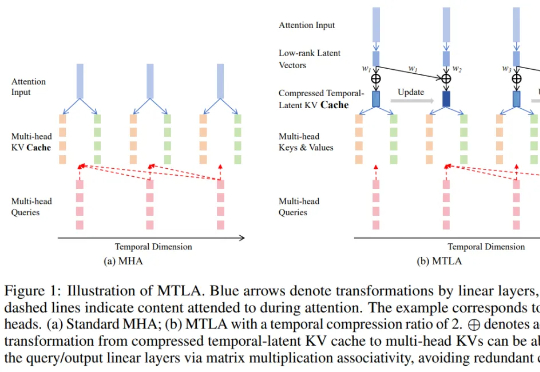

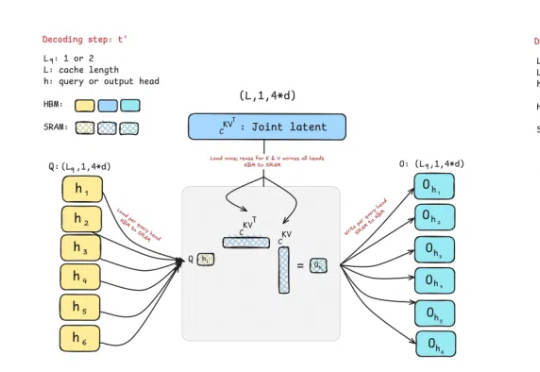

曾撼动Transformer统治地位的Mamba作者之一Tri Dao,刚刚带来新作——提出两种专为推理“量身定制”的注意力机制。

研究者针对 few-shot 图像编辑提出一个新的自回归模型结构 ——InstaManip,并创新性地提出分组自注意力机制(group self-attention),在此任务上取得了优异的效果。

北大DeepSeek联合发布的NSA论文,目前已被ACL 2025录用并获得了极高评分,甚至有望冲击最佳论文奖。该技术颠覆传统注意力机制,实现算力效率飞跃,被誉为长文本处理的革命性突破。

最近,人们对AI谈得最多的是deepseek(简称DS)。这匹来自中国本土的黑马,闯入全球视野,一度扰乱美国股市,在 AI 领域掀起了一场轩然大波。

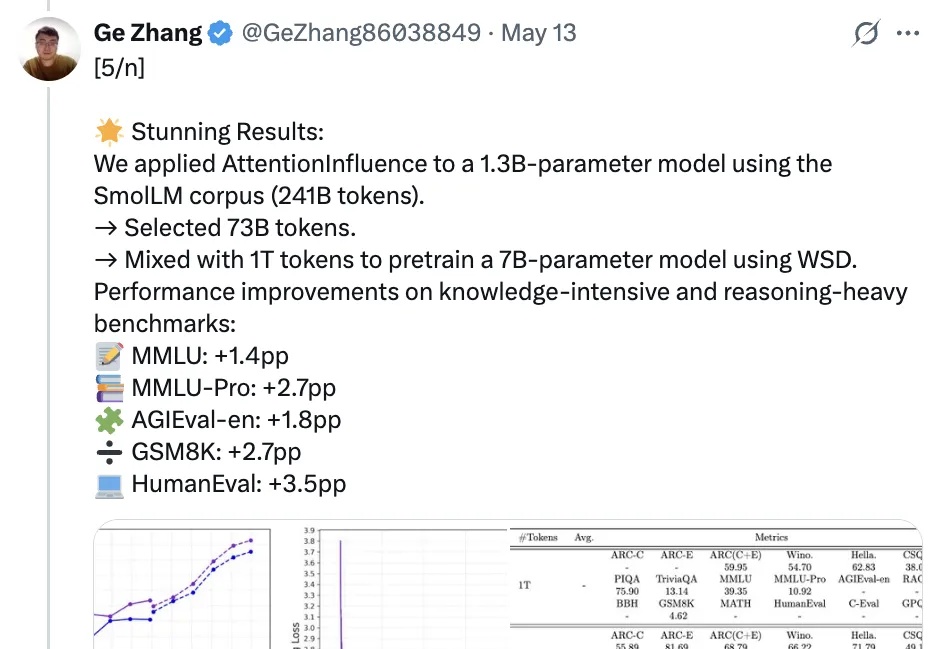

和人工标记数据说拜拜,利用预训练语言模型中的注意力机制就能选择可激发推理能力的训练数据!

大型语言模型(LLMs)在上下文知识理解方面取得了令人瞩目的成功。