清华、哈工大把大模型压缩到了1bit,把大模型放在手机里跑的愿望就快要实现了!

清华、哈工大把大模型压缩到了1bit,把大模型放在手机里跑的愿望就快要实现了!近期,清华大学和哈尔滨工业大学联合发布了一篇论文:把大模型压缩到 1.0073 个比特时,仍然能使其保持约 83% 的性能!

近期,清华大学和哈尔滨工业大学联合发布了一篇论文:把大模型压缩到 1.0073 个比特时,仍然能使其保持约 83% 的性能!

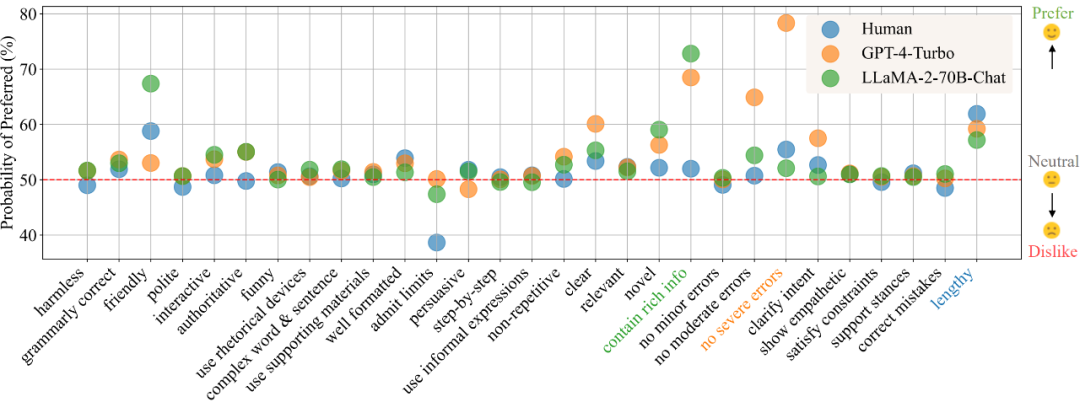

在目前的模型训练范式中,偏好数据的的获取与使用已经成为了不可或缺的一环。在训练中,偏好数据通常被用作对齐(alignment)时的训练优化目标,如基于人类或 AI 反馈的强化学习(RLHF/RLAIF)或者直接偏好优化(DPO),而在模型评估中,由于任务的复杂性且通常没有标准答案,则通常直接以人类标注者或高性能大模型(LLM-as-a-Judge)的偏好标注作为评判标准。

GPT早已成为大模型时代的基础。国外一位开发者发布了一篇实践指南,仅用60行代码构建GPT。

本文提出了扩散模型中UNet的long skip connection的scaling操作可以有助于模型稳定训练的分析,目前已被NeurIPS 2023录用。同时,该分析还可以解释扩散模型中常用但未知原理的1/√2 scaling操作能加速训练的现象。

根据 OpenAI 披露的技术报告,Sora 的核心技术点之一是将视觉数据转化为 patch 的统一表征形式,并通过 Transformer 和扩散模型结合,展现了卓越的扩展(scale)特性。

Reddit和OpenAI及谷歌,竟有着如此错综复杂的关系?最近,Reddit和谷歌双双官宣了一项6000万美元的合作协议,Reddit的数据将帮助谷歌训练AI模型。巧的是,Altman正是Reddit股东之一。

随着大语言模型(LLMs)在近年来取得显著进展,它们的能力日益增强,进而引发了一个关键的问题:如何确保他们与人类价值观对齐,从而避免潜在的社会负面影响?

大模型的成功很大程度上要归因于 Scaling Law 的存在,这一定律量化了模型性能与训练数据规模、模型架构等设计要素之间的关系,为模型开发、资源分配和选择合适的训练数据提供了宝贵的指导。

AAAI 2024 奖项陆续公布,继杰出论文奖后,今天博士论文奖也公布了。

扩散模型,迎来了一项重大新应用——像Sora生成视频一样,给神经网络生成参数,直接打入了AI的底层!