新架构Mamba更新二代!作者:别争了,数学上Transformer和SSM是一回事

新架构Mamba更新二代!作者:别争了,数学上Transformer和SSM是一回事Transformer挑战者、新架构Mamba,刚刚更新了第二代:

Transformer挑战者、新架构Mamba,刚刚更新了第二代:

在开源社区引起「海啸」的Mamba架构,再次卷土重来!这次,Mamba-2顺利拿下ICML。通过统一SSM和注意力机制,Transformer和SSM直接成了「一家亲」,Mamba-2这是要一统江湖了?

一般而言,训练神经网络耗费的计算量越大,其性能就越好。在扩大计算规模时,必须要做个决定:是增多模型参数量还是提升数据集大小 —— 必须在固定的计算预算下权衡此两项因素。

如何突破 Transformer 的 Attention 机制?中国科学院大学与鹏城国家实验室提出基于热传导的视觉表征模型 vHeat。将图片特征块视为热源,并通过预测热传导率、以物理学热传导原理提取图像特征。相比于基于Attention机制的视觉模型, vHeat 同时兼顾了:计算复杂度(1.5次方)、全局感受野、物理可解释性。

Scaling law发展到最后,可能每个人都站在一个数据孤岛上。

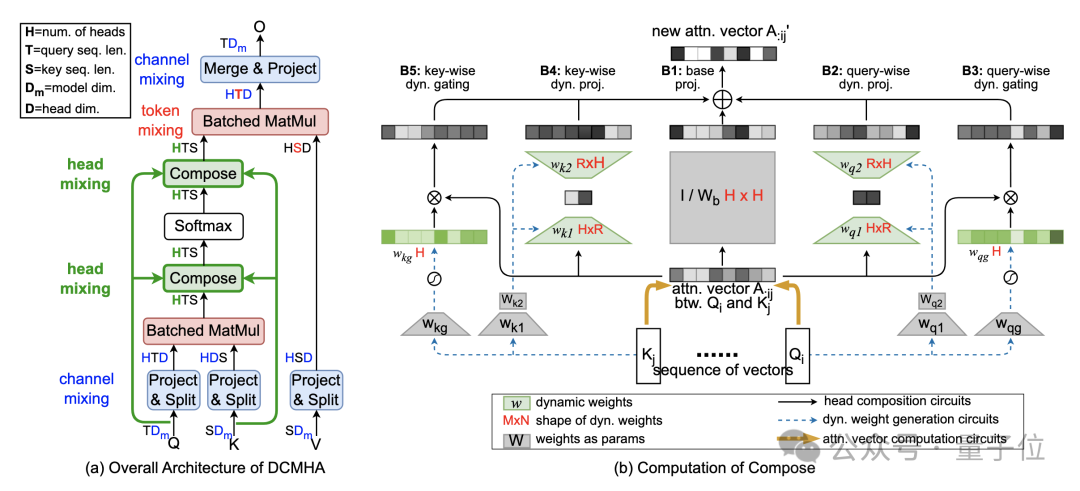

改进Transformer核心机制注意力,让小模型能打两倍大的模型!

研究人员提出了一种新的大型语言模型训练方法,通过一次性预测多个未来tokens来提高样本效率和模型性能,在代码和自然语言生成任务上均表现出显著优势,且不会增加训练时间,推理速度还能提升至三倍。

3D 重建和新视图合成技术在虚拟现实和增强现实等领域有着广泛的应用。NeRF 通过隐式地将场景编码为辐射场,在视图合成上取得了显著的成功。

最近的一系列研究表明,纯解码器生成模型可以通过训练利用下一个 token 预测生成有用的表征,从而成功地生成多种模态(如音频、图像或状态 - 动作序列)的新序列,从文本、蛋白质、音频到图像,甚至是状态序列。

John Schulman 是 OpenAI 联合创始人、研究科学家(OpenAI 现存最主要具有技术背景的创始人),他领导了 ChatGPT 项目,在 OpenAI 内部长期负责模型 post-traning,在 Ilya 和 Jan Leike 离开 OpenAI 后,下一代模型安全性风险相关的研究也会由 John Schulman 来接替负责。