AI训练数据之困:垃圾进,垃圾出

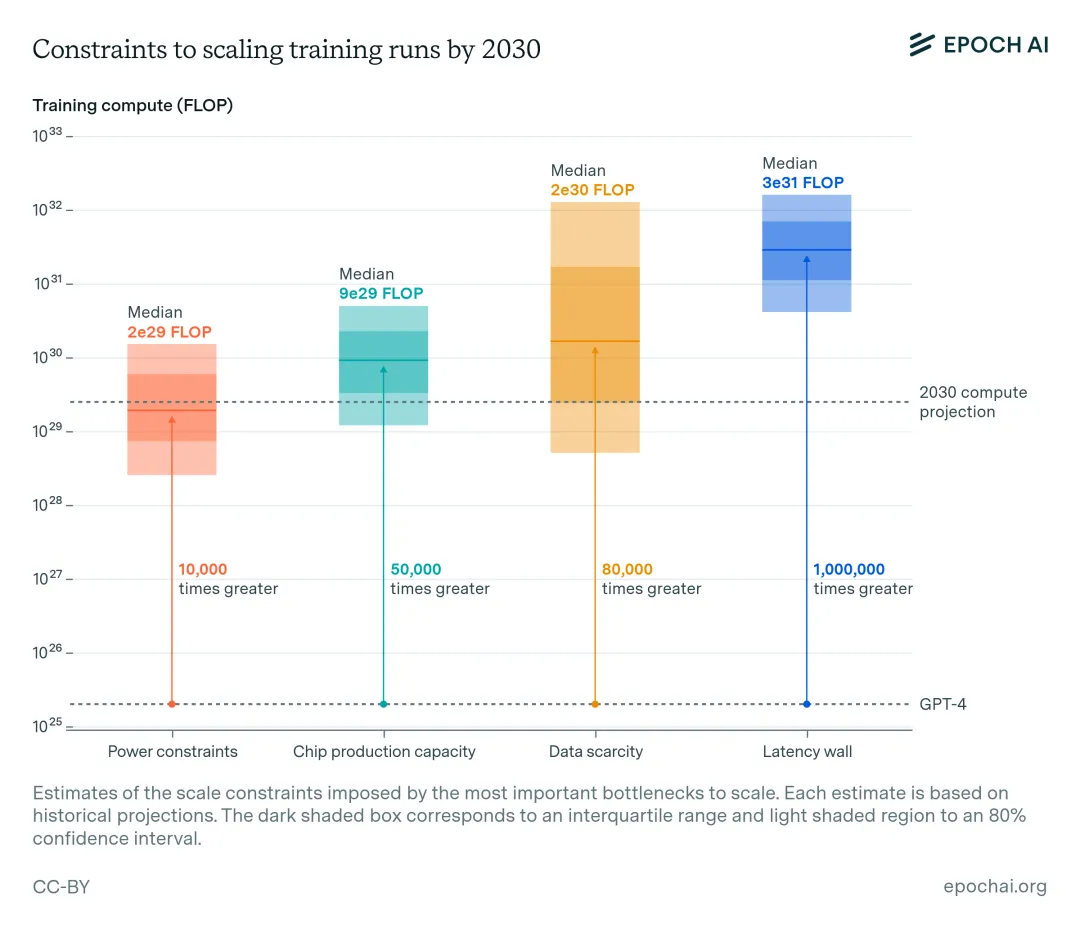

AI训练数据之困:垃圾进,垃圾出所有模型都是通过在来自互联网的海量数据上进行训练来工作的,然而,随着人工智能越来越多地被用来生成充满垃圾信息的网页,这一过程可能会受到威胁。

所有模型都是通过在来自互联网的海量数据上进行训练来工作的,然而,随着人工智能越来越多地被用来生成充满垃圾信息的网页,这一过程可能会受到威胁。

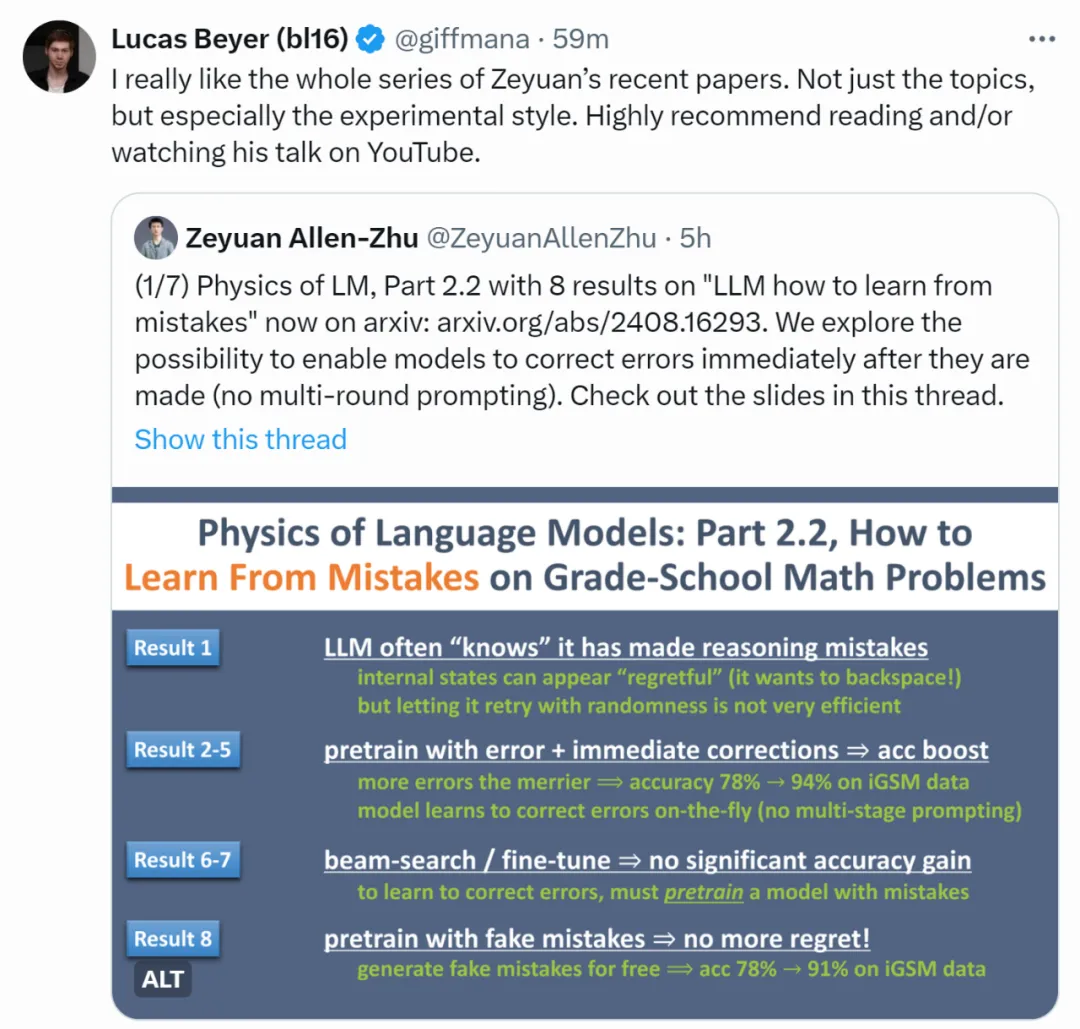

即便是最强大的语言模型(LLM),仍会偶尔出现推理错误。除了通过提示词让模型进行不太可靠的多轮自我纠错外,有没有更系统的方法解决这一问题呢?

今年4月,中科院、滑铁卢大学等机构联合发表了一篇AI行业论文,让互联网上的“乐子人”直呼离谱。

9 月 2 日,马斯克发文称,其人工智能公司 xAI 的团队上线了一台被称为「Colossus」的训练集群,总共有 100000 个英伟达的 H100 GPU。

近日,上海交通大学、上海人工智能实验室和上海交通大学附属瑞金医院联合团队发布基于异常检测预训练的心电长尾诊断模型。

免训练多模态分割领域有了新突破!

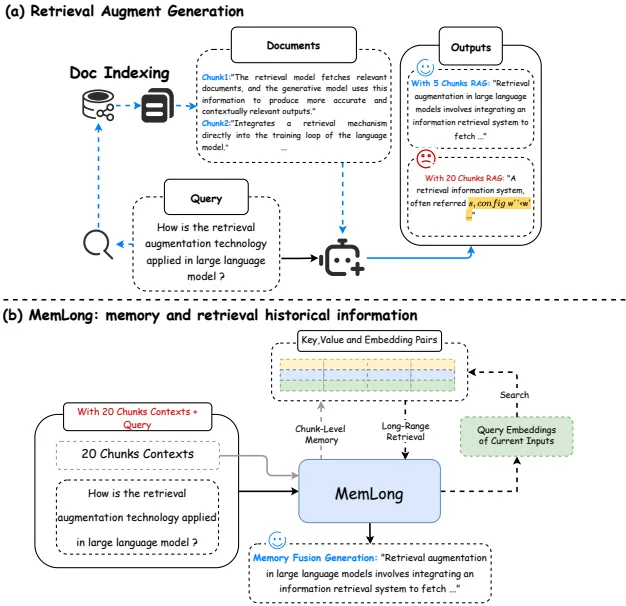

视频理解仍然是计算机视觉和人工智能领域的一个主要挑战。最近在视频理解上的许多进展都是通过端到端地训练多模态大语言模型实现的[1,2,3]。然而,当这些模型处理较长的视频时,内存消耗可能会显著增加,甚至变得难以承受,并且自注意力机制有时可能难以捕捉长程关系 [4]。这些问题阻碍了将端到端模型进一步应用于视频理解。

近日,由北京大学人工智能研究院杨耀东课题组牵头完成的研究成果 ——「大规模多智能体系统的高效强化学习」在人工智能顶级学术期刊 Nature Machine Intelligence 上发表。

在未来,太空 AI 算力或许要比地球上功率最大的还要大。

这篇文章介绍了一个名为MemLong的模型,它通过使用外部检索器来增强长文本建模的能力。