「小模型」有更多机会点

「小模型」有更多机会点大厂为什么追求大模型? 昨天有提到,为什么要研究语言模型。

大厂为什么追求大模型? 昨天有提到,为什么要研究语言模型。

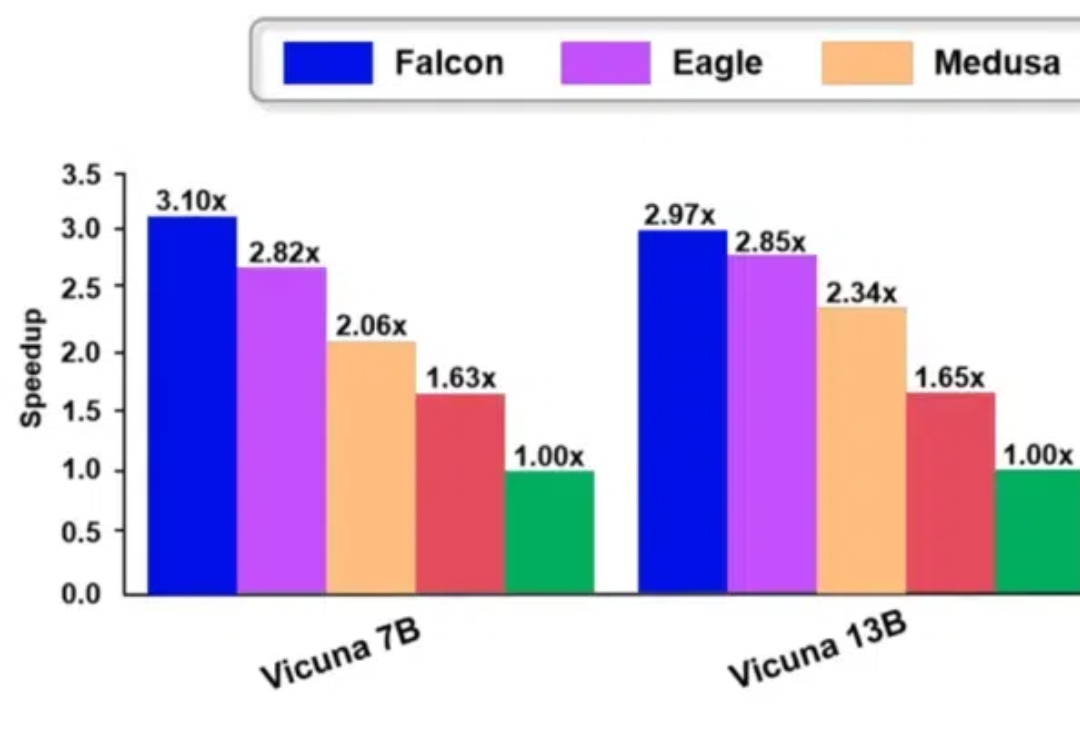

Falcon 方法是一种增强半自回归投机解码框架,旨在增强 draft model 的并行性和输出质量,以有效提升大模型的推理速度。Falcon 可以实现约 2.91-3.51 倍的加速比,在多种数据集上获得了很好的结果,并已应用到翼支付多个实际业务中。

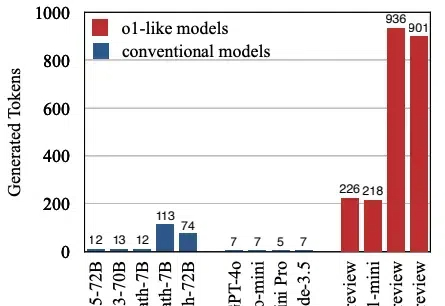

本文将介绍首个关于 o1 类长思维链模型过度思考现象。该工作由腾讯 AI Lab 与上海交通大学团队共同完成。

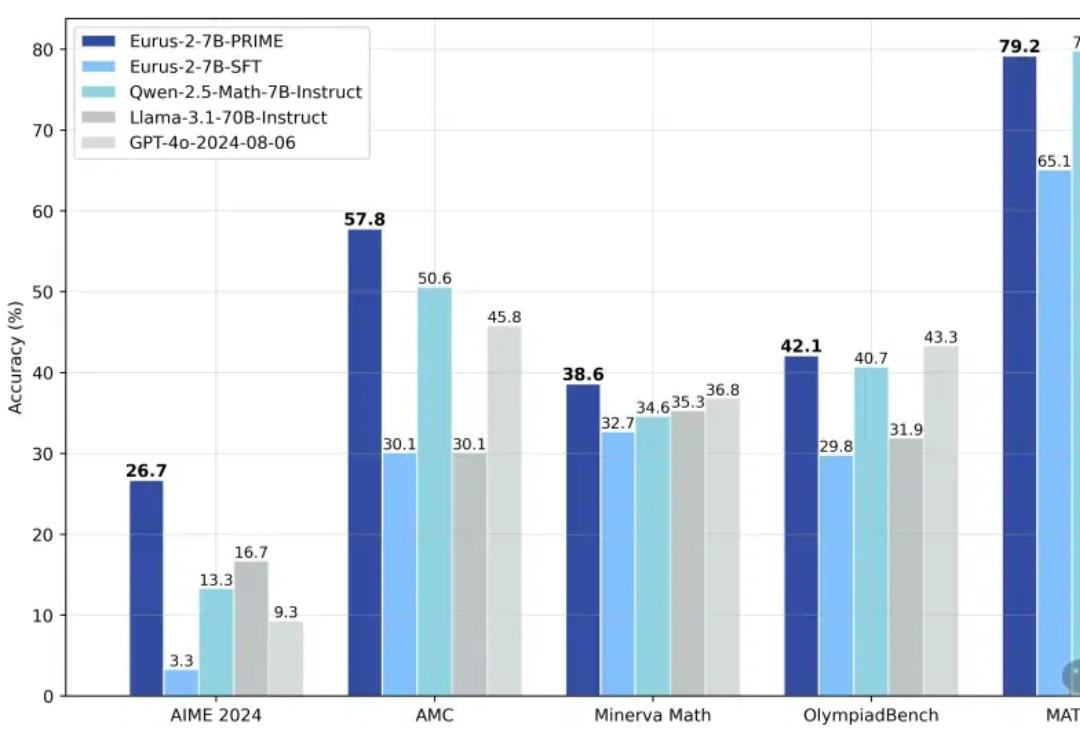

1/10训练数据激发高级推理能力!近日,来自清华的研究者提出了PRIME,通过隐式奖励来进行过程强化,提高了语言模型的推理能力,超越了SFT以及蒸馏等方法。

陈丹琦团队又带着他们的降本大法来了—— 数据砍掉三分之一,大模型性能却完全不减。 他们引入了元数据,加速了大模型预训练的同时,也不增加单独的计算开销。

Meta提出大概念模型,抛弃token,采用更高级别的「概念」在句子嵌入空间上建模,彻底摆脱语言和模态对模型的制约。

流媒体平台爱奇艺已向上海市徐汇区人民法院正式提起诉讼,指控国内AI初创企业MiniMax在AI模型训练及内容生成流程中,涉嫌侵犯其版权,导致生成的内容构成了对爱奇艺版权的侵犯。

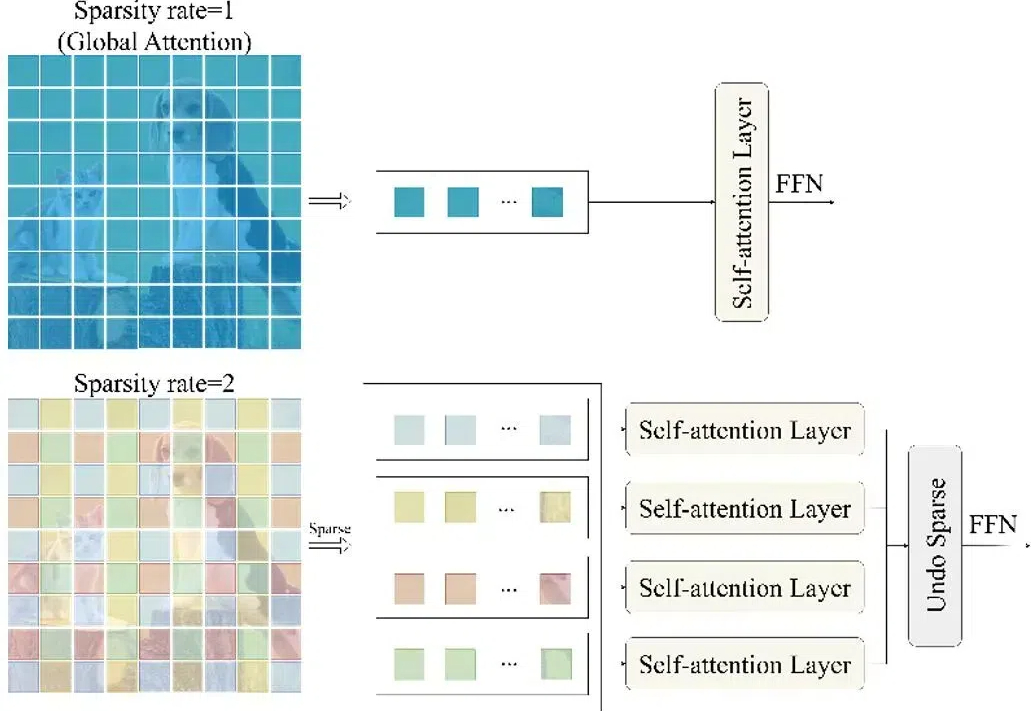

随着图像编辑工具和图像生成技术的快速发展,图像处理变得非常方便。然而图像在经过处理后不可避免的会留下伪影(操作痕迹),这些伪影可分为语义和非语义特征。

OpenAI o1和o3模型的发布证明了强化学习能够让大模型拥有像人一样的快速迭代试错、深度思考的高阶推理能力,在基于模仿学习的Scaling Law逐渐受到质疑的今天,基于探索的强化学习有望带来新的Scaling Law。

2020年2月,数据标注员作为人工智能训练师的一个工种,被正式纳入国家职业分类目录。短短几年,这个劳动力需求量巨大的行业,迅速在一些中小城市落地生根。