只要9美元!LoRA+强化学习,DeepSeek 1.5B推理性能暴涨20%

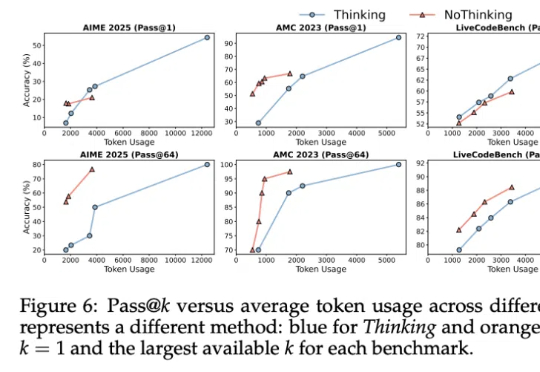

只要9美元!LoRA+强化学习,DeepSeek 1.5B推理性能暴涨20%南加州大学团队只用9美元,就能在数学基准测试AIME 24上实现超过20%的推理性能提升,效果好得离谱!而其核心技术只需LoRA+强化学习,用极简路径实现超高性价比后训练。

南加州大学团队只用9美元,就能在数学基准测试AIME 24上实现超过20%的推理性能提升,效果好得离谱!而其核心技术只需LoRA+强化学习,用极简路径实现超高性价比后训练。

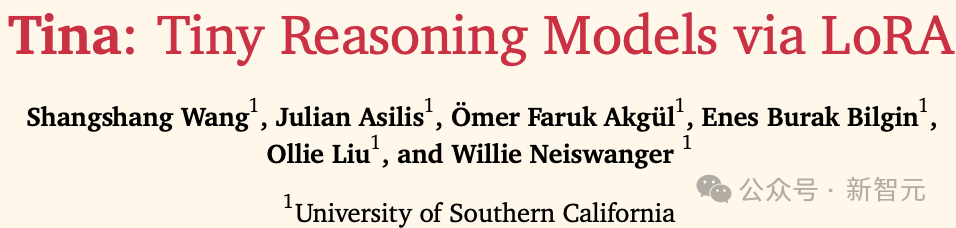

LoRA 中到底存在多少参数冗余?这篇创新研究介绍了 LoRI 技术,它证明即使大幅减少 LoRA 的可训练参数,模型性能依然保持强劲。

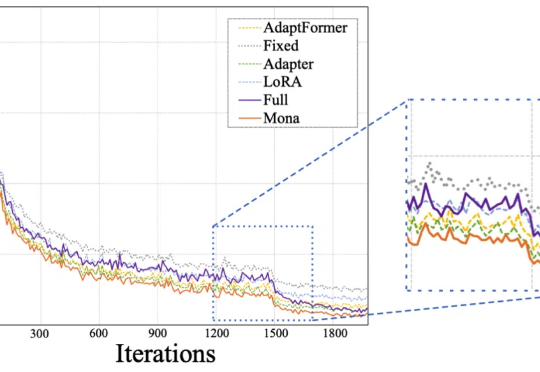

Mona(Multi-cognitive Visual Adapter)是一种新型视觉适配器微调方法,旨在打破传统全参数微调(full fine-tuning)在视觉识别任务中的性能瓶颈。

现如今,微调和强化学习等后训练技术已经成为提升 LLM 能力的重要关键。

其实……不用大段大段思考,推理模型也能有效推理!

来自英伟达和UIUC的华人团队提出一种高效训练方法,将LLM上下文长度从128K扩展至惊人的400万token SOTA纪录!基于Llama3.1-Instruct打造的UltraLong-8B模型,不仅在长上下文基准测试中表现卓越,还在标准任务中保持顶尖竞争力。

这就是为什么数据被称作"新石油"或"新黄金"——它极其珍贵,因为算法的一切认知都来源于输入的数据。

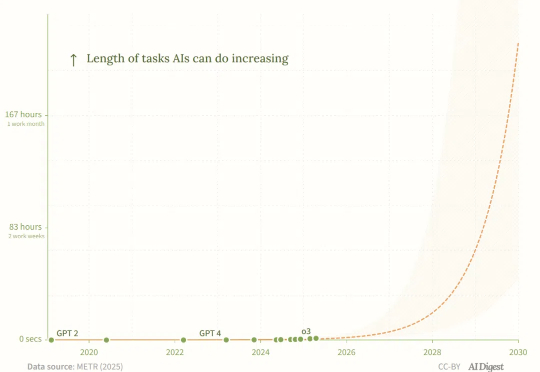

AI编程智能体的能力正在飞速增长,最新研究揭示了这一「新摩尔定律」,如果AI智能体的任务时长继续以每4个月翻倍的速度增长,到2027年它们可能完成长达167小时的月级任务!

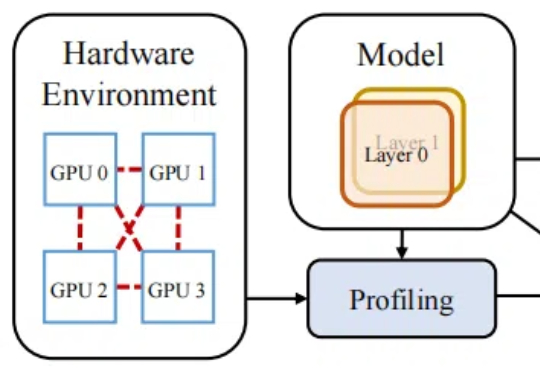

训练成本高昂已经成为大模型和人工智能可持续发展的主要障碍之一。

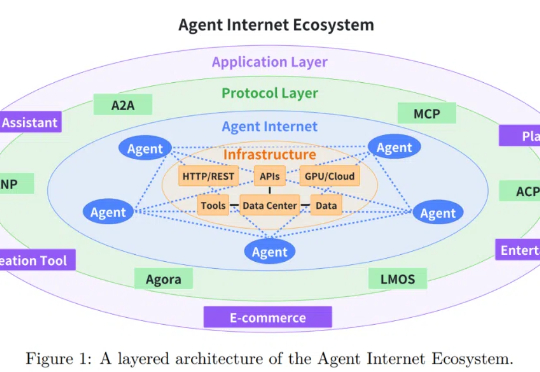

随着大语言模型 (LLM) 技术的迅猛发展,基于 LLM 的智能智能体在客户服务、内容创作、数据分析甚至医疗辅助等多个行业领域得到广泛应用。