大模型压缩KV缓存新突破,中科大提出自适应预算分配,工业界已落地vLLM框架

大模型压缩KV缓存新突破,中科大提出自适应预算分配,工业界已落地vLLM框架改进KV缓存压缩,大模型推理显存瓶颈迎来新突破—— 中科大研究团队提出Ada-KV,通过自适应预算分配算法来优化KV缓存的驱逐过程,以提高推理效率。

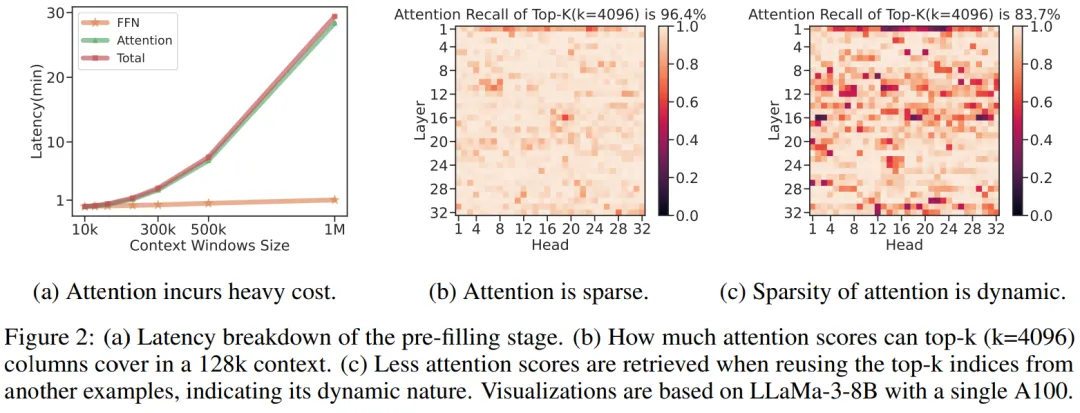

改进KV缓存压缩,大模型推理显存瓶颈迎来新突破—— 中科大研究团队提出Ada-KV,通过自适应预算分配算法来优化KV缓存的驱逐过程,以提高推理效率。

AI coding 是模型推理能力增加之后的下一个竞争高地,除了模型厂商、AI Labs 之外,这个领域的参与者也有着 Cursor 这样的初创团队。

牛顿没解决的问题,AI给你解决了? AI的推理能力一直是研究的焦点。作为最纯粹、要求最高的推理形式之一,能否解决高级的数学问题,无疑是衡量语言模型推理水平的一把尺。

PPIO推出新AI产品,助力分布式云计算及AIGC应用。

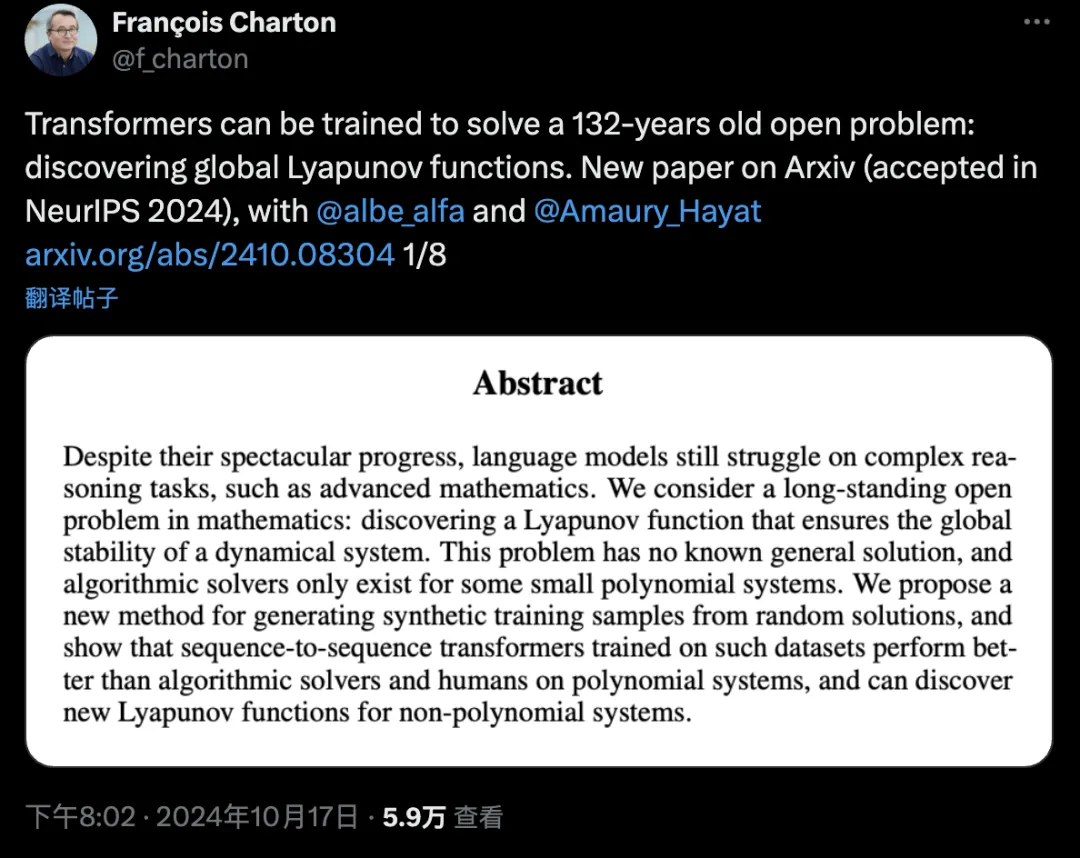

KV Cache 是大模型推理性能优化的一个常用技术,该技术可以在不影响任何计算精度的前提下,通过空间换时间的思想,提高推理性能。

8月27日消息,在近日召开的Hot Chips 2024大会上,韩国AI芯片初创公司FuriosaAI 推出了一款面向高性能大型语言模型和多模态模型推理的高能效数据中心AI加速器 RNGD。

2024年,落地,无疑是大模型最重要的主题。

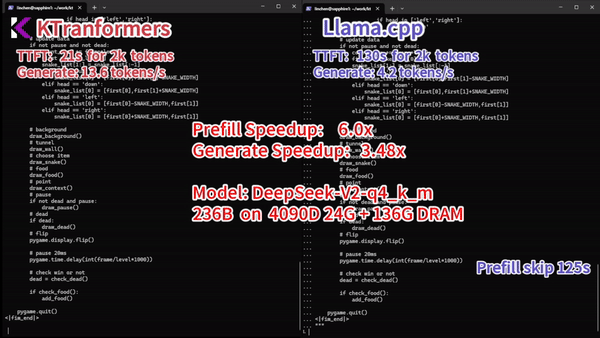

千亿参数规模的大模型推理,服务器仅用4颗CPU就能实现!

最近,新加坡国立大学联合南洋理工大学和哈工深的研究人员共同提出了一个全新的视频推理框架,这也是首次大模型推理社区提出的面向视频的思维链框架(Video-of-Thought, VoT)。视频思维链VoT让视频多模态大语言模型在复杂视频的理解和推理性能上大幅提升。该工作已被ICML 2024录用为Oral paper。

微软的这项研究让开发者可以在单卡机器上以 10 倍的速度处理超过 1M 的输入文本。