手机可跑,3.8B参数量超越GPT-3.5!微软发布Phi-3技术报告:秘密武器是洗干净数据

手机可跑,3.8B参数量超越GPT-3.5!微软发布Phi-3技术报告:秘密武器是洗干净数据过去几年,借助Scaling Laws的魔力,预训练的数据集不断增大,使得大模型的参数量也可以越做越大,从五年前的数十亿参数已经成长到今天的万亿级,在各个自然语言处理任务上的性能也越来越好。

过去几年,借助Scaling Laws的魔力,预训练的数据集不断增大,使得大模型的参数量也可以越做越大,从五年前的数十亿参数已经成长到今天的万亿级,在各个自然语言处理任务上的性能也越来越好。

过去一年,AI大模型无疑是科技行业中最亮眼的主角,从FAAMG到BAT、再到一众初创企业,无数优秀的大脑、海量的资源都投入到了这个有望解放人类生产力的赛道中。

Meta最近开源的Llama 3模型再次证明了「数据」是提升性能的关键,但现状是,开源的大模型有一堆,可开源的大规模数据却没多少,而收集、清洗数据又是一项极其费时费力的工作,也导致了大模型预训练技术仍然掌握在少数高端机构的手中。

自2021年诞生,CLIP已在计算机视觉识别系统和生成模型上得到了广泛的应用和巨大的成功。我们相信CLIP的创新和成功来自其高质量数据(WIT400M),而非模型或者损失函数本身。虽然3年来CLIP有大量的后续研究,但并未有研究通过对CLIP进行严格的消融实验来了解数据、模型和训练的关系。

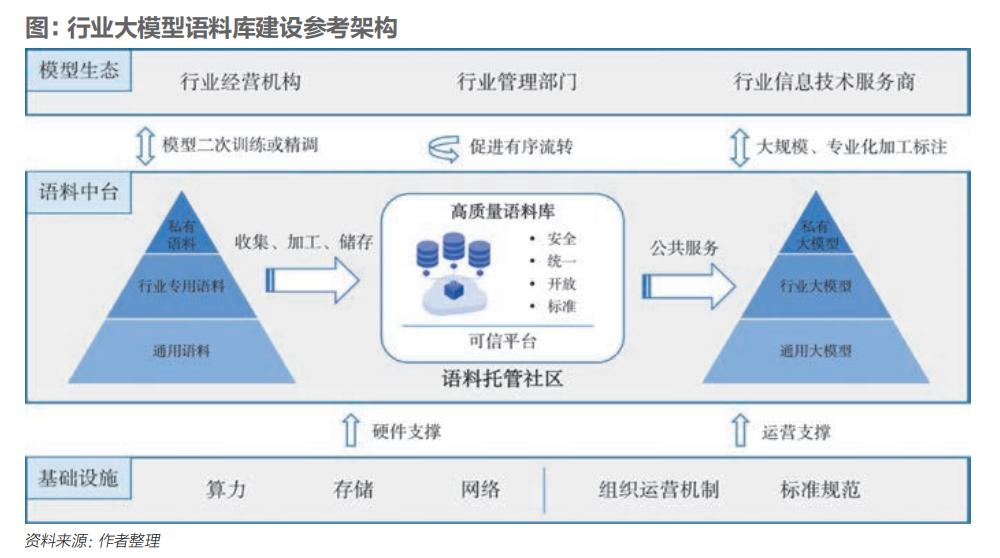

大模型语料是指用于训练和评估大模型的一系列文本、语音或其他模态的数据。

大模型语料是指用于训练和评估大模型的一系列文本、语音或其他模态的数据。语料规模和质量对大模型性能以及应用的深度、广度有着至关重要的影响。

要说 ChatGPT 拉开了大模型竞赛的序幕,那么 Meta 开源 Llama 系列模型则掀起了开源领域的热潮。在这当中,苹果似乎掀起的水花不是很大。

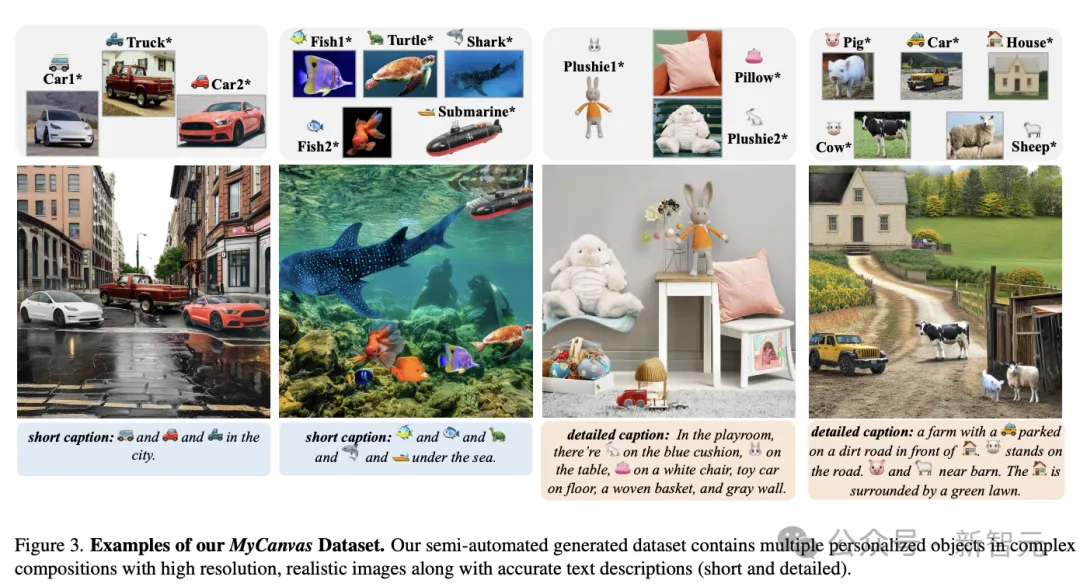

拖动式图像编辑是一种新型的、用户交互式的图像编辑方法。

大家相互薅羊毛,要用,但要小心用,一不小心就尴尬了。 一位国产大模型算法工程师在接受「甲子光年」采访时的吐槽,可以说是非常到位了。 它准确地阐述 AI 业内一个所有人「心照不宣」的公开秘密。

过去几年里,基于文本来生成图像的扩散模型得到了飞速发展,生成能力有了显著的提升,可以很容易地生成逼真的肖像画,以及各种天马行空的奇幻画作。