开源15T tokens!HuggingFace放出规模最大、质量最高预训练数据集

开源15T tokens!HuggingFace放出规模最大、质量最高预训练数据集Meta最近开源的Llama 3模型再次证明了「数据」是提升性能的关键,但现状是,开源的大模型有一堆,可开源的大规模数据却没多少,而收集、清洗数据又是一项极其费时费力的工作,也导致了大模型预训练技术仍然掌握在少数高端机构的手中。

Meta最近开源的Llama 3模型再次证明了「数据」是提升性能的关键,但现状是,开源的大模型有一堆,可开源的大规模数据却没多少,而收集、清洗数据又是一项极其费时费力的工作,也导致了大模型预训练技术仍然掌握在少数高端机构的手中。

近年来,大型语言模型(LLM)在数学应用题和数学定理证明等任务中取得了长足的进步。数学推理需要严格的、形式化的多步推理过程,因此是 LLMs 推理能力进步的关键里程碑, 但仍然面临着重要的挑战。

使用测序 (scATAC-seq) 技术对转座酶可及的染色质进行单细胞测定,可在单细胞分辨率下深入了解基因调控和表观遗传异质性,但由于数据的高维性和极度稀疏性,scATAC-seq 的细胞注释仍然具有挑战性。现有的细胞注释方法大多集中在细胞峰矩阵上,而没有充分利用底层的基因组序列。

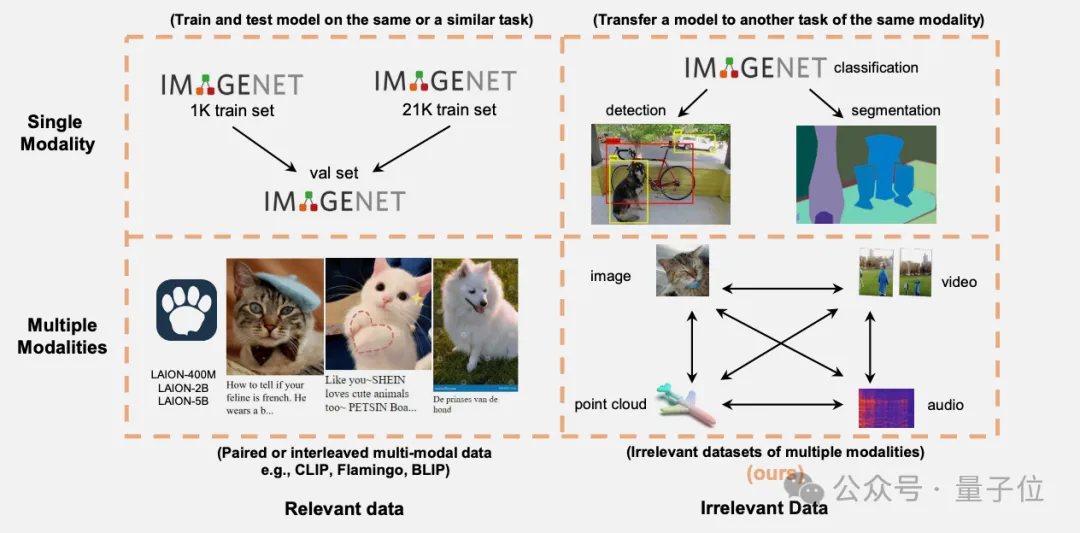

万万没想到,与任务无直接关联的多模态数据也能提升Transformer模型性能。

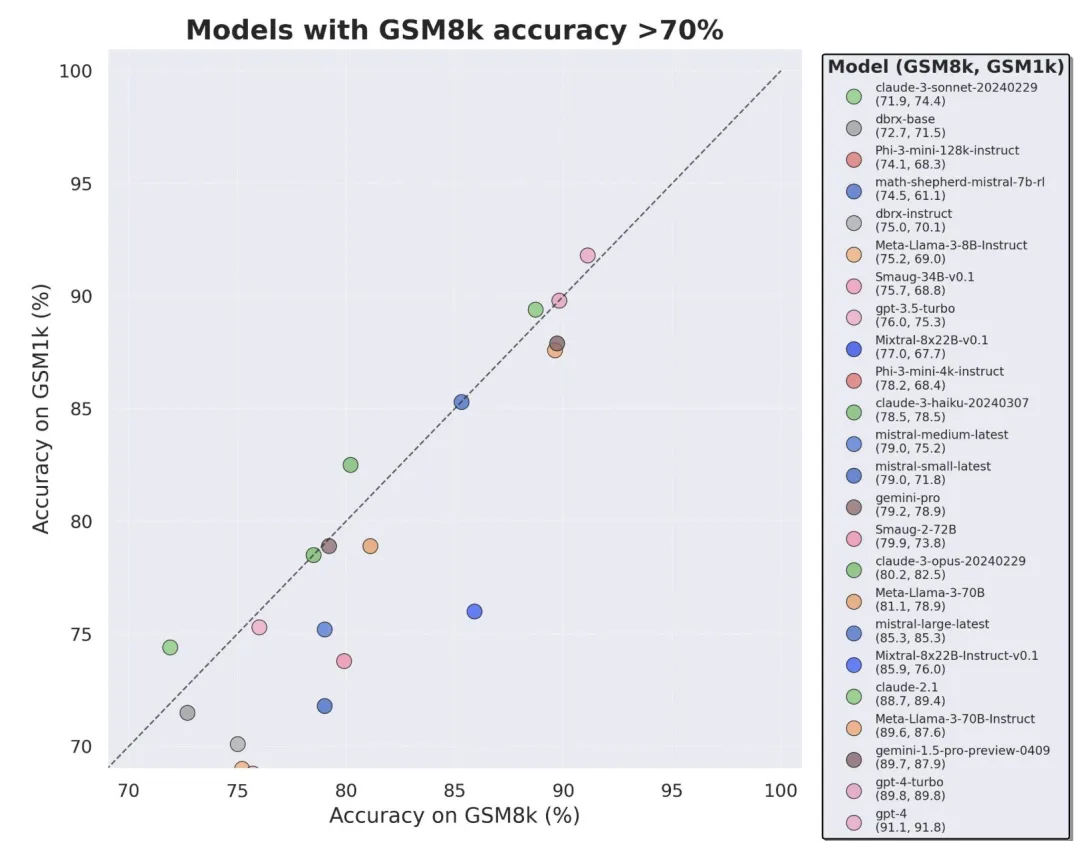

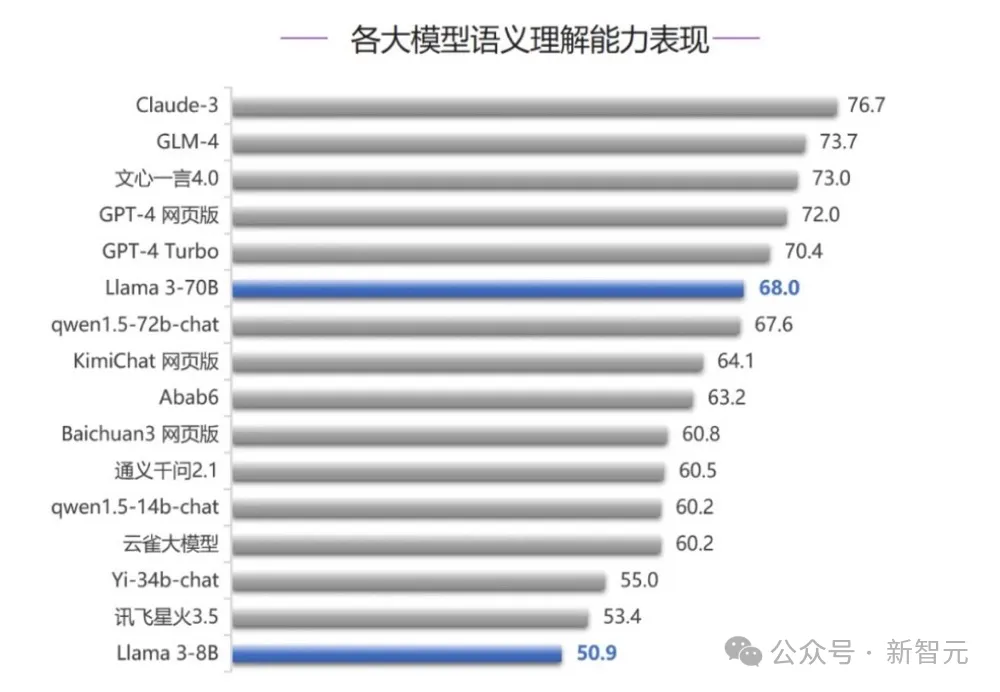

当前最火的大模型,竟然三分之二都存在过拟合问题?

自2021年诞生,CLIP已在计算机视觉识别系统和生成模型上得到了广泛的应用和巨大的成功。我们相信CLIP的创新和成功来自其高质量数据(WIT400M),而非模型或者损失函数本身。虽然3年来CLIP有大量的后续研究,但并未有研究通过对CLIP进行严格的消融实验来了解数据、模型和训练的关系。

就在最近,清华大学SuperBench团队的新一轮全球大模型评测结果出炉了!

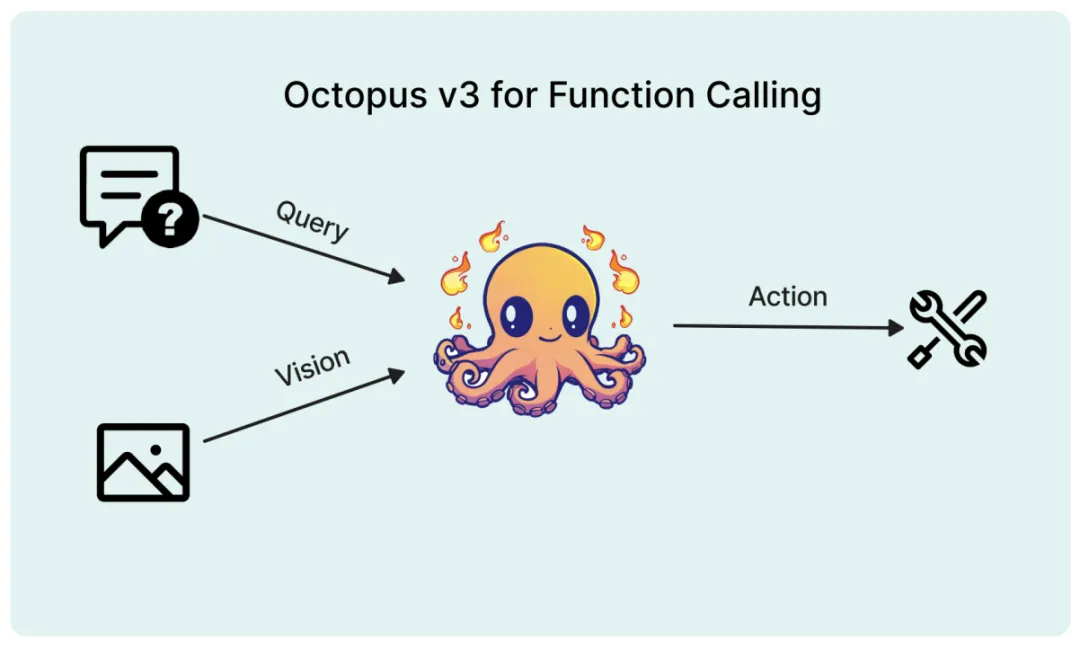

多模态 AI 系统的特点在于能够处理和学习包括自然语言、视觉、音频等各种类型的数据,从而指导其行为决策。近期,将视觉数据纳入大型语言模型 (如 GPT-4V) 的研究取得了重要进展,但如何有效地将图像信息转化为 AI 系统的可执行动作仍面临挑战。

近日,上海交通大学自然科学研究院/物理与天文学院/张江高等研究院洪亮课题组,在生物信息学和人工智能研究领域的国际权威学术期刊JCIM(Journal of Chemical Information and Modeling)上发表最新研究成果

训练模型搞得跟《饥饿游戏》似的,全球AI研究者,都在苦恼怎么才能喂饱这群数据大胃王。