中科大成果斩获图学习“世界杯”单项冠军,霸榜蛋白质功能预测任务超1年 | TPAMI 2024

中科大成果斩获图学习“世界杯”单项冠军,霸榜蛋白质功能预测任务超1年 | TPAMI 2024中科大成果,拿下图学习“世界杯”单项冠军! 由中科大王杰教授团队(MIRA Lab)提出的首个具有最优性保证的大语言模型和图神经网络分离训练框架,在国际顶级图学习标准OGB(Open Graph Benchmark)挑战赛的蛋白质功能预测任务上斩获「第一名」,该纪录从2023年9月27日起保持至今。

中科大成果,拿下图学习“世界杯”单项冠军! 由中科大王杰教授团队(MIRA Lab)提出的首个具有最优性保证的大语言模型和图神经网络分离训练框架,在国际顶级图学习标准OGB(Open Graph Benchmark)挑战赛的蛋白质功能预测任务上斩获「第一名」,该纪录从2023年9月27日起保持至今。

早在20世纪90年代末期,SaaS概念就已经诞生,但直到2010年云计算被广泛采用,SaaS市场才真正开始掀起波澜。从那时起,SaaS行业经历了迅猛的发展。根据Statista的数据,预计到2027年,SaaS行业市场规模将达到3391亿美元。

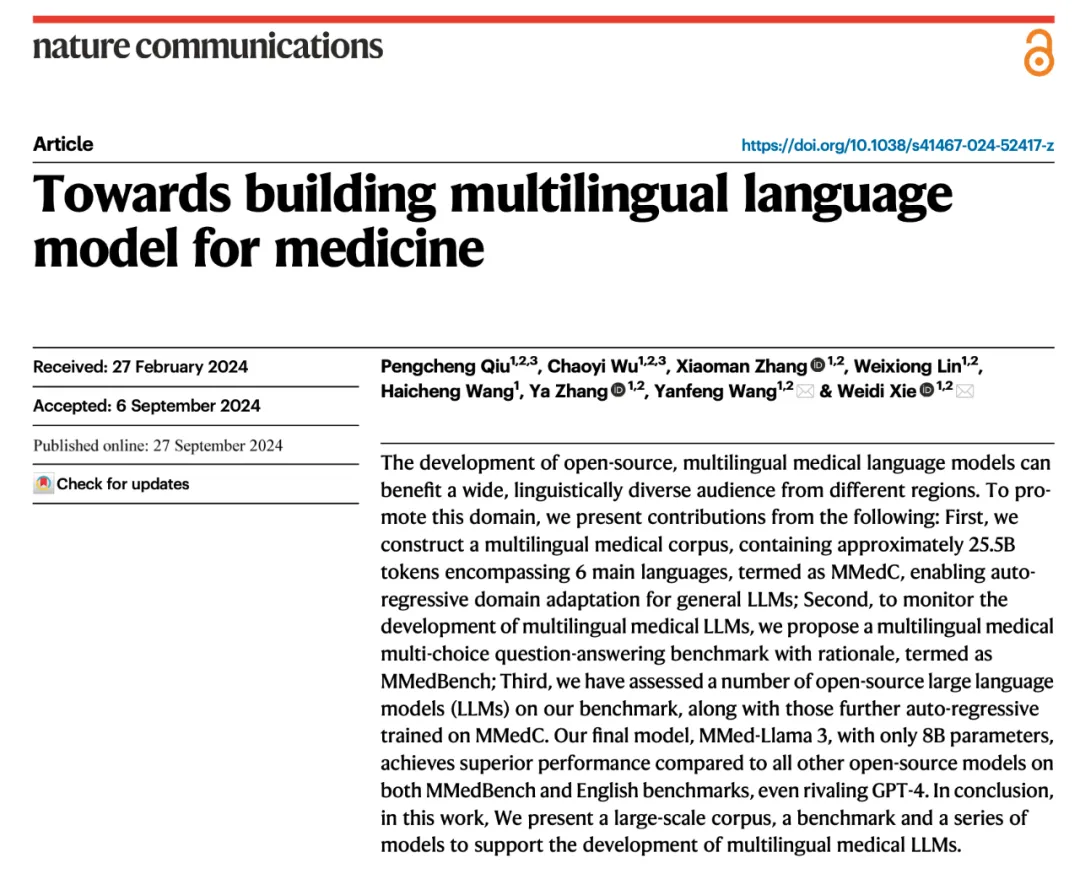

在医疗领域中,大语言模型已经有了广泛的研究。然而,这些进展主要依赖于英语的基座模型,并受制于缺乏多语言医疗专业数据的限制,导致当前的医疗大模型在处理非英语问题时效果不佳。

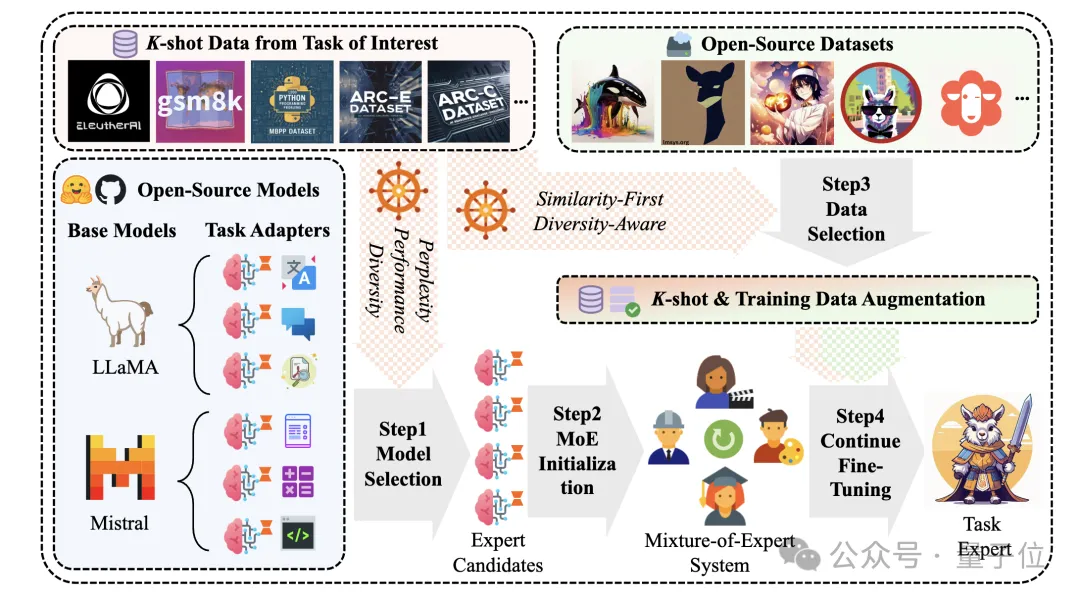

告别传统指令微调,大模型特定任务性能提升有新方法了。 一种新型开源增强知识框架,可以从公开数据中自动提取相关知识,针对性提升任务性能。 与基线和SOTA方法对比,本文方法在各项任务上均取得了更好的性能。

大模型医疗应用还在早期,最大挑战还是在数据的处理上,国内至少还需要两到三年来解决; 创业公司还有机会,只要找到合适的切入点。这个行业只有撑死的,没有饿死的。

《纽约时报》今天披露了很多关于 OpenAI 有意思的数据,根据其查阅的财务文件显示,OpenAI 8 月份的月收入达到 3 亿美元,自 2023 年初以来增长了 1700%,预计今年的年销售额约为 37 亿美元,而明年营收将增至 116 亿美元。

视觉数据的种类极其多样,囊括像素级别的图标到数小时的视频。现有的多模态大语言模型(MLLM)通常将视觉输入进行分辨率的标准化或进行动态切分等操作,以便视觉编码器处理。然而,这些方法对多模态理解并不理想,在处理不同长度的视觉输入时效率较低。

Sutton 等研究人员近期在《Nature》上发表的研究《Loss of Plasticity in Deep Continual Learning》揭示了一个重要发现:在持续学习环境中,标准深度学习方法的表现竟不及浅层网络。研究指出,这一现象的主要原因是 "可塑性损失"(Plasticity Loss):深度神经网络在面对非平稳的训练目标持续更新时,会逐渐丧失从新数据中学习的能力。

Google DeepMind的SCoRe方法通过在线多轮强化学习,显著提升了大型语言模型在没有外部输入的情况下的自我修正能力。该方法在MATH和HumanEval基准测试中,分别将自我修正性能提高了15.6%和9.1%。

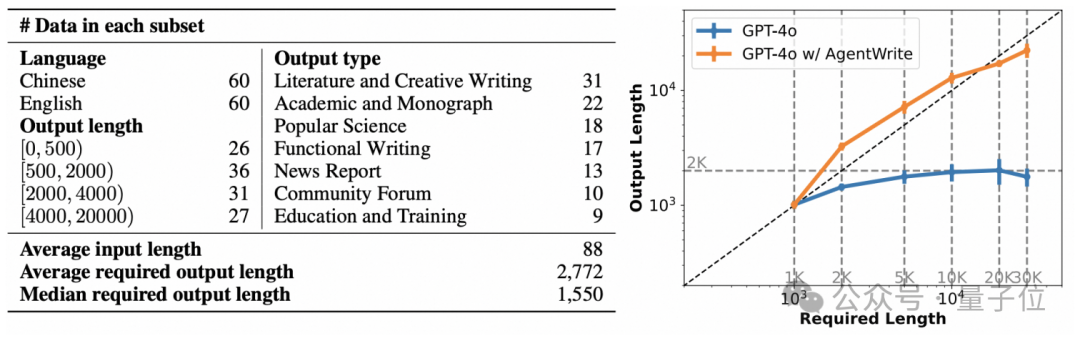

仅需600多条数据,就能训练自己的长输出模型了?!